A Fondo

Computación cuántica: la próxima frontera

La semana pasada os contamos cómo el Consejo Superior de Investigaciones Científicas (CSIC), se convertía en la primera institución de nuestro país en unirse a IBM Q Network, la primera red comercial que permite a organismos investigadores y empresas empezar a experimentar con algunas de las ventajas que proporciona la computación cuántica.

El CSIC consigue de esta forma una conexión directa con el IBM Q System One, el primer ordenador cuántico para uso comercial y que fue presentado por la multinacional americana este mismo año. Entre los objetivos declarados, el insituto español espera encontrar sus primeras aplicaciones en campos como la medicina, la ciencia de los materiales o los nuevos riesgos financieros, entre otros.

La computación cuántica promete inaugurar una nueva era de computación, una en la que utilizando un enfoque aproximativo, podamos encontrar respuestas a problemas que actualmente los mayores centros de datos del mundo se ven incapaces de resolver. ¿De qué forma? ¿En qué principios se basa y qué hay de real en este planteamiento? ¿Qué limitaciones tiene y cómo se están intentando resolver los problemas que plantea? Estas son algunas de las preguntas a las que vamos a intentar dar respuesta.

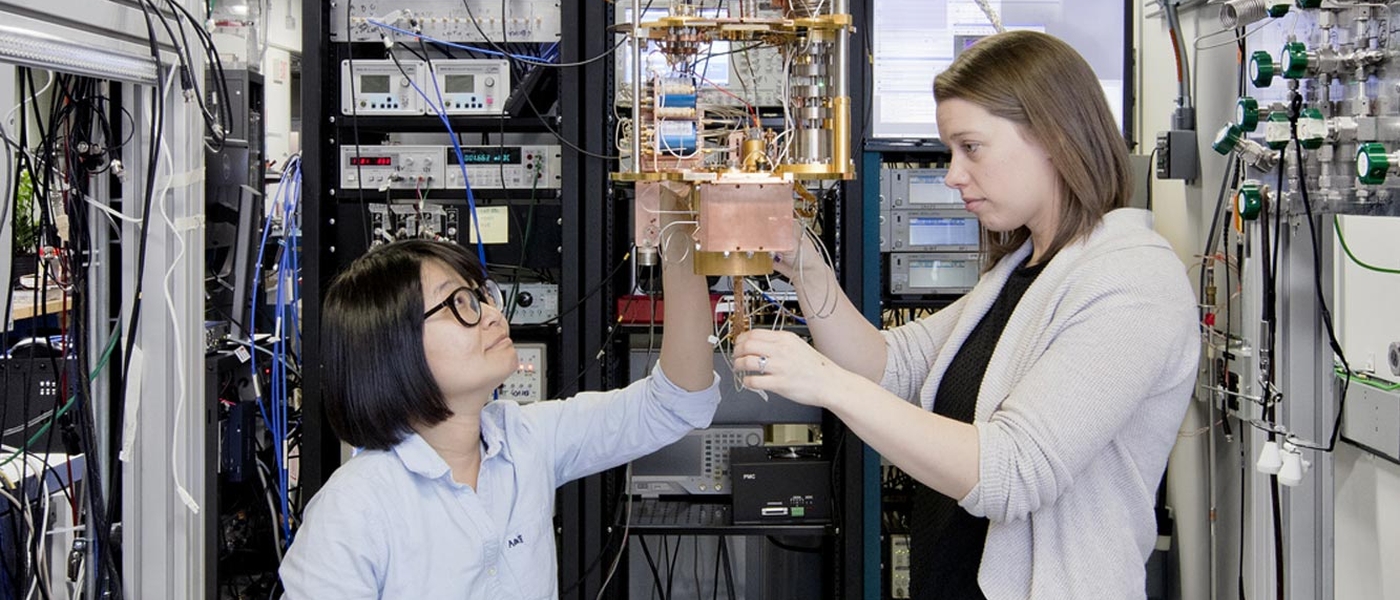

Procesador cuántico Bristlecone (Google)

Computación cuántica: del Bit al Qubit

Aunque la idea de computación cuántica tiene sus orígenes en los años 80, su desarrollo comenzó a acelerarse cuando los investigadores llegan a la conclusión de que la «computación clásica», basada en la producción de microchips cada vez más pequeños con los que mejorar la velocidad a la que se procesan los datos, tiene fecha de caducidad.

¿El problema? Que aunque se pueden llegar a producir chips infinitamente pequeños, cuando se empieza a bajar por la escala de los nanómetros, los electrones que se envían comienzan a «escapar» de los canales por los que deberían de circular, por lo que los chips dejan de funcionar correctamente.

Este es uno de los principales obstáculos a los que de hecho actualmente se enfrentan empresas como Intel y que se ha demostrado en los problemas de producción que la compañía ha experimentado en los últimos años, desafiando los principios establecidos por la Ley de Moore .

¿Hasta dónde se puede llegar en esta escala? Con la tecnología actual, compañías como TSMC prometen fabricar chips de 5 nanómetros y se dice que Samsung podría estar haciendo lo propio con los de cuatro. Más allá de aquí, parece francamente complicado seguir progresando.

¿De qué forma resuelve este problema la computación cuántica? Apostando por una estructura de computación completamente distinta. En vez de trabajar a nivel de voltajes eléctricos, se trabaja a nivel de cuanto. De esta forma, aplicaando los principios propios de la física cuántica, se abre un nuevo mundo de infinitas posibilidades, empezando por las unidades más básicas.

Mientras que en la computación clásica el bit sólo puede tomar dos valores (0 ó 1) en la computación cuántica, el valor que se obtiene puede ser 0, 1 ó 0 y 1 a la vez. ¿Cuál es aquí la principal ventaja? Que a diferencia de la computación digital, en la cuántica, esta superposición de valores permite realizar varias operaciones a la vez, produciendo resultados de forma exponencial. En este escenario ya no hablamos por lo tanto de bits, sino de lo que se ha bautizado como qubits. El número de qubits de una máquina indica el número de bits que pueden estar en superposición y por tanto, su capacidad de cálculo bruto.

La consecuencia de todo lo anterior, es que el número de operaciones que se pueden realizar se multiplica enormemente. Para que os hagáis una idea, un computador cuántico de 20 qubits como el caso del IBM Q, equivale a un ordenador capaz de entregar 10 teraflops. En laboratorio ya se ha conseguido desarrollar equipos de hasta 72 qubits (Google Bristlecone ). ¿Esto es mucho o es poco? ¿En qué momento se potencia se encuentra en estos momentos la computación cuántica?

Por un lado, estos 72 qubits que equivalen a 24 teraflops se quedan por supuesto bastante lejos de los 187 petaflops que actualmente entrega Summit pero hay que tener en cuenta dos grandes diferencias: la primera, que como veremos a continuación la computación cuántica resuelve problemas de forma diferente; la segunda, que mientras que como ya hemos mencionado, la Ley de Moore tiene fecha de caducidad (Intel la sitúa en 2023), la computación cuántica apenas está dando sus primeros pasos.

Una forma diferente de resolver problemas

Como hemos visto hasta ahora, no tiene demasiado sentido comparar la potencia bruta actual de los grandes supercomputadores que forman parte de la lista Top-500 con los mejores exponentes de la computación cuántica. De hecho, la carrera por los petaflops no es a medio plazo el principal objetivo que se marcan los equipos de investigación que están desarrollando este tipo de sistemas.

Esto es debido a que la computación cuántica se enfrenta a los problemas que se le plantean de una forma completamente diferente a la computación digital. Mientras que la segunda no deja de ser una máquina de turing, con las limitaciones que su misma estructura impone, la primera refleja de forma mucho más precisa el «comportamiento de un cerebro humano» por lo que la convierte en una plataforma mucho más adecuada para el desarrollo de redes neuronales y el despliegue de algoritmos de aprendizaje automático.

Así para tareas como entender cómo hablamos los seres humanos, el estudio combinatorio de moléculas para la industria médica, el desarrollo de nuevos modelos climáticos o incluso la resolución de problemas criptográficos lo habitual a medio plazo será recurrir a la computación cuántica.

Dario Gil, vicepresidente de ciencia y tecnología de IBM Research lo explica de la siguiente forma: «Para determinados tipos de problemas (como los criptográficos) la computación cuántica puee resolverlos de una forma exponencialmente más rápida que los ordenadores más potentes del mundo que existen hoy en día. Algo que llevaría años o décadas para que el ordenador más potente lo resolviera, una computadora cuántica puede resolverla en pocos minutos. Esto no quiere decir que sea una solución universal. No resuelve todos los problemas, pero hay patrones de problemas en los que es posible una aceleración exponencial».

Y continúa de esta forma: «Las computadoras de hoy en día han sido diseñadas para ser más o menos como una calculadora. Necesitamos un alto grado de precisión porque los utilizamos para la contabilidad y para todo tipo de cosas que necesitan respuestas exactas. Pero si observamos muchos de los problemas que resuelve un cerebro humano, la exactitud no es su característica principal. Imagina que tienes dos manzanas encima de la mesa. Cualquier persona puede determinar cual es más roja. Y no tiene que determinar de forma exacta en qué grado una es más roja que la otra. Simplemente lo sabe».

Este «saber» es lo que hace única a la computación cuántica y por su propia estructura interna, hasta ahora no ha sido posible desarrollar en la computación digital.

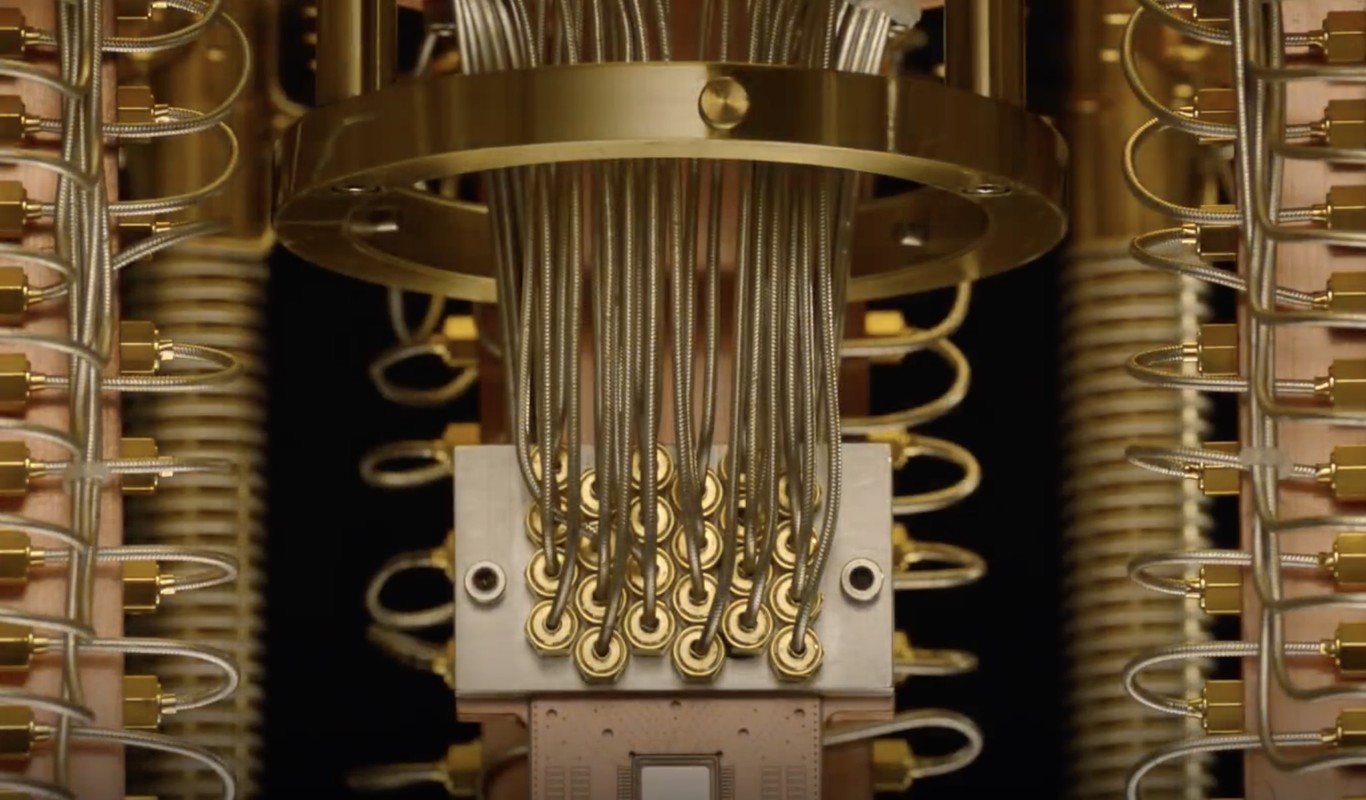

IBM Q se matiene a 273º bajo cero dentro de un cubo de cristal

Así es el «hardware» de una computadora cuántica

Si como hemos visto la estructura interna de un ordenador cuántico es muy diferente a la de un ordenador digital, como no podía ser de otra forma, su hardware también en completamente diferente.

En primer lugar, hay que tener en cuenta que a diferencia de un ordenador «tradicional» el cuántico es tremendamente sensible a cualquier cambio de temperatura, así como a todo tipo de oscilaciones y vibraciones externas.

Como explica el responsable de IBM, aunque teóricamente puede parece sencillo, «en la práctica es muy, muy difícil conseguir que los qubits se superpongan y realicen cálculos conjuntos. Para conseguirlo, tenemos que llevar la temperatura de los qubits hasta el cero absoluto (270 °C bajo cero).

Para conseguir esta temperatura y eliminar además cualquier tipo de vibración, el equipo de IBM se encierra en un enorme cubo de cristal sellado de forma hermética, al únicamente puede accederse por una pequeña puerta en el caso de que sea necesario realizar alguna modificación en el ordenador. Una vez que se «aisla» el ordenador, surge otro reto que no es precisamente menor. Comunicarse con el ordenador.

Interior del IBM Q

«Para la entrada enviamos pulsos de información en forma de microondas, que son las que transmiten el lenguaje de codificación a los qubits. Una vez que los qubits se combinan y producen el resultado, necesitamos extraerlos del ‘refrigerador’ (los resultados) e introducirlos de nuevo en un ordenador ‘convencional’ que los interpreta».

Como reconoce Dario Gil «Todo este proceso puede ser muy engorroso si lo que tenemos que hacer es llevar la contabilidad de una empresa. Pero imeginemos el futuro. En un futuro, gracias a la computación cuántica, las personas podrán hablar directamente con los ordenadores… y a diferencia de ahora, serán capaces de entender cualquier idioma, cualquier dilecto, cualquier acento. Por primera vez las personas serán comprendidas por una máquina. Problemas que ahora mismo computacionalmente son prohibitivos, se convertirán en un juego de niños».

Hasta que este futuro llega, de momento equipos como el IBM Q se mantienen encerrados en sus laboratorios. De hecho, el momento en que las empresas puedan comenzar a trabajar con ellos más alla de hacerlo a través de una conexión cloud, se antoja lejano. Hasta entonces, redes inteligentes como esta IBM Q Network o la nueva Quantum Network de Microsoft seguirán siendo la única forma de hacerlo.

-

NoticiasHace 5 días

NoticiasHace 5 díasHuawei muestra su potencial para empresas y cloud en España en el Digital Transformation Summit

-

A FondoHace 6 días

A FondoHace 6 díasCómo asegurarse de que se puede restaurar una copia de seguridad

-

NoticiasHace 6 días

NoticiasHace 6 díasLG Gram Pro, portátiles ligeros preparados para la IA

-

A FondoHace 6 días

A FondoHace 6 díasSalesforce lleva la IA de Slack a todos los planes de pago de la plataforma