Noticias

Diez momentos destacados de Tecnología en 2015

Vamos cerrando el año con otro repaso a los momentos más destacados de la Tecnología en 2015. Como en el recopilatorio de Ciencia en 2015, seleccionamos entre los cientos de artículos que hemos publicado a lo largo del año, el contenido que más ha gustado entre nuestros lectores -con amplio debate en algunos-, lo más interesante, innovador o importante para el futuro. Esperamos que te guste.

Las ferias tecnológicas más importantes del año

Arrancamos recordando lo que dieron de sí las ferias de tecnología y electrónica más importantes del año. Eventos que muestran el resultado práctico en todo tipo de productos de la tecnología e inventiva mundial. Estas ferias marcan el calendario de toda la tecnología de consumo para el año en curso y donde se producen importantes acuerdos para distribuirlos.

Destacamos el CES 2015 (la primera gran feria del año y seguramente la más importante del mundo), el IFA 2015 (la feria de tecnología y electrónica de consumo más importante de Europa), el CeBIT 2015 (epicentro de la tecnología profesional), el Computex 2015 (la feria más importante de Asia) o el MWC 2015 (el congreso mundial del móvil).

Supercomputadora contra el cerebro humano

Un proyecto de investigación confirmó la potencia de esa impresionante obra de ingeniería que es el cerebro humano, cuya complejidad estamos lejos de conocer y quizá se logre en la próxima década cuando esté disponible la próxima generación de supermáquinas conocidas bajo computación exascale.

El proyecto multidisciplinar de los centros de investigación japonés Riken y el alemán Jülich, tiene por objetivo poner a prueba los límites en tecnologías de simulación y las capacidades del supercomputador K, el cuarto más potente del planeta con 10,5 TFlops/s, gracias a 705.000 núcleos de procesamiento SPARC64 VIIIfx 8C a 2 GHz y 1,4 millones de Gbytes de RAM.

Se trata de la mayor simulación de redes neuronales realizada hasta la fecha. Para ello se utiliza la herramienta de código abierto Neural Simulation Technology (NEST) que replica una red que consta de miles de millones de células nerviosas y una cantidad ingente de sinapsis.

Los resultados mostraron la complejidad del cerebro humano ya que el supercomputador K necesitó 40 minutos para simular un segundo de actividad cerebral. Y eso que se trataba de replicar una red neuronal de solo un 1 por ciento del tamaño real del cerebro humano.

Al hilo de este tema, comentar que una doctora ha propuesto desarrollar un ordenador que pueda recrear los 100 trillones de conexiones que tiene el cerebro humano. De esta forma sería posible “existir” para siempre en un programa informático reproducido dentro de dicho ordenador, tras «descargar» toda una conciencia humana, una vida, una esencia en una máquina como si fuera un simple software y mantener esa “vida” dentro de la misma. ¿Una locura?

Alta tecnología en medicina

La alta tecnología aplicada a la ciencia médica nos ha regalado este año un montón de nuevos avances y es un campo espectacular a explorar que nos permitirá vivir más y mejor en el futuro, aunque sea a base de implantes, prótesis, chips y todo lo que llegue de la robótica.

Uno de los avances fue conseguido por un grupo de científicos de la Case Western Reserve University, consiguiendo que un paciente con parálisis pueda volver a mover su brazo. Esto ha sido posible gracias a la utilización de un implante cerebral de pequeño tamaño que trabaja sobre la base de las propias señales de su cerebro, ya que lee las ondas cerebrales que emanan del cortex motor y las convierte en señales eléctricas interpretables que se transmiten de forma inalámbrica a otro implante, compuesto de 16 filamentos y situado en su brazo que se encarga de generar los impulsos eléctricos que mueven la musculatura del mismo.

También conocimos un nuevo chip que simula perfectamente el latido cardíaco. Desarrollado por el Biointerfaces Institute y el Michigan Center for Integrative Research Critical Care este chip utiliza un complejo sistema de canales activados por la propia gravedad, condensadores e interruptores que pueden hacer que el líquido fluya a través de él con una variedad de ritmos y pulsaciones casi infinita. Su funcionamiento es parecido al de un chip convencional, pero utiliza líquidos en lugar de electricidad y cuenta con un proceso de fabricación basado en fotolitografía combinada que permite moldear el chip de un trozo de silicio con un coste de apenas unos centavos de dólar.

Otra novedad la presentó el Laboratorio de Física Aplicada de la Universidad John Hopkins, tras crear y probar con éxito un sistema que permite a una persona amputada manejar brazos protésicos con su cerebro. Esto ha permitido a un hombre llamado Leslie Baugh volver a sentir que tiene brazos, convirtiéndose en la primera persona amputada a nivel de los hombros del mundo en usar estos dispositivos.

La clínica Mayo ha presentado el caso de un hombre invidente que ha recuperado la visión gracias a unos ojos biónicos conectados a gafas inteligentes. Los médicos emplearon un ensayo clínico utilizando un sistema llamado Second Sight que ha logrado que el paciente tenga la capacidad de ver y distinguir formas humanas e incluso su propio reflejo en una ventana. Para lograrlo, los médicos conectaron 60 electrodos en los ojos que interactúan con unas gafas inteligentes y un mini-computador en forma de wearable, enviando señales al nervio óptico sin pasar por la retina dañada.

Por último, señalar los avances del programa Vanishing Programmable Resources de DARPA. Un programa que desarrolla chip con capacidades de autodestrucción para la industria militar, pero también chips electrónicos “degradables” que en futuro podrán ser utilizados y reabsorbidos por el cuerpo humano una vez hayan cumplido su misión contra el cáncer, para medicamentos o implantología.

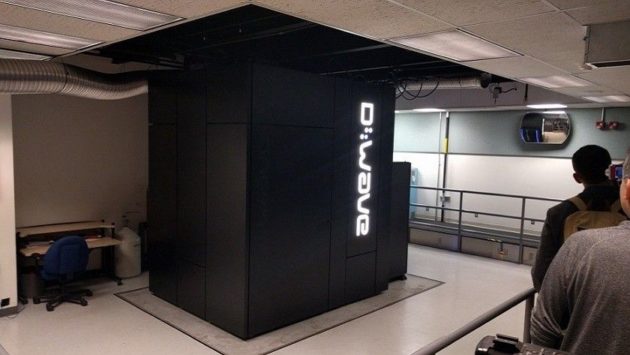

Computación cuántica

Múltiples equipos disciplinares están trabajando en lo que se considera la revolución de la computación, un ordenador cuántico que sea el instrumento definitivo para avanzar en cualquier campo científico o tecnológico del ser humano, aprovechando una capacidad de cómputo desconocido hasta ahora.

Una de las noticias del año nos llegó del acuerdo entre Google, NASA y la Asociación de Universidades para la Investigación Espacial, para usar computadoras cuánticas de D-Wave en una próxima plataforma de inteligencia artificial. D-Wave 2X es la máquina más potente de la compañía canadiense y se asegura que tiene el potencial para ser 100 millones de veces más potente que un equipo basado en chips convencionales. Y decimos «tiene el potencial» porque expertos del MIT opinan que el comportamiento “cuántico” en realidad es “estadístico clásico” (fluctuaciones térmicas en los cubits superconductores sin ningún entrelazamiento cuántico útil).

Si bien existe una clara visión de la forma de construir un ordenador cuántico, los científicos se están topando con una serie de obstáculos importantes. Un problema clave sigue siendo los factores de interferencia que influyen en la capacidad de control y la fiabilidad de los qubits, tales como defectos de la temperatura, el electromagnetismo y el material. Algo que compañías como IBM pretenden superar con un qubit tridimensional mediante un chip de zafiro.

Aún falta muchísima investigación pero las ventajas de la computación cuántica frente a la computación tradicional son enormes por su capacidad de almacenar la información en qubits (bits cuánticos) que pueden adoptar simultáneamente valores «1» y «0» (superposición), además de mantener la comunicación entre ellas sin importar la distancia.

Falsos mitos de la tecnología que todavía persisten

Dieron que hablar un par de artículos que publicamos sobre mitos tecnológicos. Conceptos erróneos que se mantienen en el tiempo por años o décadas y que son difíciles de eliminar, como todos los mitos. Falsos mitos de la tecnología que incluso son recurrentes en personas con un alto nivel cultural o formadas específicamente dentro de diferentes campos asociados o vinculados directamente con el mito en cuestión.

Hablamos de si PC es Windows; de si un procesador de más MHz siempre es mejor que otro de menos; si Linux es difícil de instalar y manejar; si la calidad de una cámara depende únicamente de sus megapixeles; si OS X y Linux no sufren ataques de malware; si los cables HDMI más caros merecen la pena; si una gráfica es más rápida cuanta más memoria tenga o si un Mac es mejor que un PC.

Como era de esperar hubo amplio debate y seguimiento de estos mitos tecnológicos en la primera y segunda parte.

Nuevos superconductores que revolucionen la electrónica

Un equipo internacional de científicos dirigidos por la Universidad japonesa de Tohoku, dice haber descubierto un nuevo estado de la materia (metálico) bajo el efecto Jahn-Teller, que permitirá obtener superconductores no convencionales que revolucionen la electrónica.

Este mismo equipo internacional, descubrió recientemente trabajando con fullereno (la tercera forma molecular más estable del carbono tras el grafito y el diamante) la temperatura de trabajo más alta lograda por un superconductor molecular, 38 K. Bajo esta base, los científicos han logrado que una sustancia formada por una estructura cristalina de buckminsterfullereno y átomos de cesio, cambiara sus propiedades físicas tras haber aumentado la presión añadiendo átomos de rubidio.

El nuevo estado de la materia metálico es consecuencia del mencionado efecto electrónico Jahn-Teller, por el que algunas sustancias pasan de ser un aislante a convertirse en un superconductor al variar su presión y temperatura. Las propiedades del estado intermedio por el que la sustancia pasa de ser aislante a semiconductor es desconocido y está siendo estudiado.

El experimento se ha realizado en laboratorio y de ahí a la producción de este tipo de materiales hay un abismo, pero la comunidad científica lo considera un avance importante en la búsqueda desemiconductores moleculares alternativos a los actuales, claves para la electrónica del futuro.

Transistores ópticos a 4.000 GHz

Transistores ópticos de óxido de zinc “dopados” con aluminio pueden ser la clave para crear los chips del futuro, capaces de trabajar a frecuencias de 4 THz, 4.000 veces a los actuales según una investigación de la Universidad Purdue de Indiana.

El transistor es totalmente óptico tanto en el flujo de datos como en la conmutación. Es compatible con CMOS y tiene una permisividad dieléctrica compatible con todos los estándares de telecomunicaciones por infrarrojos.

Aunque está más orientado a conmutación óptica para codificación de señales en un dispositivo integrado que a construir otro tipo de semiconductores como microprocesadores, los investigadores aseguraron «que el rendimiento en procesadores debe ser muy similar a nuestras simulaciones”. “Un primer paso” en este tipo de desarrollos con óxido de zinc y aluminio que dejarían atrás la era del silicio y permitiría seguir cumpliendo la Ley de Moore. Aún queda mucho insisten: “el control de la luz es algo difícil ya que los fotones no interactúan con otros fotones como lo hacen los electrones”.

Memorias 1.000 veces más rápidas que las actuales

SanDisk y HP anunciaron una alianza de colaboración tecnológica para producir una nueva y revolucionaria categoría de memorias, un componente esencial en cualquier computadora. La asociación sumará la tecnología de HP memristor y la experiencia y la tecnología de memoria ReRAM no volátil de SanDisk. Memristor es un elemento de circuito pasivo, el cuarto de un circuito junto al condensador, resistencia e inductor, descrito en 1971 pero hasta hace poco años considerado un dispositivo hipotético.

Una revolución de la electrónica mundial ya que cambiaría la arquitectura básica de los chips avanzando en rendimiento y capacidad, y rebajando el consumo. Ambas compañías compartirán su experiencia y avances en estas tecnologías con el objetivo de traer al mercado soluciones de almacenamiento con velocidades 1.000 veces superior a la de los SSDs actuales y que tengan a su vez una resistencia 1.000 veces mayor.

Esta tecnología también se utilizará en el HP The Machine, un proyecto de ordenador con una arquitectura completamente nueva que podrá ser tan pequeño como un móvil inteligente y tan grande como un supercomputador 160-rack. Contará con un sistema operativo propio y usará electrones para el procesamiento, fotones para las conexiones y comunicación e iones para la memoria y almacenamiento.

¿Existe la obsolescencia tecnológica programada?

Cualquier usuario, cliente o profesional con el que hables de este tema te dirá lo mismo: los productos no duran tanto como antes. La obsolescencia no afecta solo al sector tecnológico y abarca a todo tipo de productos, desde un automóvil a una prenda de vestir, pero ¿la obsolescencia tecnológica está programada por los mismos fabricantes para vender más?

A este tema dedicamos un artículo especial en él que hablamos de las formas en las que puede presentarse, sea “percibida, especulativa, psicológica o social o planificada“. Esta última es la más preocupante ya que refiere una técnica por el que un fabricante estudia y calcula un tiempo de vida limitado de un producto electrónico o componente y lo desarrolla bajo ese parámetro temporal.

Cuando se cumple el plazo, el equipo cae en desuso al mostrar un rendimiento insuficiente en comparación con los modelos actuales o lo que es peor, el equipo se avería y el gran coste de la reparación obliga a comprar uno nuevo. Una “técnica” inmoral e ilegal pero que algunos fabricantes practican, provocando además de un gasto innecesario, un gravísimo problema de basura electrónica y de tratamiento de recursos. No toda la obsolescencia es planificada porque la gran velocidad en el desarrollo de nuevas tecnologías incide en una obsolescencia sobrevenida.

El desarrollo del software también afecta a medida que se desarrollan y publican nuevas versiones de los sistemas operativos o de las aplicaciones que tienden a dejar máquinas obsoletas aunque su hardware siga funcionando. Como ejemplo, citar la gran fragmentación de Androiden móviles inteligentes de la que una parte de usuarios culpabiliza directamente a los fabricantes.

Crean la primera puerta lógica híbrida cuántica

La computación cuántica es el próximo gran salto tecnológico y en ella están trabajando -en secreto y en abierto- múltiples equipos disciplinares. Un desarrollo impulsado por el Nobel de Física 2012 concedido al francés Serge Haroche y el estadounidense David J. Wineland por sus trabajos en óptica cuántica, que analizaron la interacción entre luz y materia y sentaron bases consistentes para diversas aplicaciones, entre ellas la futura creación de una computadora cuántica.

Lo último nos llega de un artículo de Nature que informa de la creación de una puerta lógica híbrida cuántica en la Universidad de Oxford. Ya conoces como frente a los bits de la computación tradicional capaces de adoptar un valor de 1 o 0, la información en computación cuántica se almacena en qubits (bits cuánticos) que pueden adoptar simultáneamente ambos valores (superposición).

Los cerebritos de Oxford, dicen haber conseguido -por primera vez en la industria- una puerta lógica híbrida cuántica utilizando iones de distintos tipos, en este caso isótopos de calcio-40 y calcio-43. Dicen que es un avance importante.

Más información:

* Tecnología en 2015 | MIT

* Realidad Virtual en 2015 | MIT

* 100 grandes innovaciones de 2015 | Popular Science

* Imagen de portada: Shutterstock

-

NoticiasHace 1 día

NoticiasHace 1 díaRequisitos de Ghost of Tsushima, llegará a PC el 16 de mayo con DLSS 3 y FSR 3

-

A FondoHace 4 días

A FondoHace 4 díasFin de ADSL, ¿qué alternativas tienes?

-

A FondoHace 7 días

A FondoHace 7 díasLos chips Apple Silicon M4 también pondrán el foco en la IA

-

A FondoHace 5 días

A FondoHace 5 díasNovedades VOD 15/24: ‘Fallout’, pulgares arriba