Noticias

Apple retrasa la llegada de NeuralHash tras la polémica

Desde el mismo día del anuncio de NeuralHash, el sistema diseñado por Apple para intentar combatir el contenido CSAM (Child Sexual Abuse Material), se desató una enorme polémica alrededor de esta nueva tecnología que, según afirmó Apple, llegaría a los dispositivos de los usuarios junto con iOS 15, el sistema operativo de los gadgets de Apple que, presumiblemente, debutará en algún momento de septiembre, poco después de la presentación del iPhone 13.

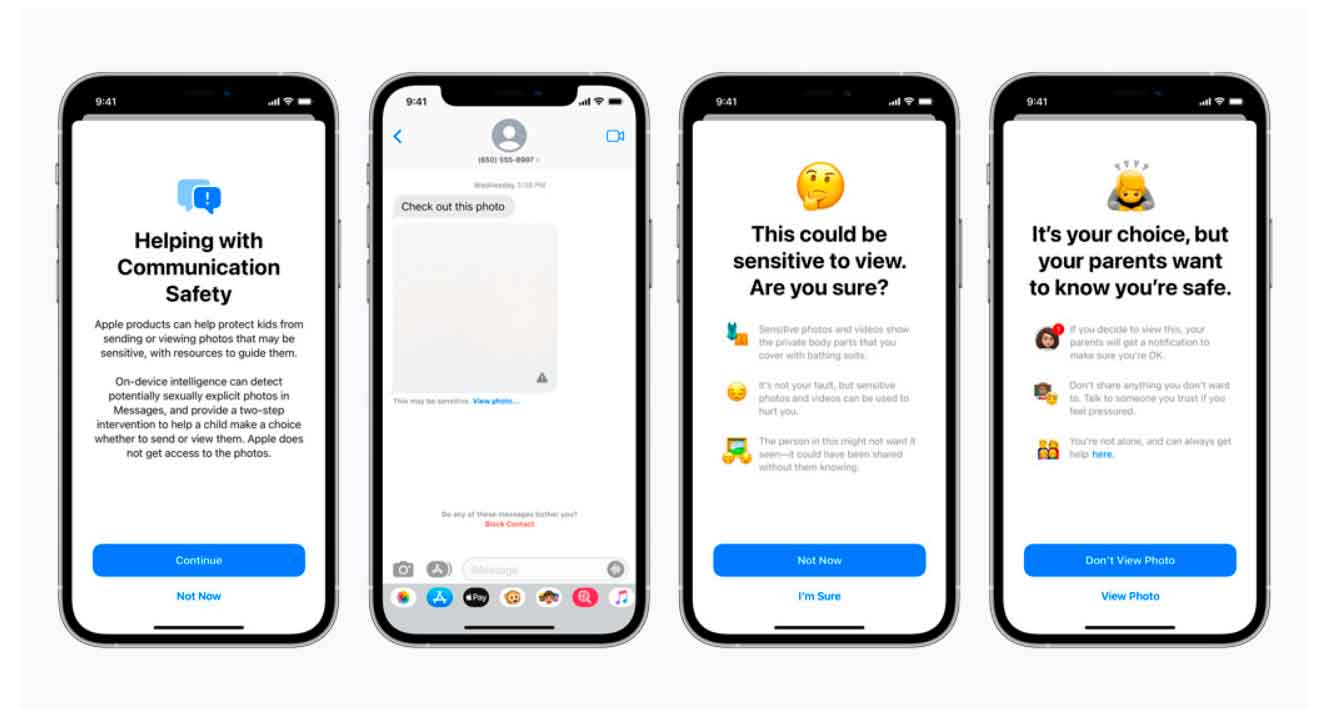

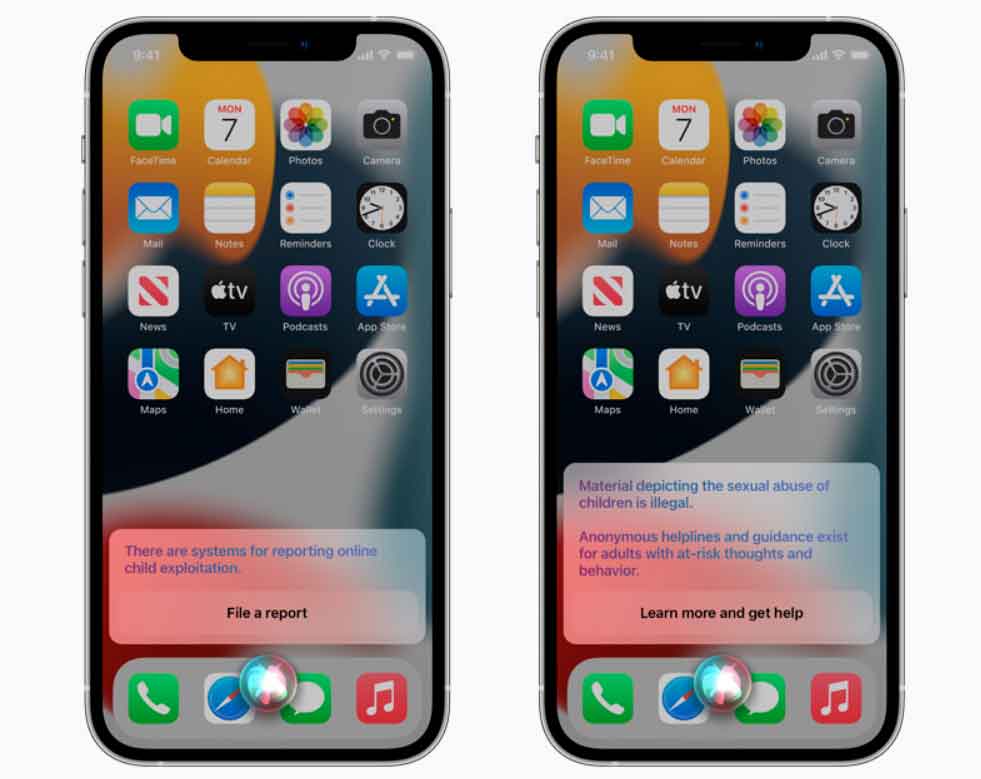

Por si no recuerdas en qué consiste NeuralHash recordémoslo rápidamente: iOS 15, con esta función, analizará todo el material gráfico de los dispositivos cuando éste sea subido a iCloud. Para dicho análisis se generará un hash que será cruzado con una base de datos de los hashes generados por material CSAM ya identificado previamente. En caso de que NeuralHash detecte una coincidencia, la cuenta de iCloud será inmediatamente bloqueada y, cabe pensar, Apple informará a las autoridades para que tomen las medidas que correspondan.

En una lectura rápida esto suena muy bien, claro, combatir el contenido CSAM es algo con lo que todos estamos de acuerdo, e incluso apuesto a que la inmensa mayoría de personas se mostrarían de acuerdo con NeuralHash si se pudiera tener la certeza absoluta de que este sistema va a ser empleado exclusivamente para este fin. Salvo los propios pederastas, por razones obvias, no creo que haya una sola persona en el mundo capaz de resistirse a esta posibilidad.

Sin embargo, al hablar de NeuralHash estamos hablando de una puerta trasera, con todas las implicaciones que esto conlleva. Y cuando creas una puerta trasera en un sistema, y más aún cuando ésta es públicamente conocida, no te quepa la menor duda de que habrá muchos interesados en emplearla. Ya sean desde particulares hasta entidades gubernamentales, la posibilidad de «fisgar» lo que sus usuarios piensan que es privado es algo tremendamente atractivo para muchos, como ya nos ha demostrado la historia.

Apple suele hacer bandera de su defensa de la privacidad y de sus usuarios por encima de todo. Y sí, es cierto que en más de una ocasión se ha enfrentado a las autoridades públicas, negándose, precisamente, a crear puertas traseras. Y precisamente con el mismo argumento que he expuesto yo hace solo un momento. Por eso, cada vez me sorprende más que Apple haya optado por este camino, creando NeuralHash que, en potencia, puede ser explotado con otros muchos fines.

Ya hemos visto a Apple, en el pasado, responder a algunas presiones gubernamentales, con el peligroso agravante de que además quiso ocultarlo. Y si lo ha hecho una vez, ¿qué nos puede hacer pensar que no lo repetiría en determinadas circunstancias? ¿Qué pasaría si China exige a Apple que emplee NeuralHash para detectar contenido disidente, bajo la amenaza de cerrarle su mercado en caso contrario? ¿Renunciaría Apple a las ventas en China?

Como usuario de Apple me gustaría pensar que sí, pero como persona con sentido común me cuesta mucho creerlo. Y el problema es que NeuralHash no es una puerta secreta que solo sus responsables y algunos colaboradores y agencias externas conocen, no, su existencia y su funcionamiento son públicos. Con las funciones de privacidad de iOS 14 Apple se ganó una gran imagen como garante de la privacidad, pero con NeuralHash todo ese prestigio podría haber sido dinamitado.

Así, cuando no ha pasado ni un mes desde que se supo de su existencia, y tras opiniones tan devastadoras como la de la Electronic Foundier Foundation, Apple ha decidido posponer el despliegue de NeuralHash, tal y como podemos leer en una anotación en la web en la que informa sobre el sistema:

«Actualización al 3 de septiembre de 2021: anteriormente anunciamos planes para funciones destinadas a ayudar a proteger a los niños de los depredadores que usan herramientas de comunicación para reclutarlos y explotarlos y para ayudar a limitar la propagación de CSAM. Basándonos en los comentarios de los clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas características de seguridad infantil de importancia crítica.»

De este modo, de momento NeuralHash queda en pausa, un tiempo que Apple se tomará para escuchar diversas opiniones. Sin embargo, me cuesta imaginar qué solución pueden encontrar a esta situación. No dudo de su buena voluntad, pues en lo referido a la privacidad lleva demostrándola los últimos años. Sin embargo, desde el mismo momento en el que ha planteado un sistema capaz de escanear el contenido de los usuarios, ha dado un paso atrás que, para muchos, podría incluso llegar a invalidar sus esfuerzos de los últimos años a este respecto.