A Fondo

Apple toca fondo con las ventas de sus Mac, os contamos cuál es el problema

La firma de Cupertino se ha convertido en la primera tecnológica estadounidense en superar el billón de dólares en valor de capitalización de mercado, todo un logro que sin embargo no oculta la triste realidad que afecta a sus Mac.

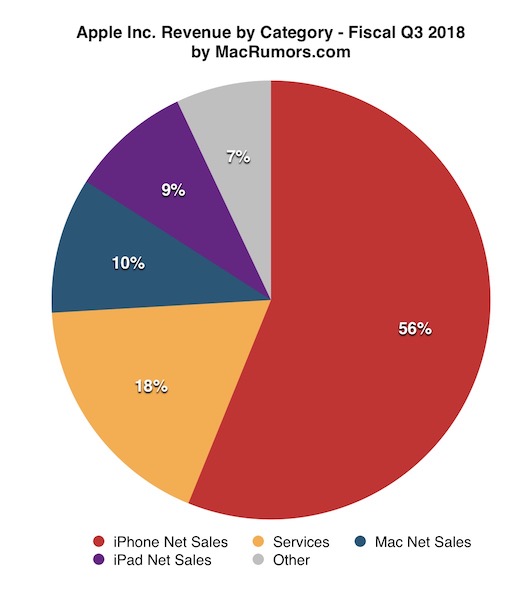

El desglose de los productos vendidos que ha realizado MacRumors en la gráfica adjunta nos permite ver que el iPhone y los servicios son los dos grandes pilares sobre los que se sostiene casi todo el peso de Apple, y teniendo en cuenta la enorme dependencia que los segundos tienen de los primeros podemos decir sin temor a equivocarnos que el gigante de Cupertino depende fundamentalmente del iPhone.

Los de la manzana mordida han confirmado que desde el 1 de abril hasta el 30 de junio ha vendido 3,72 millones de equipos Mac, una cifra que es la segunda más baja que ha registrado la compañía desde el mismo periodo de 2010, fecha en la que apenas llegó a los 3,47 millones de unidades.

¿Qué es lo que está ocurriendo?

Podríamos pensar que hay una explicación compleja detrás de esta situación, pero lo cierto es que la explicación es muy sencilla: Apple vende hardware obsoleto a precios absurdos, y el Mac Pro es el mejor ejemplo, ya que hablamos de un equipo que tiene hardware de 2012-2013 y que todavía cuesta miles de euros.

Con esto no queremos decir que todos los Mac que vende Apple estén obsoletos, pero sí que la compañía de la manzana tiene pendiente una importante renovación de buena parte de su catálogo y que ésto ha acabado afectando de forma notable a sus ventas.

Siguiendo con el ejemplo que hemos puesto anteriormente podemos hablar del Mac Mini, que lleva varios años sin actualizarse o del MacBook Air, que sigue teniendo presencia en la tienda oficial de Apple a pesar de contar con una vetusta pantalla con resolución de 1.440 x 900 píxeles y de utilizar procesadores Core serie 5000U, una generación que está basada en Broadwell de Intel y que queda cuatro generaciones por detrás de los actuales Coffee Lake.

Apple no es la única afectada

Es cierto que Apple es una de las compañías que más está sufriendo su propia ralentización en los ciclos de renovación de sus equipos Mac, pero no es la única empresa que está afectada por ese problema.

Microsoft es otro gigante que arrastra el problema de las actualizaciones a destiempo de sus principales productos. Por ejemplo la serie Surface Pro utiliza procesadores basados en Kaby Lake, una serie que ya ha sido superada por dos generaciones: Kaby Lake R y Coffee Lake. Puede parecer poco importante nada más lejos de la realidad, ya que los procesadores Kaby Lake de bajo consumo tienen dos núcleos y cuatro hilos mientras que los basados en Kaby Lake R y superiores tienen cuatro núcleos y ocho hilos.

El alto precio es otra clave a tener en cuenta, ya que en este tipo de equipos no hace más que agravar la situación al reducir de manera drástica el valor calidad-precio que ofrecen y acaba borrando prácticamente cualquier tipo de interés por parte del consumidor.

Apple es consciente de la situación. La propia compañía ha confirmado que están trabajando en el desarrollo de un nuevo Mac Pro y que no sólo aprovecharán para hacer una puesta al día a nivel de especificaciones, sino que además llevarán a cabo una renovación total en términos de diseño.

El Mac Pro sorprendió al mundo por su acabado en forma de cilindro, así que habrá que esperar a ver qué se les ocurre ahora a los ingenieros de Apple. Os recordamos que su lanzamiento se espera para 2019.

-

GuíasHace 3 días

GuíasHace 3 días10 sitios web para descargar libros electrónicos gratuitos

-

A FondoHace 5 días

A FondoHace 5 díasNovedades VOD 16/24: ‘Rebel Moon’, la película que deja marcas

-

A FondoHace 6 días

A FondoHace 6 díasTelefónica cumple 100 años, repasamos su historia

-

AnálisisHace 7 días

AnálisisHace 7 díasAnálisis ROCCAT Vulcan II Max: 6 meses al toque con un tope de gama