Noticias

El SoC Apple A14X costará casi cuatro veces menos que un Core i3 10110U

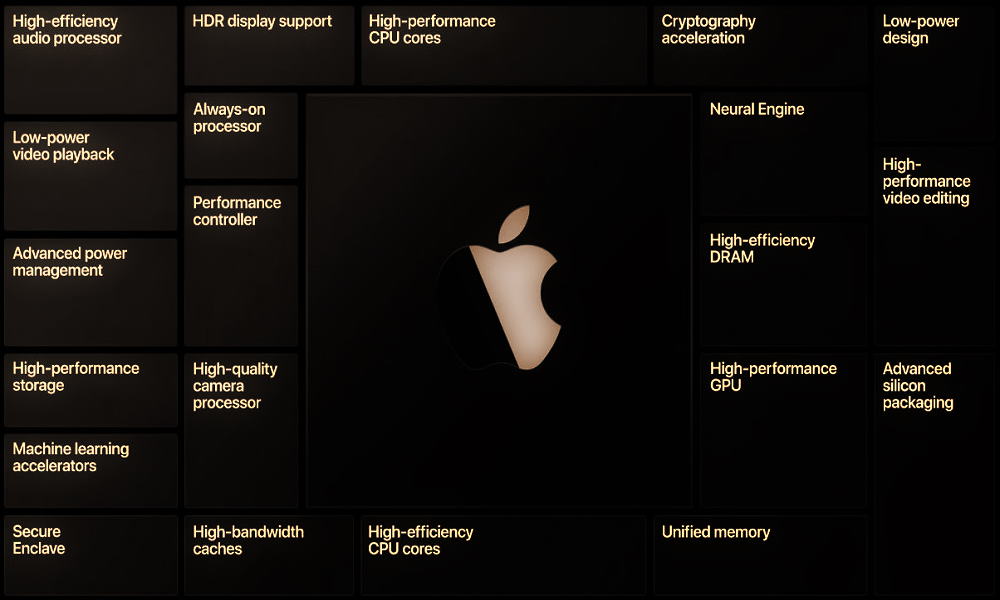

La compañía que dirige Tim Cook afrontará una transición muy importante con el abandono de los procesadores Intel x86, y el SoC Apple A14X se perfila como uno de los pilares más importantes de la primera etapa «post-Intel». No hablamos sin motivo, este podría ser el primer chip que utilizará la firma de la manzana mordida en lugar de los Intel Core de bajo consumo, y según una reciente filtración que nos llega desde China tiene una pinta bastante prometedora.

Según fuentes dentro de la cadena de suministros del sector smartphone el SoC Apple A14X estará fabricado en proceso de 5 nm, contará con un total de 15.000 millones de transistores y ofrecerá un rendimiento muy elevado, gracias a la capa de personalización que añade Apple sobre la arquitectura ARM. La configuración de núcleos no ha trascendido, pero teniendo en cuenta que el SoC Apple A12Z ya monta ocho núcleos tenemos dos grandes posibilidades:

- Más núcleos: el Apple A14X podría venir configurado con 12 núcleos en una apuesta clara por mejorar el rendimiento multihilo del chip.

- Mejoras a nivel de arquitectura y mayores frecuencias: dicho chip también podría mantener el conteo de núcleos del Apple A12Z, pero mejorar en rendimiento bruto a través del IPC y de un aumento de las frecuencias de reloj.

Ambas opciones tienen sentido, tanto que no me «atrevo» a decantarme por ninguna. Con todo, os recuerdo que los últimos rumores que vimos hablaban de un total de 12 núcleos.

Reducción de costes: el gran valor del SoC Apple A14X

Aportar por ARM en lugar de Intel para potenciar sus equipos Mac (en sentido amplio, es decir, tanto equipos de escritorio como portátiles) ha sido una decisión muy acertada por parte de Apple, y por muchas razones. Ya conocemos algunas de ellas, por ejemplo, al utilizar sus propios SoCs la compañía de la manzana puede controlar mejor los ciclos de renovación de sus productos, las innovaciones que introduce en estos y ejercer un mayor control sobre su ecosistema de hardware.

No debemos olvidar que este movimiento de Apple ha sido un golpe para Intel, pero también para AMD, ya que la compañía de la manzana mordida utilizará sus propias GPUs. Sin embargo, no todo se limita a ese control y al dejar «todo en casa», los costes también importan, tanto que podrían justificar por sí solos el salto a ARM.

Para muestra un botón, y es que según la fuente de esta noticia el SoC Apple A14X tendría un coste de fabricación aproximado de 75 dólares. ¿Deberías estar impresionado? Pues lo cierto es que sí, ya que un Core i3 10110U tiene un coste, en pedidos de mil unidades, de 281 dólares. Como puedes ver la diferencia de precio es considerable, y el chip de Apple debería ser más potente que ese Core i3 10110U.

Con el salto a sus propios SoCs Apple cierra el círculo, establece un control casi total que opera a nivel de hardware y de software, reduce los gastos y deja en casa una parte importante de los costes que debía asumir al utilizar CPUs Intel. Es un «win-win» para la compañía de Tim Cook, de eso no hay ninguna duda.

-

GuíasHace 1 día

GuíasHace 1 día10 sitios web para descargar libros electrónicos gratuitos

-

NoticiasHace 6 días

NoticiasHace 6 díasRequisitos de Ghost of Tsushima, llegará a PC el 16 de mayo con DLSS 3 y FSR 3

-

NoticiasHace 6 días

NoticiasHace 6 díasOMEN Transcend 14, un ultraligero todoterreno con GeForce RTX 4070

-

A FondoHace 6 días

A FondoHace 6 díasLas mejores alternativas a la Google Play Store para descargar apps Android