A Fondo

Cinco tarjetas gráficas 3D que cambiaron el mundo del gaming en PC

El sector de las tarjetas gráficas 3D ha vivido una importante evolución durante las últimas décadas. En sus inicios eran casi una rareza que no terminada de despegar, sobre todo por cuestiones de precio y de falta de optimización, pero la llegada de 3DFX cambió por completo la situación y sentó las bases del mercado actual.

Nuestros lectores más veteranos recordarán a la perfección aquella etapa temprana de las aceleradoras 3D y el valor que aportó 3DFX en términos de soporte, de compatibilidad, de rendimiento y también de precio.

En los años posteriores el mercado se fue agitando y la guerra que vivió el sector de las tarjetas gráficas 3D se acabó concentrando en tres gigantes: NVIDIA, ATI y 3DFX. Firmas como 3Dlabs, Matrox y S3 brillaron en momentos puntuales gracias a productos muy concretos, pero no pudieron aguantar el tirón y la mayor parte de la «tarta» quedó a repartir entre los los tres primeros.

La historia de las tarjetas gráficas 3D es muy rica, tanto que podríamos escribir sin problemas un libro de cientos de páginas tocando especificaciones técnicas, APIs, avances clave y asociarlos a juegos determinados, y siempre nos acabaríamos dejando algo en el tintero. Sin embargo los avances más importantes se pueden concentrar en generaciones y modelos concretos, así que hemos decidido hacer un artículo especial dedicado a cinco tarjetas gráficas 3D que representaron un avance tan grande que cambiaron el mundo del gaming en PC.

Limitarnos a cinco modelos implica que tendremos que afinar mucho la puntería y que habrá tarjetas gráficas importantes que quedarán fuera, pero nos permitirá dar forma a un artículo más ameno y fácil de leer.

Sin más preámbulos empezamos. Esperamos que os guste, y como siempre os invitamos a dejar cualquier duda en los comentarios.

1-Voodoo de 3DFX

Marcó un verdadero punto de inflexión en el mercado de las aceleradoras 3D y sentó las bases de la industria actual. Fue la primera tarjeta 3D de consumo general a precio razonable que realmente estaba preparada para trabajar de forma óptima cargas de trabajo intensas y de procesar efectos avanzados.

Su debut se produjo en 1996, funcionaba sobre el bus PCI y contaba con las siguientes especificaciones:

- DAC (conversor digital-analógico).

- Procesador de búfer de cuadros.

- Unidad de mapadoo de texturas.

- 4 MB de DRAM EDO.

- Dos procesadores gráficos a 50 MHz.

- Requería tarjeta 2D independiente para funcionar.

En sus inicios los competidores más importantes de la Voodoo fueron las soluciones gráficas de firmas como PowerVR, Matrox y Rendition. Sus competidores tenían la ventaja de ofrecer productos que podían trabajar en 2D y en 3D, pero sus capacidades de aceleración 3D estaban muy por debajo de las que ofrecía la solución de 3DFX.

¿Qué aportó al mundo del gaming?

- Demostró el valor de tener una API dedicada y perfectamente optimizada: Glide.

- Podía mover juegos en 640 x 480 con aceleración 3D de forma fluida.

- Soportaba funciones avanzadas que estaban fuera del alcance de otras tarjetas gráficas de la época, como las transparencias.

- Desplazó al procesador como pieza fundamental para mover juegos 3D.

- Era capaz de «revivir» equipos de gama baja. Un Pentium a 120 MHz con una Voodoo estaba a años luz de un Pentium a 200 MHz con una S3 Virge.

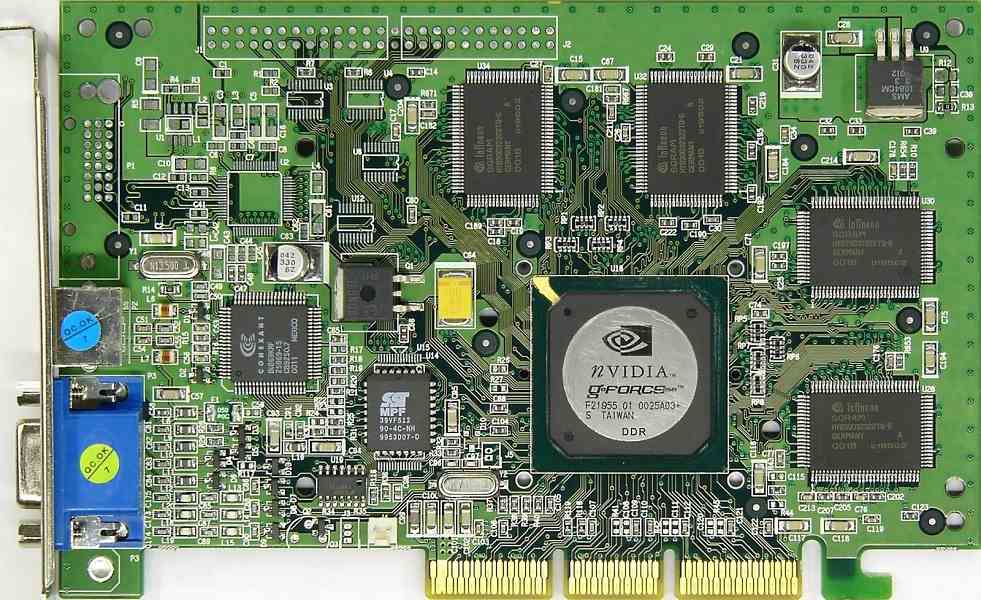

2-GeForce 256

NVIDIA consideró a esta tarjeta gráfica como la primera en contar con una verdadera GPU (unidad central de procesamiento gráfico). Hay mucha polémica en torno a esta cuestión, pero lo cierto es que la GeForce 256 fue una aceleradora 3D verdaderamente revolucionaria que no sólo marcó un antes y un después a nivel técnico y de rendimiento, sino que además puso el primer clavo en el ataúd de 3DFX.

Esta tarjeta gráfica llegó al mercado en 1999, funcionaba sobre el bus AGP y contaba con la siguiente configuración:

- 4 pixel pipelines.

- 4 unidades de texturizado.

- 4 unidades de rasterizado.

- GPU a 120 MHz.

- Bus de memoria de 128 bits.

- 32 MB-64 MB de memoria DDR-SDR, según versión, a 150 MHz-166 MHz, respectivamente.

En términos de rendimiento no tenía rival, y además fue la primera tarjeta gráfica 3D de consumo general que podía aprovechar por hardware Transform and Lighting (T&L), integrada en DirectX 7 de Microsoft.

¿Qué aportó al mundo del gaming?

- Fue la tarjeta gráfica 3D de consumo general con una GPU.

- Contaba con motores de transformación, iluminación, configuración y recorte de triángulos y de procesamiento.

- Superó la barrera de los 10 millones de polígonos por segundo.

- Contribuyó a estandarizar Transform and Lighting (T&L).

- Sentó las bases del futuro estándar de sombreado de píxeles que llegaría con DirectX 8.

3-Radeon X1950XTX

Ha sido una de las tarjetas gráficas 3D de gama alta más potentes de todas las que lanzó la extinta ATI, compañía que como sabemos fue comprada en 2006 por AMD, el mismo año en el que debutó dicha tarjeta. Hoy se encuentra totalmente integrada en la división Radeon Technology Group.

La Radeon X1950XTX fue una auténtica demostración de fuerza por parte de ATI. La compañía había tenido problemas para seguir el ritmo de NVIDIA, y con esta tarjeta gráfica demostró que podía superarla sin ningún tipo de problema, incluso en juegos como Quake 4, que estaban basados en el motor gráfico de DOOM 3 y que eran por tanto «feudo» favorable a los de verde. Estas son sus especificaciones clave:

- 48 unidades de sombreado de píxeles.

- 16 unidades de texturizado.

- 16 unidades de rasterizado.

- 8 unidades de sombreado de vertex.

- Bus de 256 bits.

- GPU a 650 MHz.

- 512 MB de memoria GDDR4 a 2 GHz.

Sin duda la tarjeta gráfica más potente de su generación y la cima de todos los modelos basados en DirectX 9.0c. Insuperable en términos de potencia bruta, aunque con un precio muy elevado.

¿Qué aportó al mundo del gaming?

- Fue la tarjeta gráfica más potente de la historia compatible con DirectX 9.0c.

- Podía mover juegos exigentes con fluidez en resoluciones muy altas para la época.

- Permitía activar HDR y suavizado de bordes de forma simultánea.

- Fue la primera en utilizar memoria GDDR4.

- Sirvió de base para desarrollar la GPU de Xbox 360.

- Rompió de verdad la supremacía de NVIDIA.

4-GeForce 8800 GTX

Con esta tarjeta gráfica 3D se dio el salto a la arquitectura de shaders unificados. En ella las unidades de sombreado de píxels y de vertex se unen, un cambio muy importante que permitió una enorme mejora en términos de rendimiento. Su lanzamiento se produjo a finales de 2006.

Para que os hagáis una idea del salto que marcó la GeForce 8800 GTX basta con decir que era capaz de superar el rendimiento de una GeForce 7950 GX2. Dicha tarjeta gráfica contaba con dos GPUs G71 utilizadas en las GeForce 7900 GTX. Haciendo una comparativa actual sería como si la GeForce RTX 2080 TI de NVIDIA fuese capaz de rendir más que dos GTX 1080 TI. Impresionante, ¿verdad? Pues sus especificaciones no se quedaban atrás:

- 128 shaders.

- 32unidades de texturizado.

- 24 unidades de rasterizado.

- Bus de 384 bits.

- GPU a 576 MHz, «hot shaders a 1.350 MHz».

- 768 MB de memoria GDDR3 a 1,8 GHz.

No sólo marcó un enorme salto en términos de rendimiento, sino que además definió el camino que ha seguido la industria durante los últimos doce años.

¿Qué aportó al mundo del gaming?

- Ha representado el mayor salto de rendimiento frente a la generación anterior.

- Introdujo la arquitectura de shaders unificados que todavía hoy utilizamos.

- Fue la primera compatible con DirectX 10.

- Marcaba una distancia enorme frente a PS3 y Xbox 360.

- Podía mover Crysis de forma más que aceptable.

- Todavía hoy puede mover juegos que no estén limitados a DirectX 11.

5.-Radeon HD 7970

No fue la tarjeta gráfica más eficiente ni tampoco la más potente de su generación en un principio, pero su importancia está fuera de toda duda. La arquitectura utilizada en esta tarjeta gráfica ha dado vida a la GPU de PS4 y Xbox One, y sentó las bases de la arquitectura que se utilizaría posteriormente en PS4 Pro y Xbox One X.

Con la Radeon HD 7970 en AMD llevaron a cabo una apuesta totalmente distinta a la que hizo NVIDIA con Kepler y su serie GTX 600: integraron funciones avanzadas como shaders asíncronos por hardware, lo que le permitía ofrecer un mayor rendimiento en APIs de bajo nivel (Vulkan, por ejemplo).

Este enfoque era un claro reflejo del valor de la optimización sobre la simple potencia bruta, y el tiempo ha dado la razón a AMD. Las Radeon HD serie 7000 han envejecido mejor que sus rivales directos basados en Kepler y su rendimiento en DirectX 12 y Vulkan es superior. Estas fueron las especificaciones de la Radeon HD 7970:

- 2.048 shaders.

- 128 unidades de texturizado.

- 32 unidades de rasterizado.

- GPU a 925 MHz.

- Bus de 384 bits.

- 3 GB de GDDR5 a 5,5 GHz.

Esta tarjeta gráfica 3D todavía es capaz de ofrecer un buen rendimiento en juegos actuales con resoluciones 1080p y calidades medias o altas, según las exigencias de cada juego.

¿Qué aportó al mundo del gaming?

- Demostró el valor de la optimización sobre la potencia bruta.

- Introdujo el soporte de shaders asíncronos a nivel de hardware.

- Su arquitectura fue la base de las GPUs de PS4 y Xbox One.

- Ha sido una de las tarjetas gráficas más longevas de la historia.

-

NoticiasHace 2 días

NoticiasHace 2 díasRequisitos de Ghost of Tsushima, llegará a PC el 16 de mayo con DLSS 3 y FSR 3

-

A FondoHace 5 días

A FondoHace 5 díasFin de ADSL, ¿qué alternativas tienes?

-

A FondoHace 6 días

A FondoHace 6 díasNovedades VOD 15/24: ‘Fallout’, pulgares arriba

-

NoticiasHace 7 días

NoticiasHace 7 díasCelebra la primavera con una licencia 100% original de Windows 11, por solo 20,1 € en Supercdk