A Fondo

Tarjetas gráficas AMD Radeon: ¿Deberían ser más baratas que las GeForce RTX?

Las tarjetas gráficas AMD Radeon han vivido momentos dispares a lo largo de los últimos años. Cuando la serie Radeon estuvo bajo la batuta de ATi vivimos el lanzamiento de generaciones tan interesantes como la Radeon 8500, la serie Radeon X1000 y las Radeon HD serie 4000, pero también llegaron decepciones importantes, como la serie Radeon X800, que no era compatible con DirectX 9.0c, y las Radeon HD 2000, que no podían competir con las GeForce serie 8000 de NVIDIA.

ATi era toda una veterana del sector gráfico, de hecho empezó a comercializar sus primeros productos en los años ochenta, cuando los estándares CGA y EGA estaban en todo su esplendor. Las tarjetas gráficas AMD Radeon llegaron mucho después, concretamente tras la compra de ATi por parte del gigante de Sunnyvale y la disolución de aquella en 2006. La primera generación de tarjetas gráficas AMD Radeon fue la serie Radeon HD 6000, ya que las Radeon HD 5000 todavía utilizaron la marca ATi.

En líneas generales, la serie Radeon HD 6000 ofreció un rendimiento bastante bueno, aunque no logró arrebatar la corona a la serie GTX 500 de NVIDIA. AMD hizo también un buen trabajo con las Radeon HD 7000, aunque su apuesta por DirectX 12, y las funciones más avanzadas de dicha API, en una época en la que casi todos los desarrollos estaban centrados en DirectX 11 le hizo perder enteros frente a la serie GTX 600 de NVIDIA. Al final, dicha generación ha envejecido mejor, pero ha sido tan a largo plazo que el valor que podemos darle resulta cuestionable.

Vamos a avanzar un poco en el tiempo. Cuando NVIDIA lanzó las GeForce RTX serie 20, basadas en la arquitectura Turing, llevó a cabo un movimiento muy arriesgado ya que en vez de centrarse en mejorar el rendimiento bruto en rasterización optó por la especialización, una realidad que se materializó a través de dos grandes frentes: los núcleos tensor, especializados en inteligencia artificial, y los núcleos RT, especializados en trazado de rayos.

Para introducir esos dos bloques de núcleos, NVIDIA tuvo que dedicar una parte muy valiosa del espacio del encapsulado, y esto hizo que el aumento de rendimiento en rasterización fuese menos marcado que en la generación anterior. Las críticas que recibió el gigante verde fueron muy marcadas, pero al final está claro que la compañía tomó el camino correcto, solo tenemos que ver lo bien que rinden a día de hoy tarjetas gráficas tan modestas como la RTX 2060, el potencial que tiene en trazado de rayos comparada con la serie de tarjetas gráficas AMD Radeon RX 6000, y su capacidad para mover juegos en 4K gracias al DLSS.

AMD, por contra, siguió una estrategia menos arriesgada y más discreta. La serie de tarjetas gráficas AMD Radeon RX 5000 no tienen hardware especializado para trazado de rayos, ni tampoco otro hardware específico para inteligencia artificial. Cuando llegaron al mercado, las Radeon RX 5700 presumían de tener un rendimiento ligeramente superior al de la RTX 2060 y un precio similar, lo que las convertía en una solución interesante. Lo mismo ocurría con la RX 5700 XT frente a la RTX 2070.

En aquél momento, tanto el trazado de rayos como el DLSS se encontraban en una etapa muy temprana, y esto hacía que no se les considerase como un valor diferencial a la hora de elegir una u otra tarjeta gráfica, pero hoy la situación ha cambiado por completo. Ambas tecnologías están presentes en una cantidad notable de juegos, su tasa de adopción no hace más que crecer, se utilizan en algunos de los triple A más importantes del momento y marcan una diferencia muy importante. Por todo ello, ya no podemos seguir mirando hacia otro lado cuando hablamos de ellas, y tenemos que darles la importancia que merecen.

Tarjetas gráficas AMD Radeon: Una reflexión sobre el precio de venta

En cada generación de tarjetas gráficas, tanto AMD como NVIDIA han afinado el precio de sus principales productos, y lo han ido ajustando en tiempo real no solo a las necesidades del mercado, sino también a la estrategia de la competencia, y al valor del catálogo de aquella. Así, por ejemplo, cuando ATi o AMD han tenido un producto muy atractivo, NVIDIA ha bajado precios y, en algunos casos, ha lanzado nuevos productos para contrarrestarlos. Lo mismo ha ocurrido a la inversa.

Sin embargo, con las últimas generaciones gráficas, esta estrategia no ha sido tan marcada, y a día de hoy muchas tarjetas gráficas AMD Radeon RX 6000 tienen un precio de venta recomendado superior al de las GeForce RTX 30 equivalentes. Hablo de precios recomendados porque son los que ha dado oficialmente cada compañía, y porque los precios inflados que se mueven en el mercado actualmente no merecen ningún tipo de atención, puesto que son una auténtica locura.

Vamos a verlo con algunos ejemplos. La RX 6700 XT tiene un precio recomendado de 489,99 euros, una cifra que la coloca prácticamente al mismo nivel que la GeForce RTX 3070, que cuesta 519 euros. La diferencia de precio es de apenas 29,01 euros. En términos de rendimiento, la solución gráfica de AMD queda un poco por detrás de la RTX 3070 en rasterización (es, de media, un 7% más lenta), pero en trazado de rayos la diferencia de rendimiento entre ambas es enorme. Os dejo algunos datos para que podáis comparar:

- Metro Exodus en 1440p, calidad ultra y trazado de rayos: la RX 6700 XT logra medias de 59 FPS, mientras que la RTX 3070 consigue medias de 79 FPS.

- Control en 1440, calidad máxima y trazado de rayos: de nuevo la RX 6700 XT queda muy por detrás, ya que alcanza una media de 23 FPS, mientras que la RTX 3070 logra 40 FPS, y sin activar el DLSS de segunda generación.

- Cyberpunk 2077 en 1440, calidad máxima y trazado de rayos: la RX 6700 XT tiene medias de 15 FPS, mientras que la RTX 3070 logra medias cercanas a los 30 FPS, y sin activar el DLSS de segunda generación.

Cyberpunk 2077 con trazado de rayos funcionando sobre una RTX 3080 Ti. La calidad gráfica es impresionante. Haz clic para ampliar.

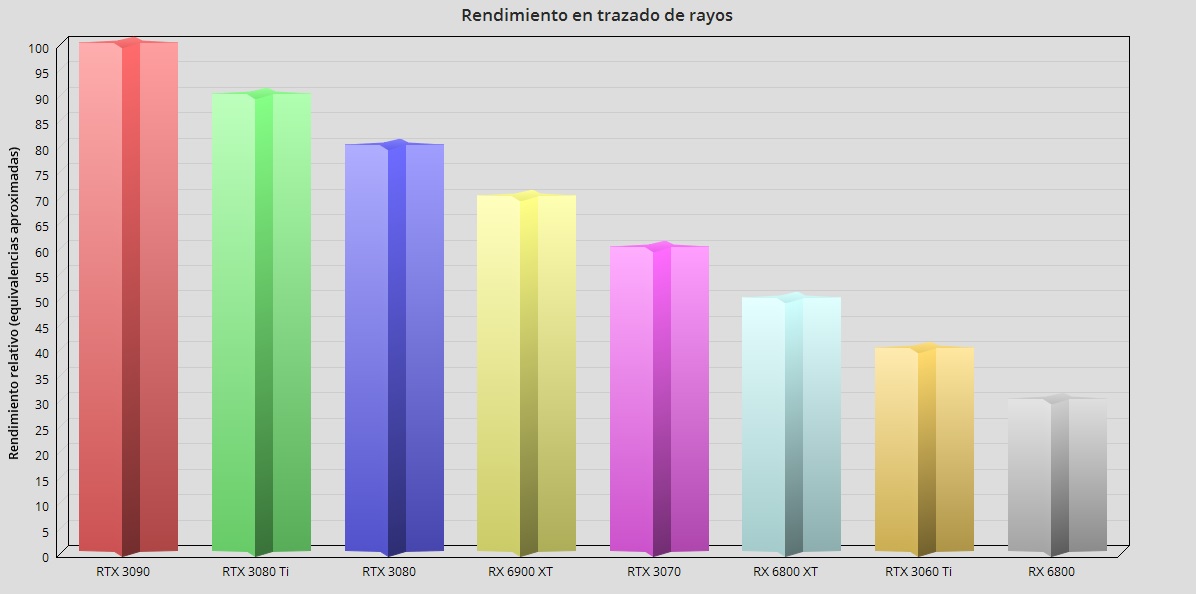

Creo que los datos que acabamos de ver hablan por sí solos. Las tarjetas gráficas AMD Radeon RX 6000 ofrecen un excelente rendimiento en rasterización, son eficientes y cuentan con la ventaja de ofrecer una alta cantidad de memoria gráfica, pero en trazado de rayos su rendimiento está una generación por detrás de NVIDIA. No exagero, el resultado que obtiene esa Radeon RX 6700 XT en Control, esos 23 FPS de media, la colocan en la liga de la RTX 2060, que consigue una media de 20 FPS.

Si introducimos en la ecuación el DLSS de segunda generación, vemos que la situación empeora notablemente para las tarjetas gráficas AMD Radeon RX 6000. Dicha tecnología puede llegar a triplicar el rendimiento en algunos casos, y representa un valor tan grande que permite a una modesta RTX 2060 mover juegos como Red Dead Redemption 2 en 4K. Ya lo vimos en este artículo, la RTX 2060 pasaba de 23 FPS a 35 FPS gracias al DLSS de segunda generación.

Me he centrado en hablar de la RTX 2060 porque fue, en su momento, una tarjeta gráfica muy cuestionada, y sin embargo ha envejecido de maravilla, tanto a nivel de soporte en drivers como de rendimiento, de hecho podemos decir que gracias al DLSS está teniendo una segunda vida. En Red Dead Redemption 2, la mejora de rendimiento que consigue al activar el DLSS de segunda generación coloca a la RTX 2060 por encima de la RX 5700 XT. ¿No te sorprende? Pues apunta, puede mover DOOM Eternal en 4K con trazado de rayos activado y DLSS en modo rendimiento bajo resolución 4K manteniendo medias de más de 50 FPS. Eso es imposible con una RX 5700 XT.

Metro Exodus Enhanced Edition con trazado de rayos al máximo sobre una RTX 3080 Ti. La calidad de la iluminación y de las sombras es fantástica. Haz clic para ampliar.

En el párrafo anterior hemos visto algo muy importante, y es que, más allá del tema del rendimiento bruto, la GeForce RTX 2060 es capaz de hacer cosas que no están alcance de una RX 5700 XT, y que marcan una diferencia muy grande. El trazado de rayos es inviable en una RX 5700 XT porque carece de hardware dedicado a la aceleración de dicha carga de trabajo, y esta tecnología ya ha demostrado que puede mejorar en gran medida la calidad gráfica en juegos. Por otro lado, el DLSS de segunda generación también ha puesto sobre la mesa una realidad muy clara: supera de largo al FSR de AMD.

No hay duda de que aquellos que compraron una GeForce RTX 2060 cuando estuvo disponible por menos de 300 euros (llegó a costar 260 euros) tomaron una decisión acertada. Los que optaron por una Radeon RX 5700 también disfrutaron de un buen nivel de rendimiento, y han podido amortizar su inversión durante un tiempo razonable, pero poco a poco están viendo como dicha tarjeta gráfica está perdiendo atractivo debido al empuje del trazado de rayos y del DLSS.

Con todo eso en mente, podemos sacar una conclusión muy sencilla, y es que el valor de una tarjeta gráfica no viene determinado únicamente por su rendimiento bruto, ni por la cantidad de memoria gráfica que tenga. La arquitectura y el hardware especializado marcan, al final, diferencias importantes que no podemos obviar. Las tarjetas gráficas GeForce RTX 20 supusieron un salto tan grande gracias a esas dos claves que hoy están viviendo, como anticipamos, una segunda juventud, y están demostrando que su rendimiento en trazado de rayos está al nivel de las Radeon RX 6000, una línea que llegó al mercado dos años más tarde.

En ese contexto, ¿es justo pagar el mismo precio, o incluso más, por una tarjeta gráfica que ofrece un valor claramente inferior? Creo que la pregunta se responde sola. Los que nos leéis a diario sabéis que soy imparcial, y que desde el lanzamiento de las tarjetas gráficas AMD Radeon RX 6000 he valorado muy positivamente el enorme salto que representan en materia de rendimiento y de eficiencia, y también es digno de mención que AMD haya dotado a toda la gama alta de 16 GB de memoria gráfica.

El FSR de AMD genera una pérdida muy grande de nitidez. A la izquierda, resolución nativa, y a la derecha el FSR activado. Clic para ampliar.

Sin embargo, no podemos decir solo las cosas buenas, también hay que tener en cuenta los aspectos negativos, y en el caso de las tarjetas gráficas AMD Radeon RX 6000 está claro que no pueden competir de verdad al mismo nivel que las GeForce RTX 30 si tenemos en cuenta el trazado de rayos y el DLSS. A mi juicio, esto es una razón más que suficiente para que las tarjetas gráficas AMD Radeon RX 6000 deban situarse en un rango de precios más económicos que sus contrapartes.

¿Por qué no han llegado las tarjetas gráficas AMD Radeon RX 6000 a un precio inferior?

Es una pregunta complicada, pero tengo una idea bastante acertada de lo que puede haber ocurrido. Lo primero que debemos tener en cuenta es que cada empresa puede vender sus productos al precio que quiera, y las tarjetas gráficas AMD Radeon RX 6000 no son una excepción. Por otra parte, también hay que tener presente que, cuando vendemos un producto a un precio inferior al de la competencia, estamos «devaluando» dicho producto, generando una sensación en el consumidor de que «es más barato, tiene que ser mucho peor».

AMD lleva un tiempo intentando desprenderse de esa idea, es decir, de la creencia general, y errónea, de que todos sus productos y soluciones son una alternativa «económica e inferior» a los de Intel y NVIDIA. Lanzar las tarjetas gráficas AMD Radeon RX 6000 con un precio notablemente inferior al de las GeForce RTX 30 habría sido lanzar piedras contra su propio tejado, al menos en este sentido.

Tenemos que sumar también a todo lo anterior el tema de los costes. Las GPUs que utilizan las tarjetas gráficas AMD Radeon RX 6000 tienen un coste elevado sobre la oblea porque utilizan una configuración de núcleo monolítico con un alto conteo de shaders, y también porque vienen acompañadas de una gran cantidad de caché L3. AMD tiene que rentabilizar los costes de producción de las tarjetas gráficas AMD Radeon RX 6000, y también los de desarrollo de la arquitectura RDNA 2, que como sabemos es la base de esa generación.

Al final podríamos pensar que todo es un tema de imagen, de costes y de rentabilidad, pero lo cierto es que AMD también ha intentado aprovechar la tendencia de algunos usuarios, y de ciertos medios, de lanzar una mirada a corto plazo cuando se trata de invertir en tecnología. Sí, es importante comprar un producto que rinda bien hoy, pero debemos pensar también en el mañana.

Las tarjetas gráficas AMD Radeon RX 6000 rinden muy bien hoy, pero solo en rasterización, ya que en trazado de rayos su rendimiento se reduce enormemente, y el FSR no es una alternativa realmente atractiva para compensar esa pérdida de rendimiento. El trazado de rayos está experimentando una adopción cada vez mayor, PS5 y Xbox Series X-Series S soportan esta tecnología, y esto ha hecho que los desarrolladores la utilicen cada vez más.

Si las tarjetas gráficas AMD Radeon RX 6000 «pinchan» en trazado de rayos hoy, ¿cómo aguantarán el tipo dentro de un par de años, cuando los desarrollos de nueva generación empiecen a ser la norma? Me atrevo a pensar que no muy bien, y que para entonces las GeForce RTX 30 habrán envejecido mucho mejor, a pesar de que tuvieron un precio recomendado inferior en muchos casos.

Mi conclusión, tras todo lo expuesto, es muy simple. El precio de venta recomendado de las tarjetas gráficas AMD Radeon RX 6000 debería ser inferior, sin ninguna duda. Sé que, con la inflación actual, esto no iba a cambiar gran cosa, pero reflejaría de una manera más apropiada el valor real que ofrece al usuario, y evitaría malentendidos que, al final, acaban siendo forzados por los fanáticos de una y otra marca, y que solo perjudican al consumidor con menos conocimientos.

-

GuíasHace 3 días

GuíasHace 3 días10 sitios web para descargar libros electrónicos gratuitos

-

NoticiasHace 7 días

NoticiasHace 7 díasOMEN Transcend 14, un ultraligero todoterreno con GeForce RTX 4070

-

A FondoHace 5 días

A FondoHace 5 díasNovedades VOD 16/24: ‘Rebel Moon’, la película que deja marcas

-

A FondoHace 6 días

A FondoHace 6 díasTelefónica cumple 100 años, repasamos su historia