A Fondo

¿Por qué Linux no despega en el escritorio?

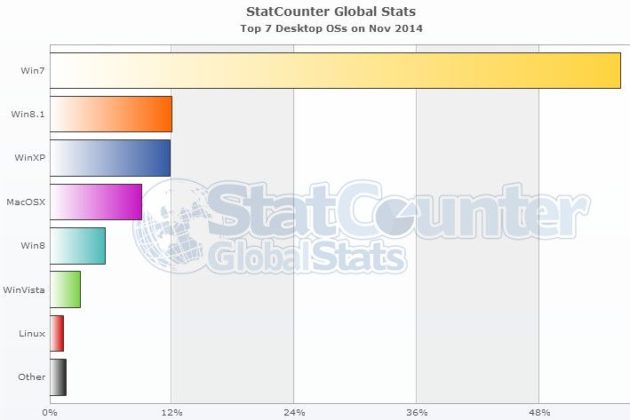

Statcounter ha presentado resultados de cuota de mercado correspondiente a noviembre, encumbrando a Windows 8.1 como segundo sistema operativo del escritorio solo por detrás de Windows 7 y superando por primera vez a Windows XP.

Aunque los resultados de Statcounter son muy distintos a los ofrecidos por otras firmas de análisis como Net Applications por el uso de distintas métricas todo apunta que Windows 8.1 está despegando ganando usuarios de Windows XP, de Windows 8 ya que es una actualización gratuita y también por ventas de equipos nuevos ahora que el mercado PC ha frenado su caída y empieza a remontar.

En cuanto a Windows 7, no hay quien le tosa, es el rey absoluto del escritorio ganando usuarios mes a mes y ya tiene un 56 por ciento de cuota de mercado. Windows Vista es un sistema residual por debajo del 3 por ciento mientras que el OS X tiene un 8,64 por ciento de cuota de mercado, manteniéndose en esos valores los últimos años y sin posibilidad de ascender a no ser que Apple cambie su estrategia y decida volver a licenciar el sistema a terceros fabricantes.

¿Y qué pasa con Linux? ¿Por qué no logra despegar en el escritorio?

Según Statcounter (también Net Applications) la cuota de mercado de Linux en el escritorio es meramente testimonial con cifras que van entre el 1 y el 2 por ciento de cuota de mercado. Muy por debajo de la calidad de su código, su potencial y lo que ha logrado en otros segmentos informáticos.

La semana pasada comentábamos el último informe del top-500 de supercomputadores donde Linux arrasa literalmente, gobernando 485 de las máquinas más poderosas del planeta, lo que representa el 97 por ciento del total. Una cuota de mercado inalcanzable para cualquier otra solución tecnológica del mercado, incluyendo el Windows de escritorio.

En movilidad más de lo mismo. Con Android, Ubuntu OS, Tizen o Firefox OS, Linux domina ampliamente los segmentos de smartphones y tablets. Su presencia en el mercado de servidores es muy destacada. También en el sector de embebidos y en estaciones de trabajo profesionales donde se necesite potencia de cómputo y flexibilidad, como las grandes producciones de películas tipo Gravity, El Hobbit o la alucinante Interstellar.

Además, todo indica que Linux será un referente en el gran mercado del wearable y la Internet de las Cosas, además de estar bien posicionado como base para los desarrollos que van a gobernar las nuevas generaciones de sistema de info-entretenimiento para automóviles.

Como vemos, el sistema libre domina o tiene gran presencia en cualquier sector computacional… excepto en el escritorio. ¿Por qué?

¿Es imposible competir con Windows en el escritorio?

¿Por el dominio de Microsoft del canal, del sector corporativo o administrativo?

¿Por la indiferencia de los grandes fabricantes?

¿Por la falta de libertad de elección de sistemas operativos de los OEM?

¿Por la pre-instalación de Windows en el 99% de equipos nuevos?

¿Por la falta de unificación de entornos de escritorio o gestores de descarga en Linux?

¿Es cuestión de falta de aplicaciones?

¿Por las carencias de Linux en el apartado de juegos?

¿Los análisis son erróneos y Linux se utiliza más de lo que indican los informes?

¿Puede una plataforma como Steam OS empezar a cambiar las cosas?

¿Será Google con la fusión de Android y Chrome OS el que inicie el despegue de Linux?

¿Es Linux hoy tan fácil de instalar y compatible con hardware y software como Windows?

¿Importa al usuario de a pie la libertad, gratuidad y flexibilidad de Linux o apuesta por la facilidad de uso de Windows?

¿Solo interesa Linux a los usuarios más experimentados sin interés para el usuario común?

Muchas preguntas (y otra decena que se nos ocurre) a las que dar respuesta. Con mucho usuario de Linux entre nuestros seguidores seguro podemos llegar a conclusiones interesantes. También interesaría que el usuario de Windows explicase porqué no usa o al menos prueba una distribución GNU/Linux.

-

A FondoHace 2 días

A FondoHace 2 díasQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 5 días

GuíasHace 5 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 14 horas

PrácticosHace 14 horasQué placa base tengo, cómo descubrirlo en segundos

-

NoticiasHace 4 días

NoticiasHace 4 díasWindows 3.1 le gana la partida a CrowdStrike