Noticias

NVIDIA puede diseñar una GPU inspirada en Ryzen, pero todavía no es el momento

Los diseños de núcleo monolítico se han mantenido como la tendencia dominante en el sector GPU, donde tanto NVIDIA como AMD han venido diseñando sus principales soluciones como una única pieza de silicio, pero en el sector CPU vemos un panorama muy distinto.

AMD decidió apostar por un diseño MCM (módulo multi-chip) con su arquitectura Zen, y extenderlo a todas sus líneas y gamas de productos. El resultado fue todo un éxito, así que la compañía de Sunnyvale mantuvo ese esquema con Zen+ y lo consagró con Zen 2, una generación que supone un avance importante frente al diseño que vimos en los primeros Ryzen ya que, como sabrán nuestros lectores habituales, compacta dos unidades CCX en un chiplet y mueve todos los elementos I/O a un chip que se integra en su propio encapsulado.

En un procesador Ryzen los núcleos del procesador y sus componentes clave, como la memoria caché, están agrupados en varias pastillas de silicio que se comunican a través de un sistema llamado Infinity Fabric, mientras que en un procesador Intel Core todos los núcleos y sus elementos básicos se encuentran agrupados en una única pastilla de silicio.

Las GPUs de AMD y de NVIDIA siguen ese concepto. Los motores de sombreado, de texturizado y de geometría, así como las memorias caché y demás elementos básicos, se encuentran integrados en una única pastilla de silicio, lo que significa que mantienen un diseño de núcleo monolítico. Sin embargo, ambas compañías han mostrado recientemente su interés en avanzar hacia diseños MCM, y la propia NVIDIA ha confirmado que ya ha conseguido salir de la «fase de riesgo» asociada a este tipo de arquitectura.

Esto quiere decir que podría aventurarse en el desarrollo de una GPU con arquitectura MCM, pero es algo que, de momento, no consideran necesario. NVIDIA ha querido dar este paso y completar los avances necesarios para hacer posible un desarrollo de este tipo porque lo concibe como «un as bajo la manga», y no descarta utilizarlo cuando sea oportuno. Sé lo que estáis pensando, ¿y cuándo será oportuno? Pues según NVIDIA cuando resulte «viable económicamente».

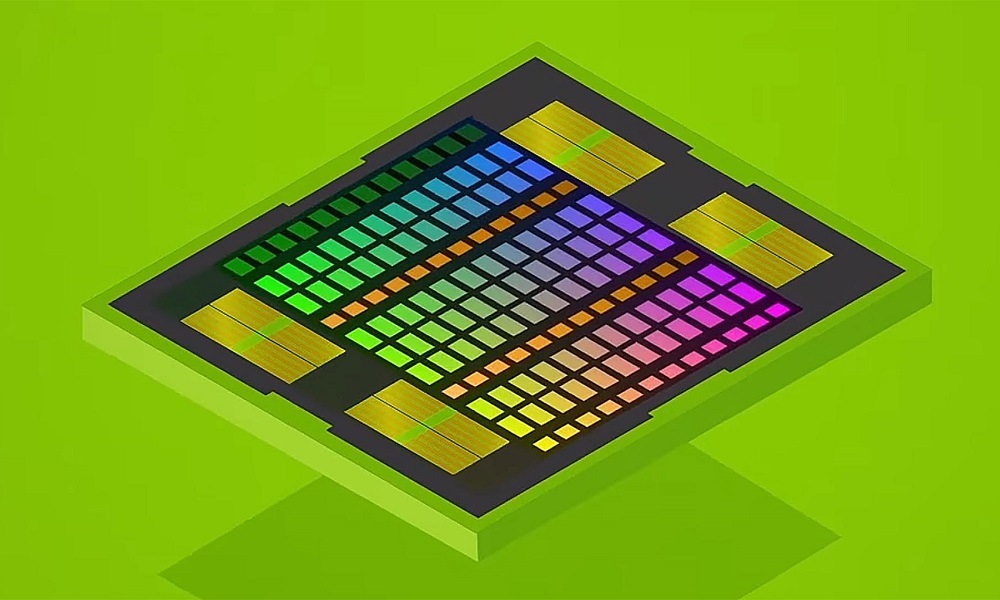

Debemos tener en cuenta que lo que NVIDIA ha logrado no es un avance sobre papel. La compañía ha realizado demostraciones reales con un prototipo de GPU con configuraciones de 16 y 32 módulos que cuenta con múltiples chips trabajando al unísono, aunque las cargas de trabajo que han podido sacar adelante se han limitado al aprendizaje profundo.

¿Cómo sería una GPU de NVIDIA inspirada en Ryzen?

Pues compartiría, como anticipamos, esa idea de modularidad a la que hicimos referencia. Lo entenderemos mejor con un ejemplo concreto. La RTX 2080 Ti tiene las siguientes especificaciones:

- Núcleo gráfico TU102 en proceso de 12 nm.

- 4.352 shaders a 1.350 MHz-1.545 MHz.

- 272 unidades de texturizado.

- 88 unidades de rasterizado.

- 544 núcleos ténsor.

- 68 núcleos RT.

- Bus de 352 bits.

- 11 GB de memoria GDDR6 a 14 GHz efectivos.

Todos esos elementos se integran en una única pastilla de silicio, y la memoria GDDR6 se distribuye a lo largo del PCB sobre el que se montan todos los componentes que dan forma a esta tarjeta gráfica.

Pues bien, con un diseño MCM podría permitir a NVIDIA montar dos o más núcleos gráficos en encapsulados independientes que contarían con sus propios recursos y trabajarían de forma coordinada gracias a la integración de un sistema de comunicación que los vincule. Así, siguiendo este ejemplo, podríamos ver una tarjeta gráfica con dos núcleos gráficos TU102 adoptando un diseño MCM que sumarían 8.704 shaders en total.

Puede que la idea os recuerde a las tarjetas gráficas con doble GPU, como la GTX 690, y sí, es un concepto parecido, pero no igual, ya que en aquél ambos núcleos gráficos se integran en un mismo PCB y no en un mismo IHS.

Con un diseño MCM sería más fácil crear GPUs con un mayor conteo de shaders y saltar a procesos de fabricación más avanzados, ya que no es lo mismo tener que lograr chips totalmente funcionales con 8.704 en una única pastilla de silicio que reducir dividir esa cifra en dos (o cuatro) pastillas de silicio. La segunda opción reduce la complejidad del chip y aumenta la tasa de éxito por oblea.

Sin embargo, este tipo de diseños plantean desafíos en lo que respecta al rendimiento y a la optimización, sobre todo en juegos. Sería necesario afrontar una transición que, ciertamente, hoy no resulta viable (y tampoco necesaria).

-

A FondoHace 6 horas

A FondoHace 6 horasDoble SIM: Cómo funciona y por qué es tan útil en algunos campos de uso

-

A FondoHace 9 horas

A FondoHace 9 horasÚltima semana de los Días Naranjas en PcComponentes ¡Aprovecha las ofertas!

-

A FondoHace 6 días

A FondoHace 6 díasZilog finaliza la producción de los Z80, un chip mítico

-

A FondoHace 4 días

A FondoHace 4 díasLos avisos de Microsoft frente al final del ciclo de vida de Windows