Que haya mucho misterio en torno a la futura Nintendo Switch 2 (nombre todavía no oficial) es algo que no debería sorprender a los que conozcan...

NVIDIA ha confirmado las novedades que llegarán a GeForce Now esta semana, y también ha dado información sobre las nuevas implementaciones y actualizaciones de NVIDIA DLSS...

La tecnología NVIDIA DLSS 3.5, también conocida como reconstrucción de rayos, se ha convertido en uno de los avances más importantes que ha experimentado la inteligencia...

La tecnología Instant NeRF ha sido toda una revolución por su capacidad de generar imágenes 3D inmersivas partiendo de imágenes planas en 2D. Su presentación no...

Las novedades de este jueves en GeForce Now giran alrededor de una franquicia muy querida, Fallout. El estreno de la serie de acción real tuvo lugar...

Toda tecnología que aspire a cambiar y transformar el mundo debe establecerse sobre unos cimientos sólidos. Los pilares de la IA no son una excepción, esta...

Aunque al hablar de NVIDIA DLSS lo común es pensar en la tecnología de reescalado inteligente basado en inteligencia artificial, en realidad y con el tiempo...

Las GeForce RTX 5080 y GeForce RTX 5090 serán las dos tarjetas gráficas más potentes dentro de la serie GeForce RTX 50, una nueva generación que...

La lista de novedades que trae GeForce Now para el mes de abril es una de las más completas, y más interesantes, que hemos visto en...

Este nuevo episodio de la serie NVIDIA AI Decoded se centra en el papel que juega la inteligencia artificial para conseguir NPCs más realistas, un avance...

Mes a mes, la encuesta de Steam nos proporciona información muy útil sobre el conjunto de hardware y software empleado por sus usuarios. Contrariamente a lo...

En este nuevo artículo de la serie NVIDIA AI Decoded nos centramos en TensorRT, un kit de desarrollo especializado en tareas de inferencia y aprendizaje profundo...

Hoy nos toca repasar las novedades que, como cada jueves, llegan a GeForce Now, el conocido servicio de juego en la nube de NVIDIA. En esta...

Sabemos que las GeForce RTX 50 utilizarán memoria GDDR7, pero como os he dicho en ocasiones anteriores no estaba claro si dicha memoria será utilizada en...

La IA generativa ha sido una de las grandes protagonistas de la GTC 2024, y como no podía ser de otra forma esta tecnología también se...

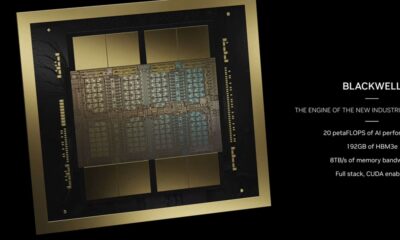

La gran estrella de la GTC 2024 ha sido, sin duda, NVIDIA Blackwell, la nueva arquitectura GPU que el gigante verde lanzará este mismo año, y...

La GTC 2024 nos ha dejado ya algunos anuncios y demostraciones interesantes que, como no podía ser de otra manera, están profundamente ligados a la IA....

La NVIDIA GDC de este año dará comienzo el 18 de marzo, pero ya tenemos algunas novedades importantes que podemos compartir con vosotros antes de que...

Como cada jueves volvemos a la carga con las novedades más importantes de GeForce Now, el conocido servicio de juego en la nube de NVIDIA que...

Nuevo capítulo de la serie semanal NVIDIA AI Decoded, que arrancó la semana pasada con un artículo centrado en algunas de las claves más importantes en...

El lanzamiento de las GeForce RTX 50 se espera para finales de este mismo año. Poco a poco nos estamos acercando a esa fecha, y como...