Noticias

¿Debería matarte tu coche autónomo si con ello se salva más de una vida?

Son las 12:03 del doce de febrero de 2026. Mientras tu coche autónomo te lleva al trabajo, te relajas tranquilamente repasando las últimas noticias en tu smartphone; de repente, dos ancianos despistados cruzan con el semáforo en rojo y el procesador de tu automóvil debe tomar una decisión en milisegundos: ¿debería protegerte aunque ello suponga atropellar a los dos peatones imprudentes? ¿dos vidas valen más que una y por ello debe salvarlos aunque ello suponga un accidente mortal? ¿Qué es lo que vosotros haríais en esa situación?

A estas alturas, pocos dudan de que en menos tiempo de lo que pensamos veremos coches sin conductor por las calles de nuestras ciudades. Estos vehículos incoporarán multitud de sensores y cámaras que le dotarán de unos sentidos muchos más avanzados que los nuestros; podrán ver en la oscuridad, tener perspectiva de 360º sobre el entorno, comunicarse con otros coches o evaluar, mucho más rápido que nosotros, si es posible hacer una determinada maniobra con seguridad. Pero… ¿qué ocurre con las decisiones que tienen que ver con la moral y la ética?

Como comprenderéis, el debate aquí va mucho más allá de lo tecnológico; mientras conducimos se pueden producir infinidad de situaciones en las que debemos decidir cómo reaccionará la máquina. ¿Deben los fabricantes instalar una configuración «ética» de serie? ¿Es mejor dejar a cada usuario que personalice estas opciones en función de sus preferencias? ¿Debe ser un organismo independiente (como la DGT en España) la encargada de diseñar un «estándar de comportamiento» para todos los coches, independientemente de marcas y dueños?

Llegados a este punto es importante comprender que, por mucha información que tengamos (incluyendo toda la que pueda proporcionar el universo GTA), hay cuestiones realmente complicadas de resolver. El enigma del túnel, planteado hace un par de años en una revista especializada, plantea el siguiente escenario: viajas en un coche autónomo por una carretera de montaña de carril único y, justo antes de entrar en el túnel, un niño trata de cruzar y se cae justo en la entrada; el coche debe elegir entre dos opciones, continuar de frente y atropellarlo o girar, provocando un accidente que supondría tu muerte. ¿Qué escogeríais vosotros?

Los resultados de la encuesta son reveladores: un 64% indicó que el coche debería seguir adelante atropellando al niño y, a la cuestión sobre quién debería tomar esta decisión, un 44% aseguraban que debería ser el conductor (pasajero en este caso), un 33% que deberían ser los legisladores (instalando una configuración determinada en el vehículo) y un 12% opinó que la decisión compete al fabricante del vehículo.

¿Qué ocurre cuando la decisión óptima es matarte?

Es evidente que no estamos ante un problema de potencia de cálculo o de almacenamiento de cientos de escenarios predefinidos, sino que la solución debe estar en la intersección entre lo tecnológico y lo social. En este sentido, el trabajo del MIT dirigido por Iyad Rahwan es uno de los primeros que intenta abordar el tema con toda su complejidad.

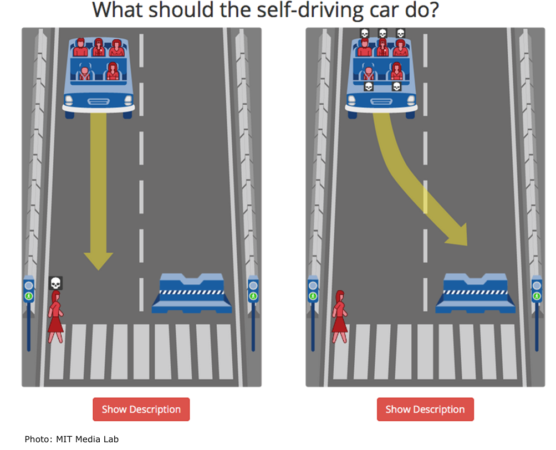

Para ello, han diseñado su propia Máquina de la Moral (http://moralmachine.mit.edu/hl/es) donde se proponen al usuario diversos escenarios que debemos resolver y que os invitamos a probar. Con las respuestas obtenidas, se intentan establecer cuál sería el comportamiento que debería tener el coche autónomo desde el punto de vista de miles de personas, buscando patrones comunes.

¿Es mejor atropellar a la mujer que cruza o tener un accidente?

¿Es mejor atropellar a la mujer que cruza o tener un accidente?

«Casi todo el mundo quiere coches que minimicen los daños totales. Los problemas vienen cuando les preguntamos si lo comprarian. Su reacción fue: nunca compraría un coche que me pudiera hacer daño bajo ninguna circustancia» asegura el profesor Rahwan en una entrevista concedida a One. «Si dejamos cada vez más decisiones en manos de las máquinas, también debemos desarrollar un contrato social entre la gente y los algoritmos encargados de tomar esas decisiones; así los podremos supervisar, hacerlos responsables y poder desconectarlos, si fuera necesario»

Para finalizar os invitamos a probar el test y conocer qué tipo de decisiones tomaría un coche programado por vosotros; quizás descubráis que sois mucho más altruistas de lo que pensáis o todo lo contrario, que nadie se interpone cuando es tu vida la que está en juego. Os animamos a continuar el debate en los comentarios.

Más información | Máquina de Moral del MIT

-

GuíasHace 4 días

GuíasHace 4 días10 sitios web para descargar libros electrónicos gratuitos

-

A FondoHace 6 días

A FondoHace 6 díasNovedades VOD 16/24: ‘Rebel Moon’, la película que deja marcas

-

AnálisisHace 5 días

AnálisisHace 5 días‘Ereban: Shadow Legacy’, juego de sombras

-

GuíasHace 7 días

GuíasHace 7 díasCómo instalar el soporte multimedia en Ubuntu, Linux Mint, Fedora y Flatpak