A Fondo

Ley de Moore: qué es, cómo ha influido en la computación mundial y su futuro

La Ley de Moore es el gran legado de Gordon E. Moore, ingeniero, doctor en física y química y co-fundador de Intel que falleció el pasado fin de semana y al que le rendimos desde aquí un merecido homenaje como otro de los «padres» de la informática moderna. Pero, ¿qué es exactamente esta ley y cómo influyó de manera decisiva en la computación moderna?

Qué es la Ley de Moore

Se trata de un enunciado simple, pero muy ambicioso. Una ley empírica donde Moore predecía que el número de transistores por unidad de superficie en los circuitos integrados se duplicaría cada año, con un aumento mínimo en los costes y que la tendencia continuaría durante las siguientes dos décadas. Este enunciado, formulado en abril de 1965, fue revisado por el ingeniero en 1975 al comprobar que esta progresión era imposible de cumplir y redefinió su famosa ley estableciendo que la duplicación de los transistores sucedería aproximadamente cada dos años.

Más allá del aumento de tiempo en su cumplimiento, esta ley ha sido una máxima para el desarrollo de chips en Intel y en toda la industria, ya que definió la estrategia de negocios en la industria de semiconductores, permitió la aparición del microprocesador y más tarde del ordenador personal. Hay que resaltar que la Ley de Moore no solo se refiere a computadoras sino a cualquier tipo de circuito integrado. Es un componente vital para toda la industria y ha terminado encumbrando a la rama tecnológica a la cabeza mundial.

El efecto de la «ley» fue mucho más allá de un simple aumento del número de unos transistores que habían sido inventados por John Bardeen en los Laboratorios Bell de Estados Unidos en 1947 al posibilitar que la tecnología se volviera más eficaz en cada generación. Tan importante como el rendimiento fue la reducción de costes, con una relación inversamente proporcional y como resultado, la industria pudo desarrollar nuevos productos y servicios.

Comparado con la primera CPU de simple chip, el Intel 4004, un chip moderno puede multiplicar por miles de veces su rendimiento y eficiencia energética, al tiempo que rebaja sus costes a 1/60 milésimos del 4004. Y qué decir de otros aspectos importantes como su tamaño. Los primeros transistores semiconductores eran del tamaño de una uña y las supercomputadoras de los 70 ocupaban una habitación entera. Hoy, para ver un único transistor tendríamos que ampliar un único chip al tamaño de una casa. En cuanto al rendimiento, un simple smartphone tiene más potencia de cálculo que esas supercomputadoras.

El origen de la Ley de Moore

Si tienes curiosidad de conocer de dónde vino esta ley, nada mejor que acudir a las explicaciones que ha ido realizando el mismo ingeniero y que nos ponen sobre la pista de su origen desde que fundara junto a otros siete pioneros Fairchild Semiconductors.

«A principios de 1960 seguíamos desarrollando la tecnología de semiconductores y haciéndola cada vez más práctica. Era una tecnología difícil de implementar con las herramientas que inicialmente teníamos disponibles. Me convertí en el director de I + D en Fairchild Semiconductor, gestionando el laboratorio y buscando qué podríamos hacer a medida que mejorábamos la tecnología.

Entonces, la Electronics Magazine me pidió que enviara un artículo para su 35ª edición anual prediciendo lo que iba a suceder en la industria de componentes de semiconductores en los próximos 10 años. Así que tomé la oportunidad de analizar lo que había ocurrido hasta ese momento. Esto sucedió en 1964, supongo. Miré los pocos chips que habíamos hecho y me di cuenta que pasamos de un único transistor en un chip a un chip con cerca de ocho elemento, transistores y resistencias.

Los nuevos chips que llegaban tenían cerca del doble de la cantidad de elementos; aproximadamente, 16. Y en el laboratorio, estábamos creando chips con cerca de 30 elementos, buscando la posibilidad de fabricar dispositivos con el doble de esa cantidad: alrededor de 60 elementos en un chip. Tomé un pedazo de papel semilogarítmico, tracé esto y, empezando por el transistor plano en 1959, me di cuenta de que, en esencia, duplicábamos a cada año.

Extrapolé la observación y dije que íbamos a continuar duplicando cada año y pasar, de unos 60 elementos en el momento, a 60.000 en 10 años. Al final de los 10 años, si no teníamos 10 duplicaciones de la cantidad de elementos en un chip, al menos teníamos nueve. Así que uno de mis colegas –creo que fue Carver Mead, profesor de Cal Tech– la bautizó como «Ley de Moore», un nombre que se ha adherido mucho más allá de mis cálculos».

¿Hay futuro para la Ley de Moore?

Varias fuentes autorizadas, incluyendo grandes rivales de Intel como NVIDIA, aseguraron hace años que esta ley estaba muerta. El mismo Moore no aseguraba su duración para siempre por las limitaciones propias del uso del silicio como material principal en la industria de los semiconductores. Hay que insistir que no es una ley matemática/física concreta sino una observación/predicción de la capacidad de la industria que desde su origen tenía fecha de caducidad.

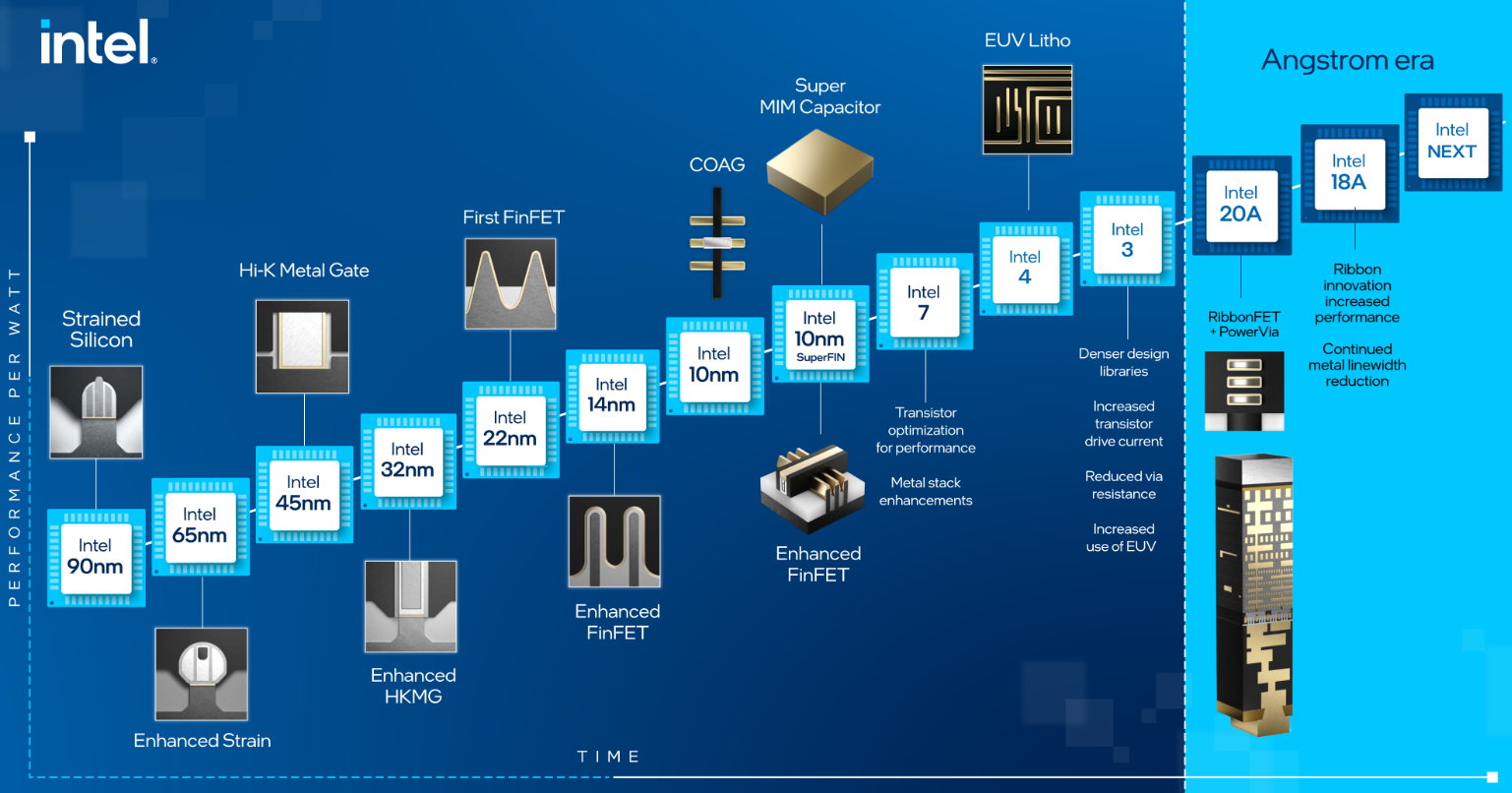

Aún reconociendo que la ley se ha encontrado con barreras naturales a modo de límites físicos, Intel dice estar trabajando en el futuro del procesamiento con alternativas para poder mantenerla que pasan por las mejoras en los procesos litográficos de fabricación, en el empaquetado de los chips y en la misma arquitectura de los mismos. Con estas técnicas, Intel promete entregar 1 billón de transistores en un circuito integrado en 2030.

Intel insiste en ello no solo por motivos técnicos, sino comerciales, con una arquitectura x86 con la que ha dominado con mano de hierro la informática mundial en décadas pasadas, pero que hoy ya no existe, como muestra el trabajo de compañías como Apple con otras arquitecturas como ARM en sus ordenadores personales o las soluciones de NVIDIA con las aceleradoras en centros de datos.

Además, el uso del silicio está alcanzando sus límites (si no lo ha hecho ya). El aumento exponencial de reducción de tamaño y coste de los semiconductores se acabó hace tiempo y con ello la Ley de Moore. Y quizá no por tecnología sino por costes, ya que muy pocos fabricantes pueden permitirse el coste exorbitante de investigación y diseño de las nuevas generaciones de chips, y mucho menos construir y mantener las fábricas para producirlos. La misma Intel ha tenido problemas graves en las transiciones a las tecnologías de proceso de 10 nm.

Y para el futuro, deben imponerse tecnologías completamente nuevas que debe llegar de la computación cuántica. Aquí Intel no está sola, no está a la cabeza de su desarrollo, ni mucho menos tiene el dominio cuando sus microprocesadores abrieron la era moderna del ordenador personal. Aún quedan décadas para su aplicación a nivel de cliente final, pero lo cuántico es la próxima frontera y se trata de una tecnología con un potencial enorme que cambiará todo lo conocido en computación. Descanse en paz el pionero Gordon E. Moore y también su famosa Ley.

-

GuíasHace 6 días

GuíasHace 6 días10 sitios web para descargar libros electrónicos gratuitos

-

A FondoHace 5 días

A FondoHace 5 díasZilog finaliza la producción de los Z80, un chip mítico

-

A FondoHace 2 días

A FondoHace 2 díasEmpiezan los Días Naranjas en PcComponentes, no te pierdas las mejores ofertas

-

AnálisisHace 7 días

AnálisisHace 7 días‘Ereban: Shadow Legacy’, juego de sombras