Noticias

Mucho cuidado con los GPTs de OpenAI

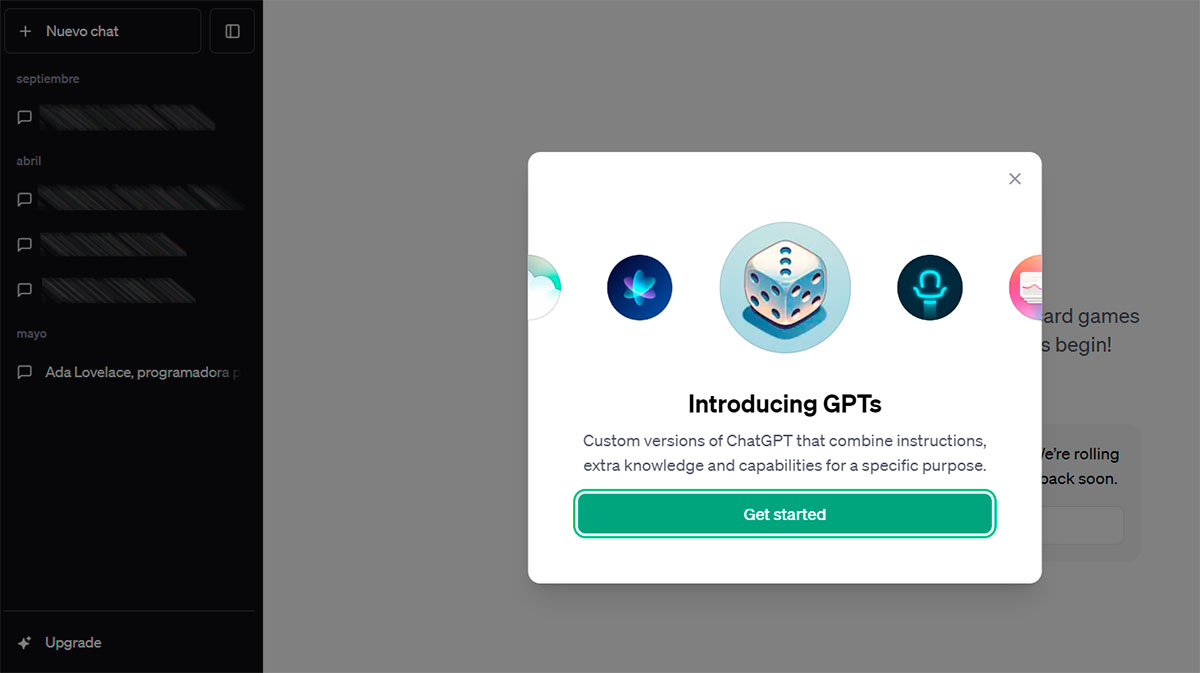

Parece mentira, pero todavía no ha pasado un mes desde que OpenAI presentara los GPTs . Y sí, soy consciente de que, por norma general, al emplear «parece mentira» en relación con el paso del tiempo, lo suelo hacer señalando que ha transcurrido mucho más de lo que parecía, pero en esta ocasión ocurre al contrario, como consecuencia de las tumultuosas peripecias de la cúpula de la compañía. Y es que, como seguramente recordarás, su CEO, Sam Altman, fue súbita y sorpresivamente despedido, posteriormente contratado por Microsoft y, tras una espectacular rebelión por parte de muchos de los trabajadores de la tecnológica, recontratado por la junta directiva que lo había despedido unos pocos días antes. Si no viviste el culebrón exprés en directo, aquí te lo contamos todo.

Sea como fuere, las aguas han vuelto a su cauce y, aunque sí que llegó algo de sangre al río, parece que la normalidad vuelve a imperar (al menos de puertas hacia fuera), aunque en este caso, y para su desgracia, normalidad no es sinónimo de tranquilidad, pues sus productos y servicios siguen estando sometidos a un intenso escrutinio tanto por parte de autoridades y reguladores, como por parte de investigadores independientes en busca y captura de potenciales problemas.

Pues bien, según podemos leer en Wired, los recién estrenados GPTs pueden ser bastante más indiscretos de lo que deberían, algo que compromete sustancialmente la privacidad de los creadores de los mismos o, para ser más exactos, la de los datos que hayan sido empleados para el proceso de entrenamiento específico para personalizar estas réplicas especializadas de ChatGPT.

Como ya te contamos cuando fueron anunciados, los GPTs son chatbots basados en ChatGPT, pero con la particularidad de que pueden ser personalizados por sus responsables, que pueden tanto añadir conjuntos de datos como parametrizar la respuesta a los prompts. Y el problema se encuentra, claro, en que los usuarios de estos chatbots personalizados pueden recurrir a técnicas que se traducirán en que la respuesta revele datos concretos empleados en su personalización.

Según podemos leer en dicho artículo, «Las preocupaciones sobre la privacidad derivadas de la filtración de archivos deben tomarse en serio«, afirma Jiahao Yu, investigador en informática de la Universidad Northwestern. «Incluso si no contienen información confidencial, pueden contener algún conocimiento que el diseñador no quiera compartir con otros, y [que sirve] como la parte central del GPT personalizado«.

Según la investigación llevada a cabo por un equipo de investigadores de dicha universidad, se evaluaron más de 200 GPTs y lo descubierto no podría ser más preocupante, ya que califican como «sorprendentemente sencillo» el lograr acceso a dichos datos, incluso para usuarios sin conocimientos avanzados en lo referido a confección de prompts. Sin duda, OpenAI tendrá que poner medidas, y hacerlo rápido, para solucionar este problema y, mientras tanto, todos aquellos que hayan creado sus propios GPTs, deberían revisar los datos con los que los han alimentado y, si es necesario, deshabilitarlos hasta tener constancia de que estos problemas se han subsanado.

-

A FondoHace 2 días

A FondoHace 2 díasQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 5 días

GuíasHace 5 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 17 horas

PrácticosHace 17 horasQué placa base tengo, cómo descubrirlo en segundos

-

NoticiasHace 5 días

NoticiasHace 5 díasWindows 3.1 le gana la partida a CrowdStrike