A Fondo

5 alternativas gratuitas a Microsoft Office

Hemos publicado una versión más actualizada de este artículo -> Siete alternativas a Microsoft Office, gratuitas y para uso local y on-line

__________________________

Microsoft Office lleva aproximadamente tres décadas dominando el mercado de las suites ofimáticas, un dominio que está más que justificado, ya que las distintas versiones lanzadas siempre se han mostrado como lo mejor dentro de su segmento, pudiéndose decir que hasta muy por encima de sus competidores.

Sin embargo, el hecho de que Microsoft Office (MS Office) sea una solución muy completa y llena de posibilidades hace que muchas de sus características resulten prescindibles para la mayoría de los usuarios, que usan poco más que el procesador de textos (Word) a nivel básico.

Además, al igual que pasa con los navegadores web, el fuerte dominio de un producto no quiere decir que no haya alternativas, sino más bien al contrario. En la actualidad hay muchas opciones gratuitas bastante competentes que pueden hacer que el usuario básico se olvide de MS Office, y de las cuales vamos a mencionar cinco.

LibreOffice

A día de hoy es la alternativa más sólida a Microsoft Office y la más mediática. De hecho, en MuyComputer damos bastante cobertura a esta suite cuyo desarrollo se inició a partir de una bifurcación de OpenOffice por parte de la comunidad.

Además de ser gratuito, es un proyecto software libre publicado bajo diversas licencias, aunque la principal es la MPLv2.0. Sus aplicaciones son Writer (procesador de textos), Calc (hojas de cálculo), Impress (diapositivas), Math (creación y edición de fórmulas matemáticas), Draw (editor de gráficos vectoriales) y Base (gestión de bases de datos similar a Access).

Aunque cualitativamente está lejos de MS Office, LibreOffice es una solución bastante completa que puede cubrir las necesidades de más del 90% de los usuarios. Por defecto utiliza su propio formato de documentos, ODF, aunque también soporta tanto los más recientes (Docx, Xlsx, Pptx… ) como los antiguos (Doc, Xls, Ppt… ) de Microsoft. Es multiplataforma, abarcando Windows, Mac y Linux (suele ser la suite de referencia en el caso del último).

En caso de utilizar varios sistemas operativos distintos para el escritorio y preferir una suite ofimática que funcione localmente, LibreOffice se perfila como la solución de referencia ante estas situaciones.

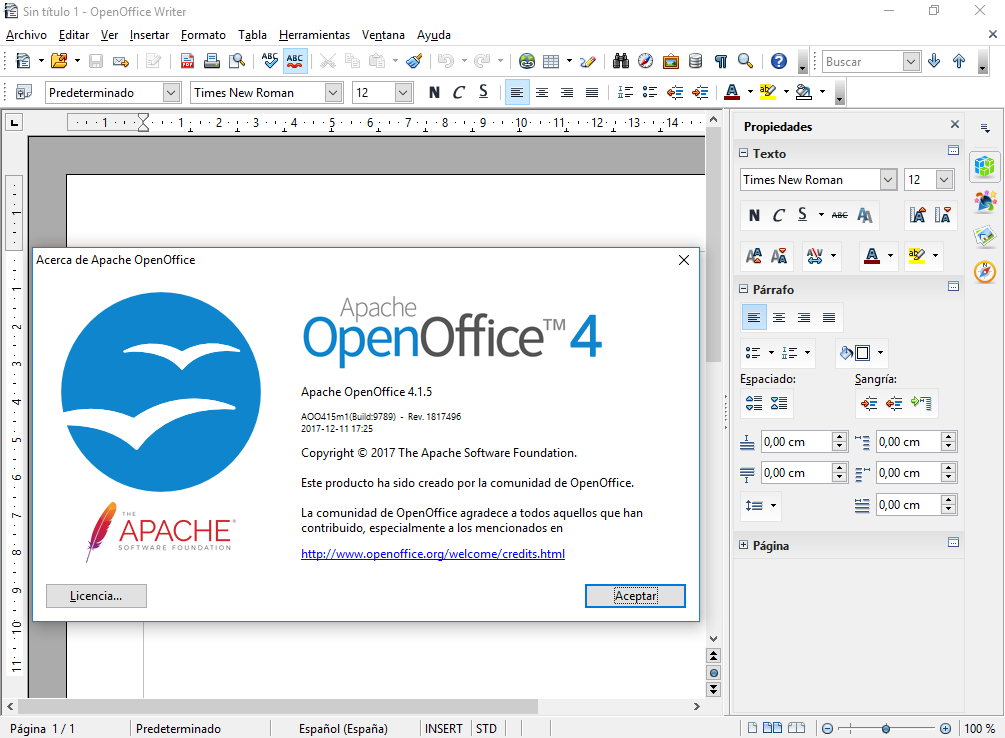

OpenOffice

Es el “padre” de LibreOffice y fue durante muchos años la gran referencia de la suites ofimáticas libres. Anteriormente llamado OpenOffice.org y nació en el año 2000 fruto de la liberación del código fuente de StarOffice por parte de Sun Microsystems.

Pasó a estar bajo Oracle tras adquirir esta a Sun Microsystems y luego fue donada en 2011 a la Fundación Apache, que desde entonces es la encargada de gestionar OpenOffice como proyecto e impulsar su desarrollo. Esto trajo consigo el cambio de licencia a Apache, y aunque en principio pudo responder al desafío que supuso LibreOffice, terminó claudicando de facto debido a la menor cantidad de recursos de los que dispone. El hecho de que LibreOffice haya mostrando una gran evolución en los últimos años ha forzado a OpenOffice a luchar por no caer en la irrelevancia.

Pese a todo, sigue siendo una suite ofimática muy capaz y que ofrece soporte para Windows, Mac y Linux. Como aplicaciones cuenta con las mismas que LibreOffice bajo los mismo nombres y soporta los formatos de Microsoft, aunque no es capaz de exportar, al menos por defecto, a los formatos más recientes del gigante de Redmond para documentos de ofimática.

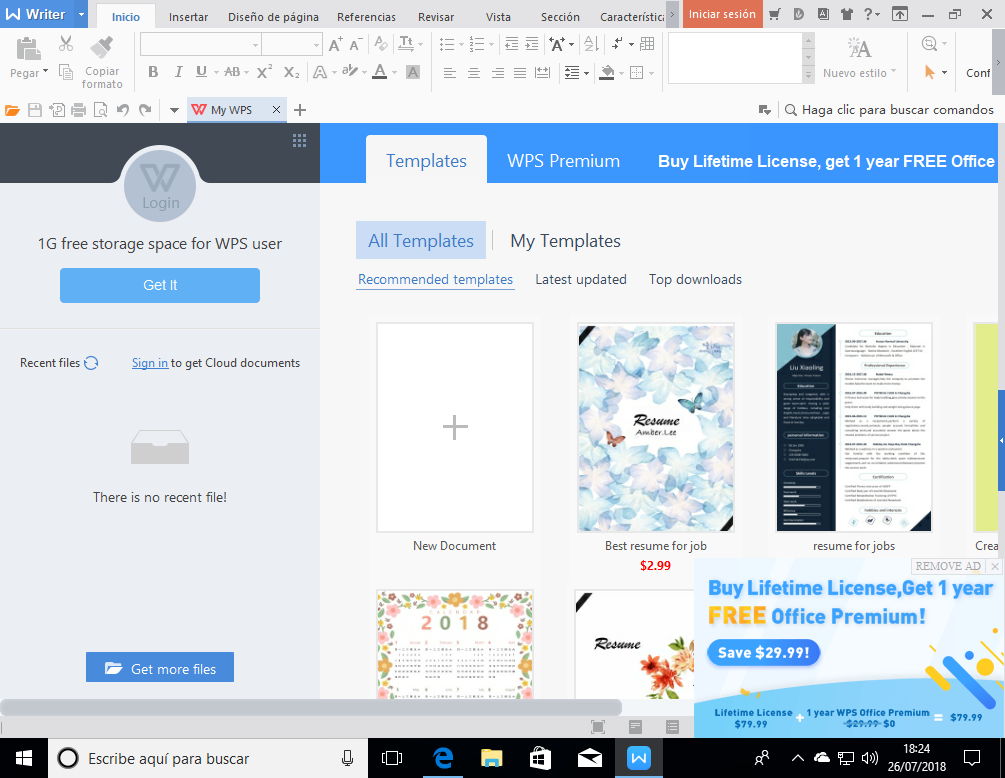

WPS Office

WPS Office es otra alternativa gratuita a MS Office, aunque es un software privativo de origen chino que no tiene ninguna vinculación con OpenOffice.

WPS Office, que anteriormente se llamaba Kingsoft Office, destaca sobre todo por lo bien que soporta los documentos bajo los formatos de Microsoft, haciendo que muchos usuarios prefieren utilizarlo como alternativa a MS Office frente a LibreOffice y OpenOffice. Aunque no lo parezca, se trata de un proyecto bastante veterano, cuya primera versión apareció en 1988.

Entre sus aplicaciones cuenta con un procesador de textos (Writer), hojas de cálculo (Spreadsheets) y diapositivas (Presentations). No tiene ningún software para la gestión de bases datos, manipulación de fórmulas matemáticas ni manipulación de gráficos vectoriales. Pese a ello, como ya hemos comentado al principio, la mayoría de los usuarios utilizan poco más que el procesador de textos de forma básica, así que esta solución cubre de sobra sus necesidades. Tiene una versión de pago con más características frente a la gratuita.

Oficialmente ofrece soporte para Windows, Mac, Android, iOS y Linux, aunque los usuarios de este último sistema se han quejado en más de una ocasión del trato recibido por parte de Kingsoft.

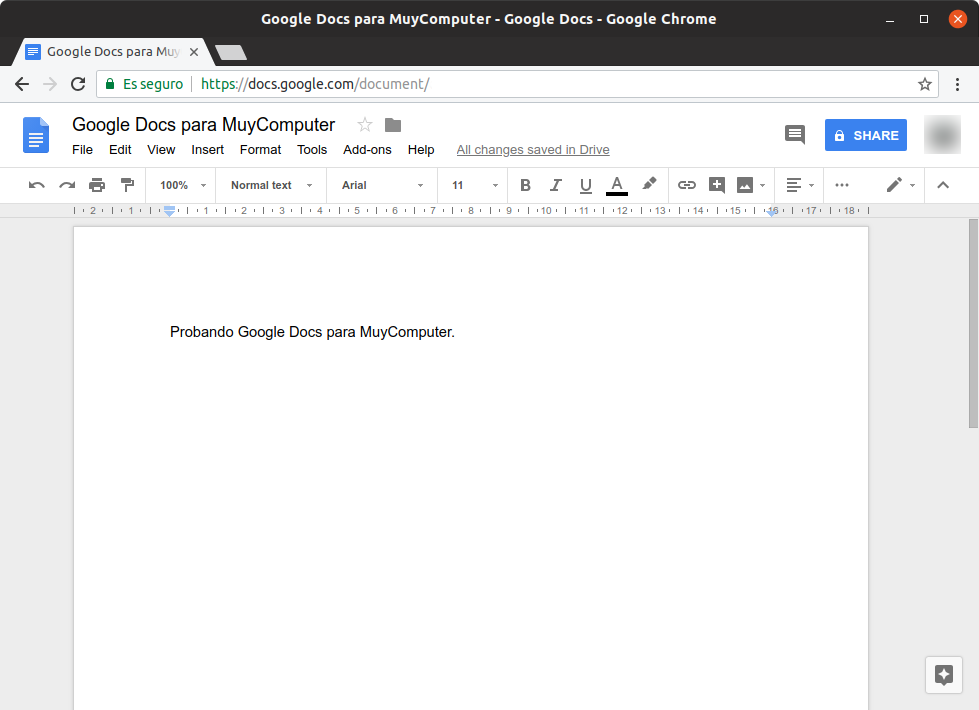

Google Docs

Vivimos en una era en la que el almacenamiento en la nube ha ganado mucho protagonismo, así que la utilización de una suite ofimática que funcione a través de Internet puede ser una buena alternativa. Además de ahorrar espacio en disco, se gana en otros aspectos como la posibilidad de poder editar los documentos en cualquier lugar e incluso a través de múltiples dispositivos, con la única limitación de necesitar conexión a Internet (aunque muchas suites que se instalan de forma local en la actualidad ya ofrecen la posibilidad de guardar o interaccionar con soluciones en la nube).

Debido a la gran difusión de Android, miles de millones de personas tienen al menos una cuenta de Google, así que la utilización de Google Docs está a la alcance de casi todos. A nivel de aplicaciones ofrece procesador de texto (Docs), hojas de cálculo (Sheets), presentaciones (Slides), software de encuestas (Forms), creación de web (Sites), editor de superposición de mapas (My Maps), editor de código para el lenguaje G-Apps Script (Apps Script) y gestor de bases de datos (Fusion Tables).

A nivel de escritorio posiblemente sea más sencillo utilizar Google Docs a través del navegador web Google Chrome u otro basado en Chromium, aunque en dispositivos móviles (iOS, Android y BlackBerry) sería preferible utilizar las aplicaciones oficiales. Los documentos generados, subidos o compartidos se guardan en Google Drive y permite subir y descargar tanto en los formatos de LibreOffice y OpenOffice como los más recientes de Microsoft.

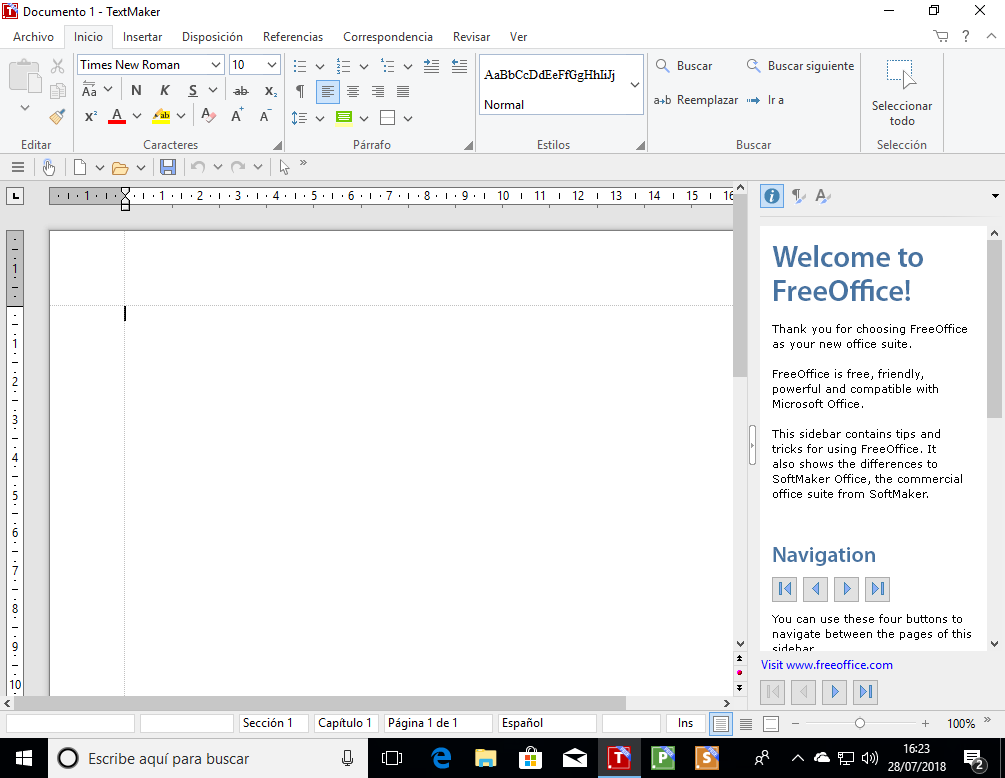

FreeOffice

FreeOffice es una suite ofimática gratuita basada en la tecnología de SoftMaker Office (que es de pago e incluye más características), cuya desarrolladora es la empresa alemana SoftMaker Software. Lo primero que destaca de esta suite es el hecho de utilizar una interfaz gráfica al estilo Ribbon y está optimizada para su uso en pantallas táctiles.

FreeOffice tiene como aplicaciones un procesador de textos (TextMaker), hojas de cálculo (PlanMaker) y presentaciones (Presentations). Es software privativo y su principal virtud es el soporte que ofrece para formatos de documentos más recientes de Microsoft, además de manejar los suyos propios. Está disponible para Windows, Linux y Android y pesar de no ser mediático se trata de un desarrollo veterano, ya que la primera versión apareció en el año 1994.

Conclusión

A pesar de que Microsoft Office es omnipresente, esto no quiere decir que no haya alternativas gratuitas de calidad que puedan cubrir satisfactoriamente las necesidades de los usuarios, sobre todo aquellos de un perfil más básico. Estas alternativas ofrecen en muchos casos un mejor soporte multiplataforma al abarcar Linux o bien apoyarse en la web, lo que disminuye la dependencia del sistema operativo (en el caso de Google Docs, hasta Chrome OS sirve).

-

A FondoHace 1 día

A FondoHace 1 díaQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 4 días

GuíasHace 4 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 10 horas

PrácticosHace 10 horasQué placa base tengo, cómo descubrirlo en segundos

-

NoticiasHace 4 días

NoticiasHace 4 díasWindows 3.1 le gana la partida a CrowdStrike