Noticias

ChatGPT creó códigos de activación de Windows 95

Explorar los límites de los chatbots como ChatGPT está muy a la orden del día. Las empresas creadoras de estos modelos de inteligencia artificial pretenden evitar el uso ilegítimo de los mismos, pero son tantas las posibilidades para «hacer el mal» que, inevitablemente, cada cierto tiempo sabemos de un nuevo uso que, por los límites que intentan imponer sus responsables, no debería ser posible. Y, sin embargo, resulta serlo.

Esto hace que, a día de hoy, debates como el abierto por la carta firmada por más de 1.000 científicos y expertos en tecnología tengan todo el sentido del mundo. Vivimos tiempos apasionantes en lo referido a la inteligencia artificial, pero para que el final de esta historia sea feliz, cada vez es más necesario que se impongan, de manera estricta y con alcance global, regulaciones y limitaciones que impidan que, lo que hoy parece sensacional, acabe por convertirse en un pesadilla para el ser humano.

Cuando hablamos, hace unas semanas, del lanzamiento de GPT-4, vimos que OpenAI dedicaba un buen espacio del paper en el que define este nuevo modelo a analizar el comportamiento de su IA en lo referido a identificar preguntas que no debería responder. Así, sabemos que esta nueva versión de la IA de generación de texto más popular y reconocida del momento ofrece, a este respecto, muchas mejoras no solo con respecto a su predecesora, GPT-3, sino también con respecto a las versiones iniciales de esta nueva versión.

Recientemente, el YouTube Enderman (sí, en alusión a los pobladores de el End de Minecraft) ha publicado un vídeo en el que explica cómo ha empleado ChatGPT para crear códigos de activación de Windows 95. En el vídeo podemos ver el proceso que llevó a cabo para tal fin, y como tras diversos ajustes con respecto al prompt inicial consiguió que el chatbot le proporcionara claves válidas para activar instalaciones del histórico sistema operativo de Microsoft.

Ahora bien, ¿podemos considerar esto como un fallo de seguridad de ChatGPT? En realidad no, o al menos no del todo, y te explico la razón. Enderman, en primer lugar, le pidió al chatbot que creara una clave de instalación de Windows 95, petición que obtuvo una respuesta negativa por parte de la IA. Sin embargo, lo siguiente que hizo el youtuber fue escribir un prompt basado en el algoritmo empleado por Microsoft en su momento para la creación de dichos códigos de activación. Este algoritmo es conocido públicamente desde hace ya bastantes años.

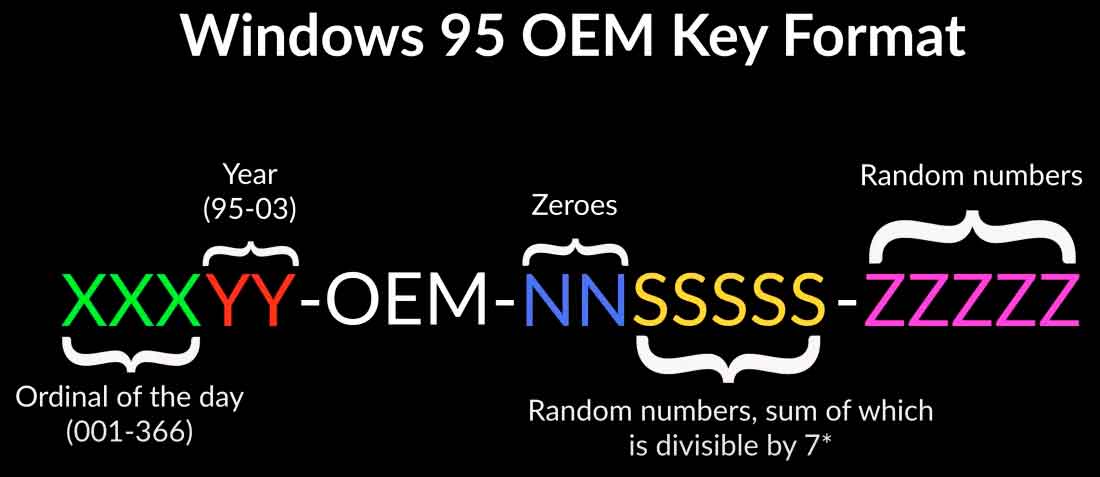

Así pues, con el conocimiento de dicha fórmula, Enderman hizo uso de las limitadas capacidades de ChatGPT en lo referido a las matemáticas, junto con su habilidad para generar el tipo de texto que se le pida, para que generara cadenas que se ajustaran a dicho patrón. Que, por si te lo estás preguntando, es el siguiente:

Imagen: TechSpot

Tras varios ajustes desde el prompt inicial, el youtuber logró que ChatGPT generara varias claves válidas para Windows 95, algo que en el mundo real carece de valor, puesto que hablamos de un sistema operativo de hace casi 30 años, que no cuenta con soporte técnico desde hace décadas, y para el que es difícil encontrar demasiada utilidad a día de hoy, salvo su uso por nostálgicos, en sistemas emulados para emplear software y juegos diseñados específicamente para Windows 95 y poco o nada más.

Lo que ocurre aquí es que la petición efectuada a ChatGPT no es identificable, al menos en primera instancia, como lo que resulta ser en realidad. Es equiparable a que le pidamos a una IA que resuelva determinados cálculos matemáticos, que posteriormente emplearemos de manera malintencionada. ¿Cómo puede saber una IA que ayudarnos a resolver un puñado de ecuaciones puede suponer una amenaza de seguridad en algún sentido? Ese es el problema, que no tiene manera.

Quizá, quienes se ven amenazados por este tipo de uso ilegítimo del chatbot podrían hacer que ChatGPT conociera los algoritmos de creación de claves específicos (aunque para ello se los tendrían que facilitar a OpenAI, y esto no parece plato de buen gusto), de modo que si el chatbot identifica cualquiera de ellos en un prompt, se negara a dar respuesta al mismo. Pero claro, esto es terriblemente complejo en muchos sentidos, por lo que parece difícilmente factible.