A Fondo

NVIDIA AI Decoded: NPCs más realistas gracias a la inteligencia artificial

Este nuevo episodio de la serie NVIDIA AI Decoded se centra en el papel que juega la inteligencia artificial para conseguir NPCs más realistas, un avance que a mi juicio es sin duda uno de los más importantes que nos brindará la AI aplicada a videojuegos a corto y medio plazo.

Pensad, por un momento, en el comportamiento que tienen los NPCs en juegos y en lo poco que estos han evolucionado con los años. Por contra, las mejoras que han experimentado los juegos a nivel de calidad gráfica han sido enormes, y gracias al trazado de rayos podemos disfrutar de efectos de iluminación, sombras, reflejos y cáustica altamente realistas.

Esa desigualdad evolutiva nos ha llevado a una situación en la que tenemos juegos como Cyberpunk 2077, donde podemos encontrar escenas que rozan el fotorrealismo y unos NPCs que en general siguen siendo los mismos «robots» deshumanizados con una o dos frases genéricas pregrabadas. Esto arruina totalmente la inmersión en juegos, sobre todo en aquellos de tipo sandbox en los que tenemos libertad de exploración y de interacción.

NVIDIA ACE hará que los NPCs suban de nivel

Y romperá por fin ese enorme contraste que existe entre la calidad gráfica de los juegos actuales y la baja calidad de los NPCs en general. Para conseguirlo el gigante verde está ofreciendo a los desarrolladores la tecnología NVIDIA ACE bajo un modelo de microservicios. Esta tecnología les permitirá integrar modelos de IA generativa para crear avatares digitales en juegos y aplicaciones, y estos podrán interactuar y conversar de forma dinámica con los jugadores y los usuarios en tiempo real.

Se acabaron las interacciones prediseñadas y repetitivas que además carecían de sentido en los NPCs más básicos y menos relevantes para la historia principal del juego. Gracias a NVIDIA ACE la humanización de los NPCs es algo real, y marcará una de las innovaciones más grandes y más importantes de los últimos años en el mundo de los videojuegos. Por fin vamos a «saldar» una gran cuenta pendiente.

El proceso de crear NPCs es más complejo de lo que parece, y es que al final estos están profundamente vinculados tanto a la historia del juego como a la ambientación del mismo y a los giros que se produzcan en función de las decisiones del jugador, siempre que el juego lo permita. La narrativa debe estar perfectamente prediseñada y el diálogo tiene que contener elementos contextuales relevantes.

Inteligencia artificial para crear NPCs capaces de expresar emociones

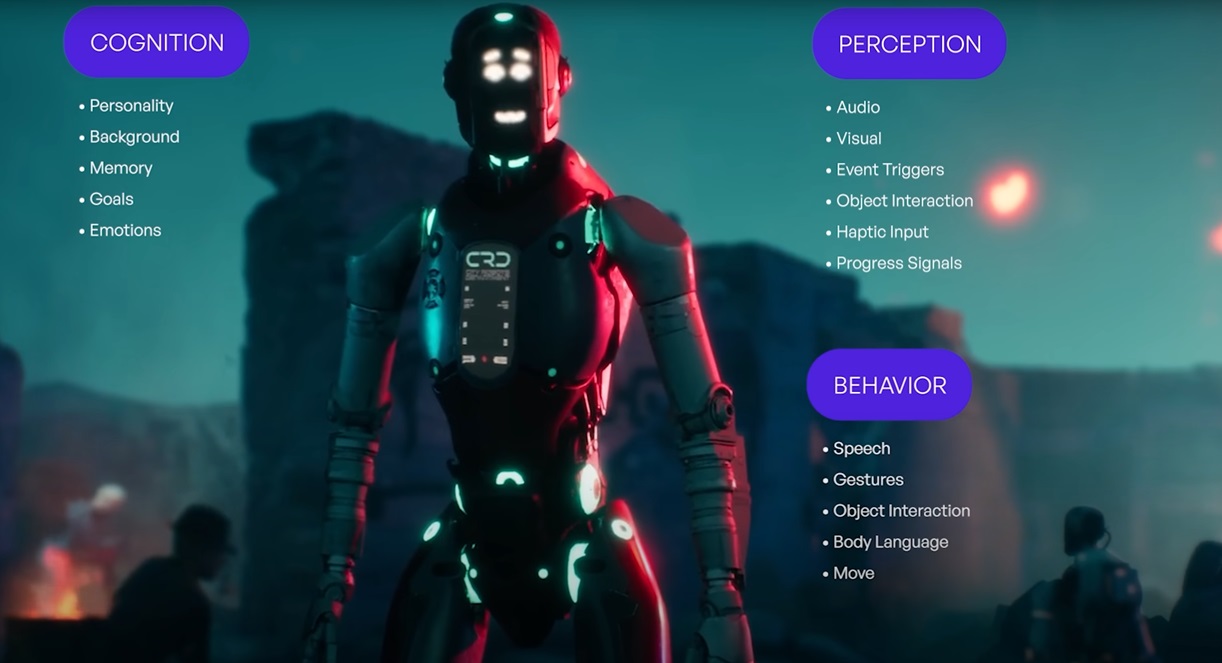

Gracias a NVIDIA ACE los desarrolladores cuentan con un conjunto de subcomponentes que trabajan de forma conjunta para construir una interactividad y una respuesta mejoradas. En total, tenemos cuatro modelos de IA que permitirán a los NPCs escuchar, procesar, generar diálogo y responder al jugador.

La voz del jugador pasa por NVIDIA Riva, una tecnología que es capaz de crear canales de IA conversacionales en tiempo real y totalmente personalizables, que puede convertir a los chatbots (bots conversacionales) en asistentes más realistas y expresivos, utilizando además microservicios de traducción y voz multilingüe que se aceleran a través de la GPU.

Con la función Automatic Speech Recognition (reconocimiento automático de voz) de NVIDIA Riva se lleva a cabo el procesamiento de lo que decimos, y se utiliza IA para conseguir una transcripción precisa en tiempo real en diferentes idiomas. Esa transcripción pasa por un LLM y aprovecha la función de traducción automática neuronal de Riva para generar una respuesta de texto en lenguaje natural. Con la función de texto a voz de Riva se puede generar una respuesta de audio.

NVIDIA Audio2Face es otra tecnología clave, ya que es la encargada de generar expresiones faciales realistas que, además, se pueden sincronizar perfectamente con diálogos en diferentes idiomas. De esta manera es posible crear avatares y NPCs con una expresión mucho más realista y dinámica, tanto en tiempo real como en escenas prediseñadas.

Una red potenciada por IA realiza, de forma automática, el proceso de animación de la cara, los ojos, la boca, la lengua y la cabeza de los NPCs para que todo encaje no solo con la conversación que están manteniendo, sino también con las emociones del momento en el que esa conversación se esté produciendo. Todos los pasos que hemos descrito se producen en tiempo real para asegurar una fluidez total en los diálogos entre el jugador y el NPC.

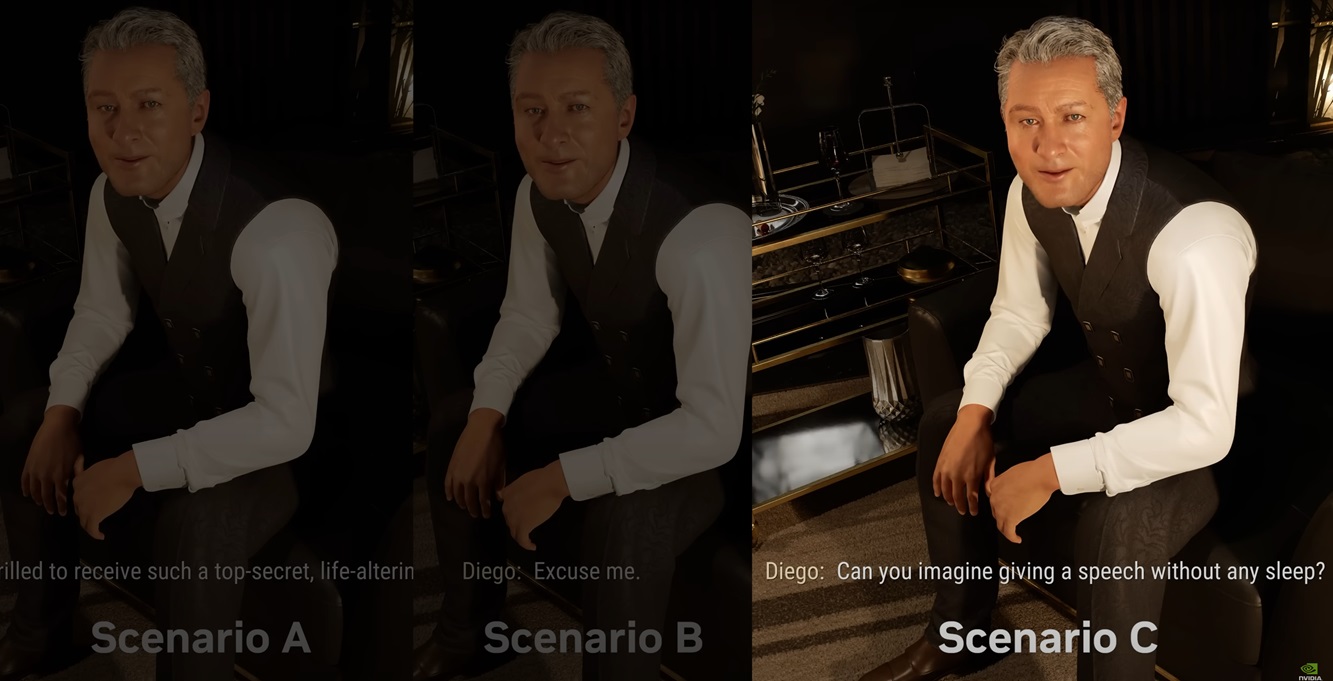

Los grandes del sector ya están empezando a trabajar con esta tecnología, así que es solo cuestión de tiempo hasta que la veamos implementada en juegos comerciales. Ubisoft ha sido una de las primeras en darle su apoyo, y pudimos verla en acción recientemente en la demo técnica Covert Protocol. También os contamos todas las claves de la misma en este artículo que compartimos con vosotros hace unos días.

-

A FondoHace 2 días

A FondoHace 2 díasQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 5 días

GuíasHace 5 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 14 horas

PrácticosHace 14 horasQué placa base tengo, cómo descubrirlo en segundos

-

NoticiasHace 4 días

NoticiasHace 4 díasWindows 3.1 le gana la partida a CrowdStrike