Noticias

Opera ya soporta la ejecución de inteligencia artificial en local

El interés demostrado por los responsables de Opera por la inteligencia artificial ha quedado, sin duda, sobradamente acreditado durante el último año. Y es que no fue el primero en dar ese salto, algo que hizo Edge con la presentación del nuevo Bing, pero sí que fue el primero en responder a dicho movimiento por parte de los de Redmond, anunciando la integración de ChatGPT en su barra lateral menos de una semana después del anuncio de Microsoft.

Alrededor de un mes después empezaron a desplegar la primera integración de la IA en el navegador, y ya a mitades del año pasado debutó la esperada integración en la sidebar. Pero la cosa no acaba ahí, puesto que Opera anunció, a finales de enero, que están trabajando en una versión especial de su navegador para iOS en la que, efectivamente, la integración de la inteligencia artificial será mucho más profunda, al punto de que formará parte de la propia app.

Pues bien, ahora nos encontramos con un paso más en este sentido, y no hablamos de un movimiento menor, puesto que Opera ya está probando el uso de modelos LLM en local. Sí, has leído bien, la intención de los responsables del navegador pasan por complementar Aria, lA ejecutada en la nube y que está disponible desde hace ya algún tiempo en el mismo, con la descarga y ejecución en local de un amplio conjunto de modelos de IA que, claro, nos proporcionan todas las ventajas de no depender de la nube.

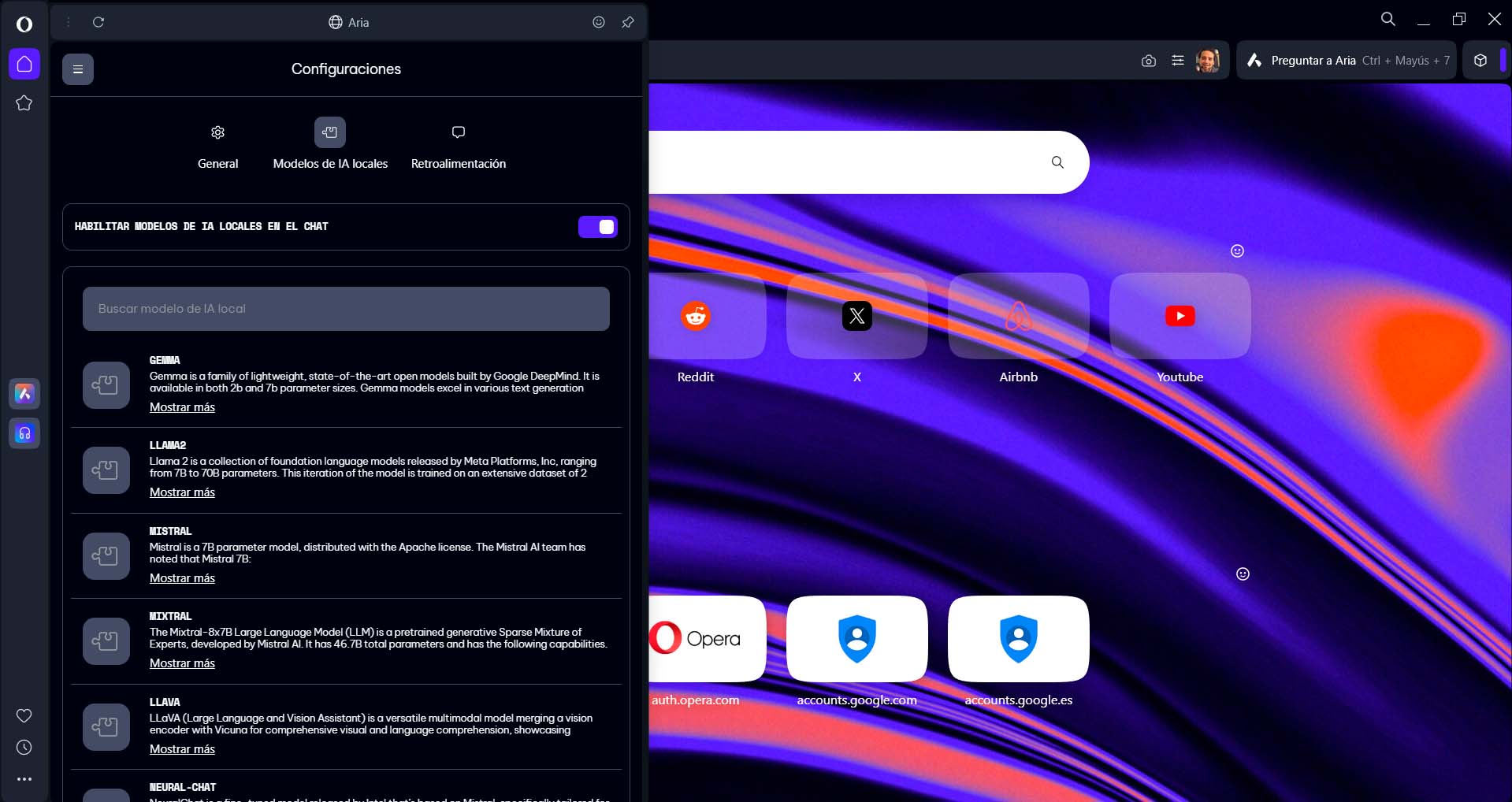

Esta función está disponible, de momento, en la versión para desarrolladores de Opera One, que puedes descargar desde este enlace. Una vez instalada y cuando hayas accedido a Aria (con el botón con una A que se muestra en la barra lateral de la izquierda), tan solo tendrás que iniciar sesión con tu cuenta de Opera (este requisito es imprescindible). Entonces, en la parte superior de la barra lateral, verás un botón con el texto «Elegir modelo de IA local», desde el que podrás acceder a la configuración para descargar el modelo (o modelos) que quieres emplear, de una muy extensa selección.

Una vez descargado e instalado un modelo en Opera, podrás empezar a conversar con él y, si has instalado más de uno, en ese mismo apartado se mostrará un selector en el que podrás escoger el que quieres usar en cada momento. Debes tener en cuenta dos cosas, eso sí. La primera es que, como ya habrás deducido por la versión de Opera que has tenido que descargar, nos encontramos con una función que aún está en fase de pruebas, por lo que su funcionamiento puede ser irregular. Y lo segundo es que, al igual que ya te contamos en el tutorial sobre LM Studio, la ejecución de un LLM en local es una actividad bastante exigente, por lo que no todos los sistemas podrán con ello.

-

A FondoHace 2 días

A FondoHace 2 díasQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 5 días

GuíasHace 5 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 13 horas

PrácticosHace 13 horasQué placa base tengo, cómo descubrirlo en segundos

-

NoticiasHace 4 días

NoticiasHace 4 díasWindows 3.1 le gana la partida a CrowdStrike