El primer domingo de mayo, en este 2023 hoy día 7, es el día de la madre, la fecha elegida para honrar y, si está en...

El 19 de marzo, día de San José, es el dedicado en España (desconozco si también en otras geografías) a celebrar el día del padre, una...

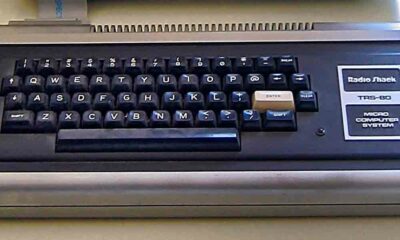

Si quisiéramos hacer una lista de todos los modelos de ordenador que han llegado al mercado desde los primeros momentos del boom de la microinformática hasta...

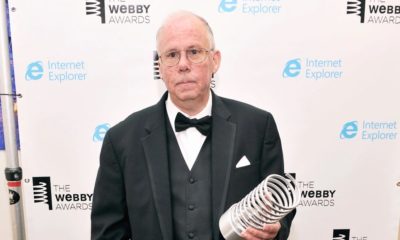

Stephen Wilhite, científico de la computación estadounidense mejor conocido por ser el creador del GIF, falleció el pasado 14 de marzo a los 74 años, aunque...

¿Quién no ha sido víctima de un fallo informático? En mi caso anteayer, sin ir más lejos, Windows decidió que no le apetecía arrancar y, en...

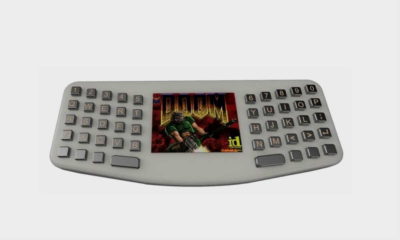

Brian Benchoff, un conocido desarrollador, ha presentado el PC más barato, y totalmente funcional, que hemos podido ver hasta el momento. Se trata de un equipo...

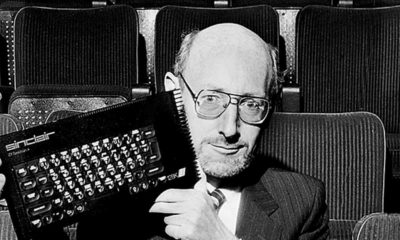

Sir Clive Sinclair fue un visionario, y su nombre debe figurar como uno de los principales artífices de la popularización de la informática. Es más, no...

PCComponentes vuelve a animar el verano con los PcDays 2020, cinco días de grandes descuentos en tecnología e informática, que este año se extienden desde el 6 al 10...

PCComponentes vuelve a animar el verano con los PcDays 2020, cinco días de grandes descuentos en tecnología e informática, que este año se extienden desde el 6 al 10...

PCComponentes vuelve a animar el verano con los PcDays 2020, cinco días de grandes descuentos en tecnología e informática, que este año se extienden desde el 6 al 10...

Los «Días Naranjas» son una nueva campaña promocional de ventas de PcComponentes. Estará activa durante toda esta semana (hasta el 6 de octubre a las 00,00 horas)...

Hace años que la conectividad inalámbrica forma parte de nuestra vida diaria y casi damos por hecho que cualquier dispositivo debe ser capaz de funcionar con...

Muchas tecnológicas actuales, grandes y pequeñas, se jactan de haber comenzado hace unos pocos años su andadura en pequeños desvanes, habitaciones o garajes en Estados Unidos....

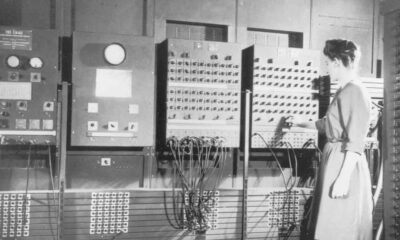

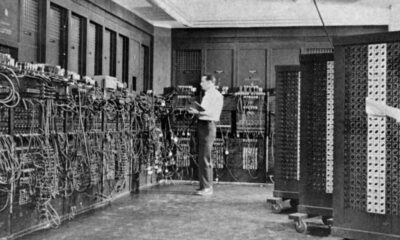

El mundo de la informática ha experimentado una evolución muy grande durante las últimas décadas. Mucho ha cambiado desde que tuve en mis manos mi primer...

Las unidades SSD se han convertido en algo cada vez más habitual gracias a la importante bajada de precio que han experimentado los modelos basados en...

IFA 2018. Acer ha presentado en la feria de Berlín una amplia renovación de catálogo de equipos informáticos, sobremesas, portátiles, convertibles, Chromebooks, AIOs, VR y monitores....

Las unidades SSD se han convertido en algo cada vez más habitual gracias a la importante bajada de precio que han experimentado los modelos basados en...

Con nuevas tensiones geopolíticas de fondo, Kaspersky ha presentado esta semana su nueva línea de antivirus personales para 2018. Unos días después de la compañía rusa...

Son muchos los falsos mitos de la tecnología que todavía hoy se mantienen y campan a sus anchas por todo el mundo, e incluso son recurrentes...

G.SKILL, el fabricante que nos tiene acostumbrados a la fabricación de componentes para PC, sobre todo de memorias RAM, se lleva dedicando desde hace un tiempo...

El gigante de Mountain View por fin ha presentado oficialmente Google Play Family Library, un nuevo servicio que nos permite compartir los contenidos que tengamos en nuestras...