Noticias

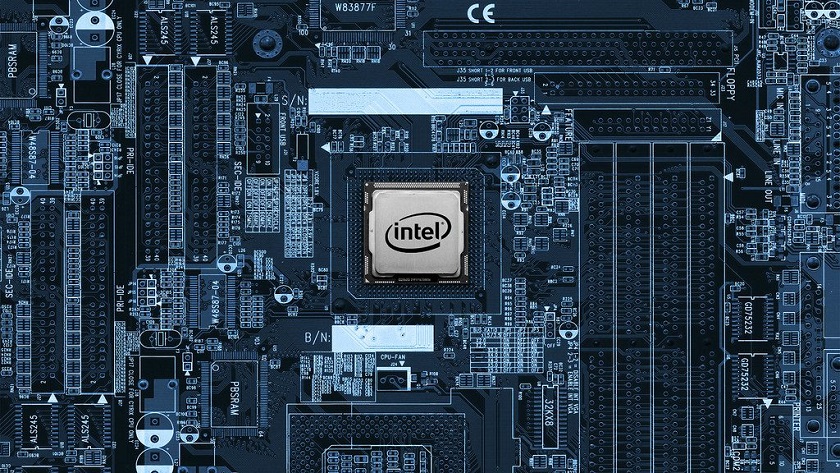

Intel explica por qué las CPUs aún no han superado los 10 GHz

Casi desde los inicios de la informática moderna basada en los transistores gigantes como Intel y AMD se embarcaron en la carrera de los MHz, una competición que nos dejó logros tan importantes como la llegada del primer procesador a 200 MHz y la ruptura de la barrera de los 1.000 MHz (1 GHz), aunque todavía no hemos llegado a superar los 10 GHz.

En efecto, la barrera de los 10 GHz (10.000 MHz) de frecuencia sigue siendo un objetivo que todavía ha sido imposible de cumplir. Ni siquiera los overclockers más capaces del mundo han podido llegar a los 9 GHz utilizando nitrógeno líquido, y francamente no creemos que vayamos a poder superar ese «muro» en CPUs de consumo general con métodos de refrigeración tradicionales.

¿Pero por qué es un «imposible? Victoria Zhislina ha dado una interesante respuesta en la «Intel Developer Zone», donde ha comentado:

«Existe una opinión entre los expertos de que el aumento de la frecuencia de trabajo dará como resultado emisiones de calor muy elevadas. Otros piensan que se podría usar un interruptor que aumente la frecuencia en función del nivel deseado. Pero también existe una gran preocupación de que el aumento de la frecuencia elevare la temperatura de la CPU tanto que acabe provocando una fusión física real. En cualquier caso debemos tener en cuenta que muchos fabricantes de CPU no permiten que se produzca una fusión, ya que suis procesadores tienen monitores de temperatura internos que apagarán la CPU antes de que ocurra.

Esta opinión es expresada por los usuarios de computadoras y además ha sido probada por overclockers, ya que para doblar la frecuencia de trabajo de procesadores actuales necesitan conectar un sistema de enfriamiento tan potente como sea posible».

En resumen, que no hemos llegado a los 10 GHz porque no es una manera eficiente y realista de mejorar el rendimiento de un procesador, especialmente por las enormes temperaturas de trabajo que alcanzaría un chip a esa velocidad y que no podríamos disipar con métodos convencionales.

Más información: DvHardware.

-

GuíasHace 1 día

GuíasHace 1 díaDisplayPort o HDMI, ¿Qué interfaz conviene usar en cada tarea informática?

-

NoticiasHace 10 horas

NoticiasHace 10 horasComprar una SSD será cada vez más caro

-

AnálisisHace 6 días

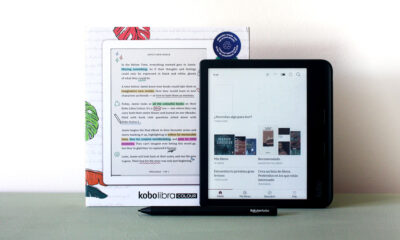

AnálisisHace 6 díasKobo Libra Colour, análisis: bienvenido al mundo del color

-

AnálisisHace 9 horas

AnálisisHace 9 horasRobot aspirador Eureka J12 Ultra, análisis: rapidez a gran escala