A Fondo

AMD augura el final de la carrera de los MHz

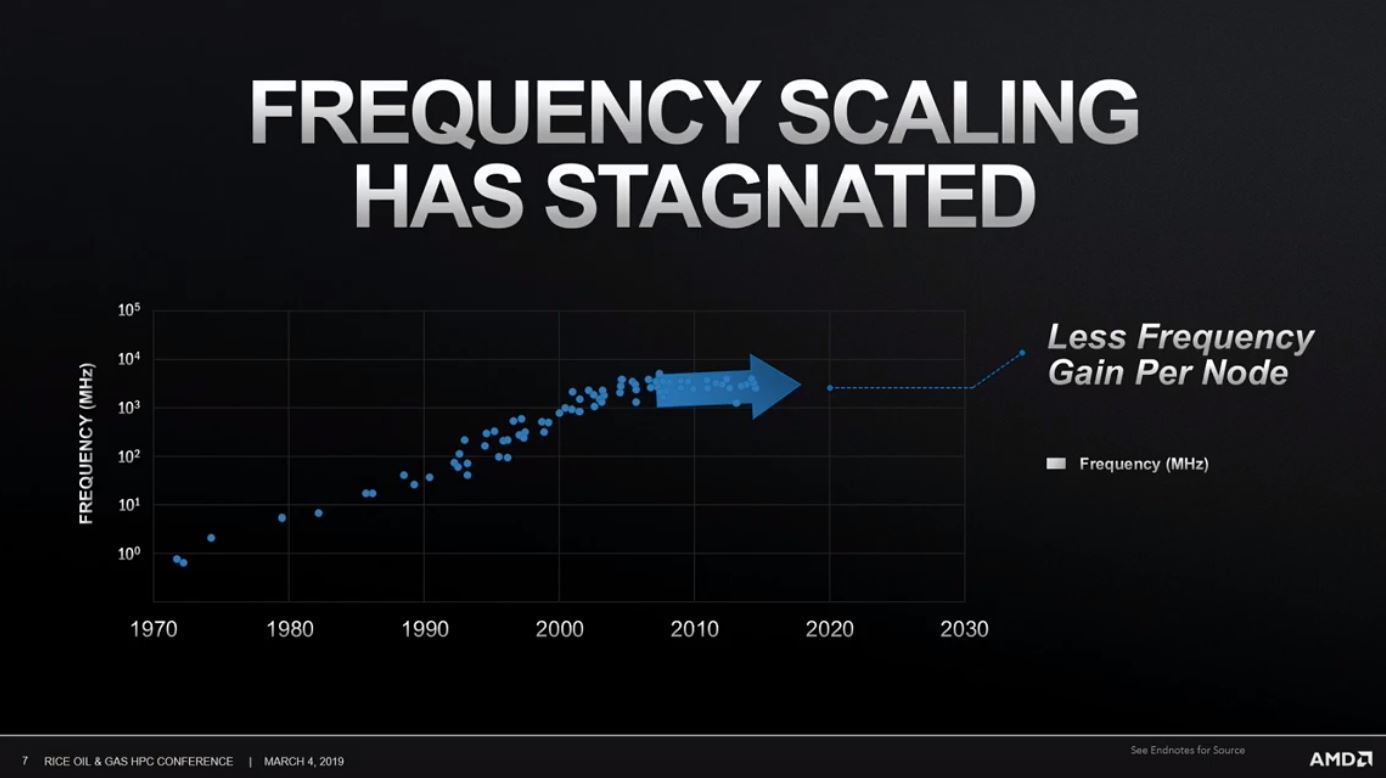

Los procesadores han pasado por diferentes etapas en las que los grandes del sector han priorizado diferentes aspectos, como la frecuencia de trabajo o el conteo de núcleos. Como recordarán muchos de nuestros lectores hasta la llegada de las CPUs de doble núcleo la prioridad absoluta de gigantes como Intel y AMD pasaba por ganar la carrera de los MHz.

Ese fue el curioso nombre con el que se conoció a una etapa bastante larga en la que los procesadores de nueva generación no se limitaban a introducir nuestras instrucciones, nuevas arquitecturas y nuevos procesos de fabricación, sino que además traían unos aumentos de frecuencia de trabajo muy grandes.

Para entenderlo mejor basta con echar un vistazo a las frecuencias de trabajo que alcanzaron los procesadores Intel Pentium II, una generación que llegó a los 450 MHz de frecuencia, y la que lograron los Pentium III: hasta 1,5 GHz. Un salto importante, y lo mismo ocurrió con el Pentium 4, que si no recuerdo mal llegó a los 3,8 GHz.

La diferencia entre esas generaciones de procesadores a nivel de frecuencia de trabajo es abismal, pero estuvo marcada por varios puntos de inflexión, como la llegada de los Athlon 64 de AMD, que ofrecían un rendimiento muy alto sin tener velocidades de trabajo tan elevadas como los Pentium 4, y también con el debut de los procesadores multinúcleo, que hicieron retroceder de forma significativa las frecuencias máximas de los procesadores de alto rendimiento.

Por ejemplo, el Core 2 Duo E6600 fue uno de los procesadores estrella de 2006 para equipos gaming de alto rendimiento, y eso que su frecuencia de reloj apenas llegaba a los 2,4 GHz. Con el paso del tiempo los núcleos han ido aumentando, y también lo han hecho las frecuencias de reloj de los procesadores, una situación que podemos definir como una normalización de dos realidades que chocaron en una primera etapa: el incremento de núcleos y de MHz.

La reducciones de proceso obligarán a reducir la frecuencia de trabajo

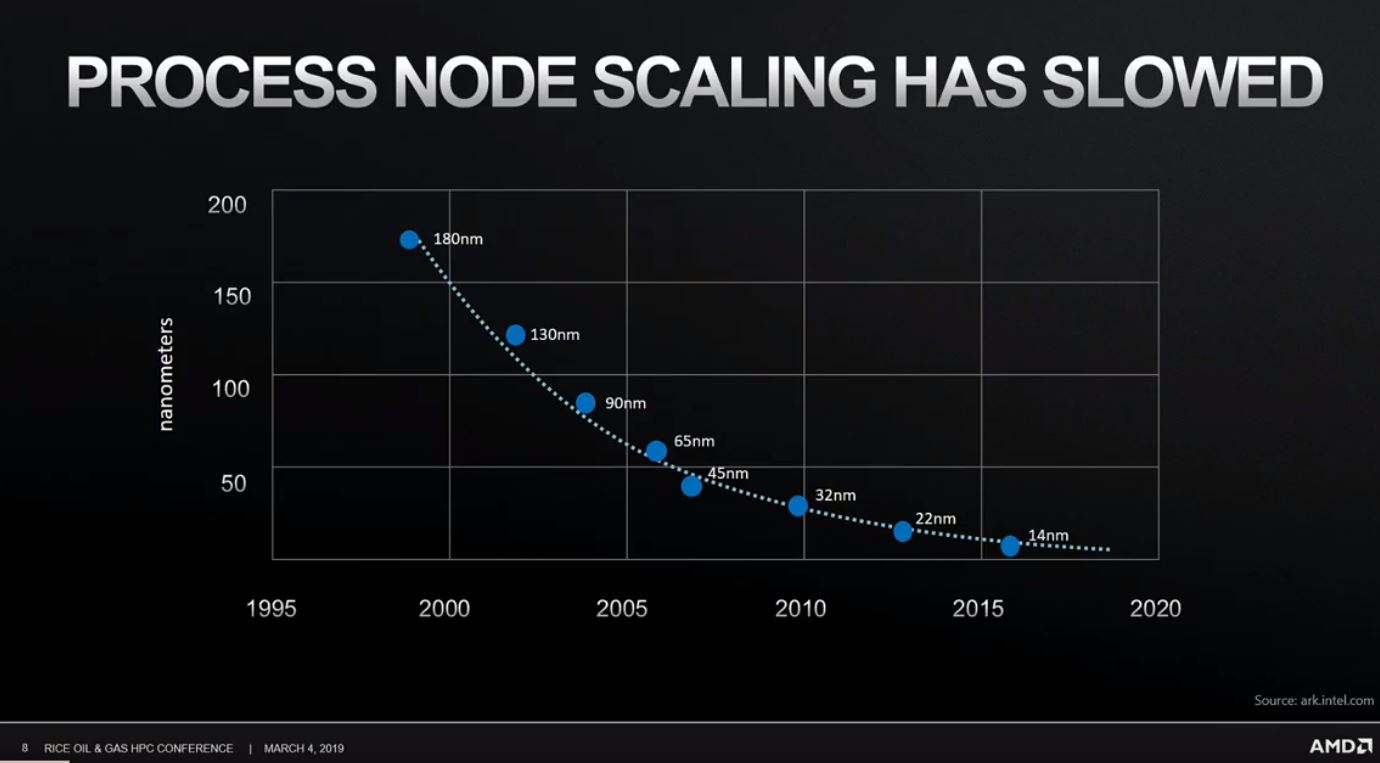

Es un hecho que la frecuencia de trabajo de los procesadores se ha estancado durante la última década. Tras esa etapa de recuperación en la que núcleos y MHz fueron creciendo de forma conjunta nos encontramos en una situación clara: tenemos procesadores con más núcleos que no funcionan a mayor frecuencia de trabajo.

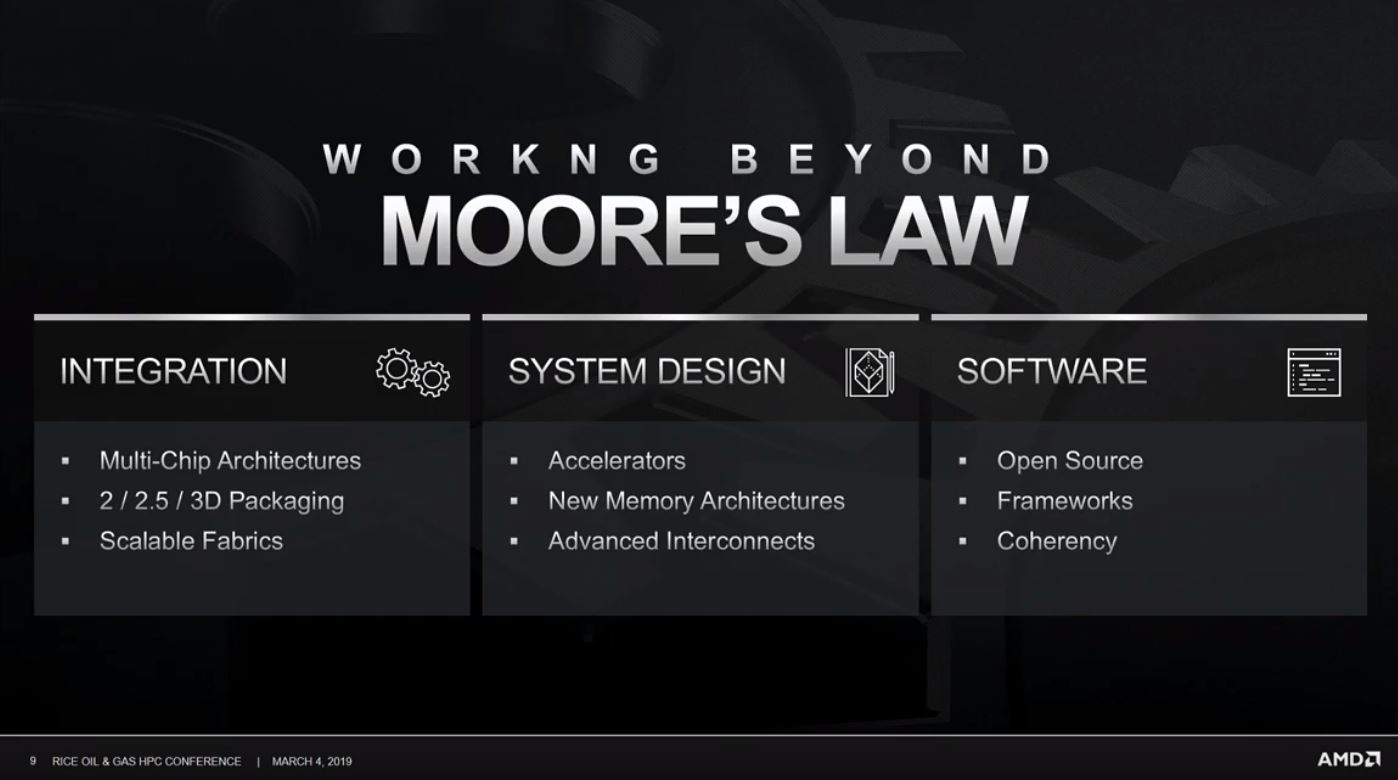

AMD ha participado en la conferencia Rice Oil and Gas HPC, donde ha traído su iniciativa «Working Beyond Moore’s Law», y en ella han dejado una serie de claves muy interesantes que nos permiten entender el futuro a corto y largo plazo de los procesadores. Una de las novedades más importantes la tenemos precisamente en lo que ya hemos expuesto, que los futuros saltos a procesos de fabricación más pequeños (reducciones de nanómetros) no solo harán que ya no podamos confiar en aumentar las frecuencias de trabajo para mejorar el rendimiento, sino que además podría producirse un retroceso, es decir, que acabaríamos viendo procesadores a menor frecuencia.

Forrest Norrod, vicepresidente senior de AMD, se ha encargado de llevar a cabo la exposición que ha ilustrado dicha iniciativa, aunque no ha asociado esa reducción de frecuencia a ningún proceso de fabricación concreto. Se espera que Zen 2, una arquitectura que dará el salto a los 7 nm, mejore las frecuencias de trabajo que hemos visto en los procesadores Ryzen 2000, así que es probable que el ejecutivo se esté refiriendo a los próximos saltos generacionales (5 nm e inferiores).

Las ventajas que ofrecen las reducciones de proceso en términos de densidad de transistores también son, según AMD, cada vez menores. Esto se debe no solo a las propias limitaciones del silicio, sino también a las barreras que impone el encapsulado. Ni siquiera Zen 2, con su diseño MCM (módulo multi-chip), se libra de este problema.

Apilado de DRAM y SRAM en 3D: memoria integrada en la CPU

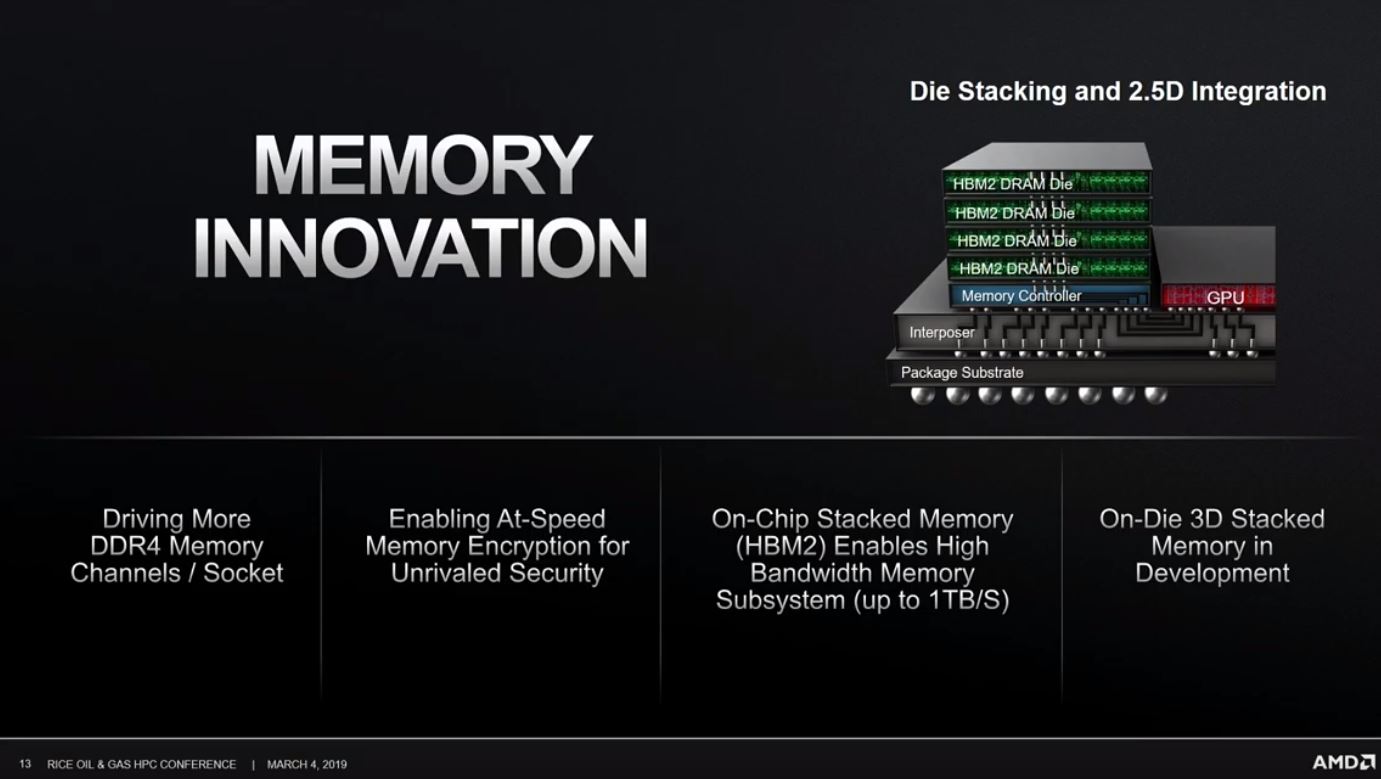

Otro tema interesante que ha tocado Norrod ha sido la idea de apilar componentes en 3D para mejorar el rendimiento de sus procesadores. Apilar semiconductores en 3D no es algo nuevo, la memoria NAND Flash 3D lleva un tiempo utilizando esta idea con excelentes resultados, y lo mismo ocurre con la memoria HBM y HBM2.

Sin embargo, cuando hablamos de procesadores tenemos un panorama mucho más complejo, sobre todo por las limitaciones que encontramos a nivel de alimentación y de temperaturas de trabajo, pero resulta prometedor, desde luego. La idea que ha expuesto el vicepresidente senior de AMD plantea la integración de memoria DRAM y SRAM en la parte superior de la CPU, es decir, en un encapsulado que iría justo encima del la pastilla de silicio que representa el corazón del procesador, y con la que se comunicaría de forma directa a través de conectores verticales «TSV» («a través del silicio»).

Esta diferenciación en el sistema de conexión de ambos encapsulados es muy importante, ya que los conectores TSV permiten conseguir una alta velocidad y una gran rendimiento. Dicho de otra forma, son la mejor opción en términos de potencia bruta y reduce, además, el consumo y las temperaturas. No profundizó en la aplicación de este sistema de apilado en soluciones concretas, así que de momento solo podemos esperar.

Por último el ejecutivo también hizo referencia a la importancia de la interconectividad de componentes en los diseños MCM (módulo multi-chip), utilizado en los procesadores Zen, Zen+ y Zen 2, y comentó que siguen trabajando para introducir mejoras que permitan aumentar el rendimiento, entre las que destacó el soporte de CCIX y Gen-Z.

-

GuíasHace 18 horas

GuíasHace 18 horasDisplayPort o HDMI, ¿Qué interfaz conviene usar en cada tarea informática?

-

GuíasHace 7 días

GuíasHace 7 díasCómo personalizar Windows con aplicaciones externas

-

AnálisisHace 6 días

AnálisisHace 6 díasKobo Libra Colour, análisis: bienvenido al mundo del color

-

PrácticosHace 6 días

PrácticosHace 6 díasCómo crear un ‘Windows para llevar’ con Windows To Go