Noticias

La Radeon RX 6900 XT tendrá un consumo de hasta 355 vatios, por encima de la RTX 3080

AMD presentará su arquitectura RDNA 2 el próximo 28 de octubre, y la Radeon RX 6900 XT, basada en el núcleo Navi 21 XT será el modelo tope de gama, es decir, el buque insignia de la compañía de Sunnyvale.

Todavía no se han confirmado sus especificaciones, pero gracias a las filtraciones que se han ido produciendo durante los últimos meses pudimos dar forma a un artículo especial donde os desgranamos las cinco claves más importantes de la arquitectura RDNA 2.

Por lo que respecta a la potencia bruta, AMD aprovechó el evento de presentación de Zen 3 para dejarnos un vistazo previo del rendimiento que ofrecerá la Radeon RX 6900 XT en tres juegos: Gears 5, Borderlands 3 y Call of Duty Modern Warfare 2019. Esos resultados confirmaban lo que habíamos dicho en ocasiones anteriores, que no será más potente que la RTX 3080.

La Radeon RX 6900 XT podría repetir los errores del pasado

Poniendo en contexto toda la información que he ido viendo durante las últimas semanas tengo claro que la cosa no pinta del todo bien para la arquitectura RDNA 2. Ojalá me equivoque, pero lo veo poco probable, ya que todo apunta a que las Radeon RX 6000 no van a poder competir ni en potencia bruta ni en eficiencia.

En rasterizado, la Radeon RX 6900 XT debería ofrecer un rendimiento situado a medio camino entre la RTX 3070 y la RTX 3080. Estará más cerca de esta, pero según los últimos datos que ha compartido el siempre fiable Igor´s Lab, la versión de referencia tendrá un TBP (consumo total) de 320 vatios, cifra que subirá hasta los 355 vatios en los modelos personalizados. La RTX 3080 registró en nuestro análisis un consumo medio de 312 vatios, con un pico de 336 vatios.

La conclusión es clara, tenemos un valor de rendimiento por vatio consumido inferior en la Radeon RX 6900 XT, siempre que las informaciones que venimos viendo se confirmen de forma íntegra. Por su parte, la Radeon RX 6800 XT, que estaría basada en el núcleo Navi 21 XL, tendrá un TBP de 290 vatios, una cifra que queda muy por encima de los 220 vatios que registra la RTX 3070. En términos de rendimiento, la alternativa de AMD debería quedar, más o menos, al nivel de la solución de NVIDIA, lo que de nuevo nos dejaría una relación rendimiento por vatio consumido muy pobre.

RDNA 2 y trazado de rayos: ¿qué podemos esperar?

Es cierto que AMD todavía no ha dado detalles sobre la tecnología que utilizará en las Radeon RX 6000 para acelerar trazado de rayos por hardware, pero gracias a Microsoft, que explicó todas las claves del SoC de Xbox Series X, tenemos una idea bastante clara.

Dicho SoC utiliza una GPU RDNA 2, lo que significa que la tecnología para acelerar trazado de rayos que trae este chip es la misma que veremos en las Radeon RX 6000. Como recordarán nuestros lectores habituales, la GPU Radeon RDNA 2 de Xbox Series X utiliza núcleos dedicados a trazado de rayos integrados en las unidades de texturizado, lo que da forma a una estructura de recursos compartidos en la que ambos no pueden trabajar al mismo tiempo.

Habrá que ver hasta qué punto afecta esto al rendimiento. Ya os dije en su momento, tras ver la demo de Minecraft RTX corriendo sobre Xbox Series X, que me temía lo peor, y como podéis ver no iba desencaminado. De nuevo, espero equivocarme, ya que la competencia es buena para todos, y necesitamos a una AMD fuerte que pueda debilitar el liderato de NVIDIA.

Creo que AMD va a apostar por ofrecer el mejor valor precio-prestaciones, al menos en términos de coste por fotograma, pero va a quedar por detrás de NVIDIA en potencia bruta, en eficiencia y en rendimiento en trazado de rayos.

-

A FondoHace 5 días

A FondoHace 5 díasDoble SIM: Cómo funciona y por qué es tan útil en algunos campos de uso

-

GuíasHace 4 días

GuíasHace 4 díasCómo personalizar Windows con aplicaciones externas

-

AnálisisHace 3 días

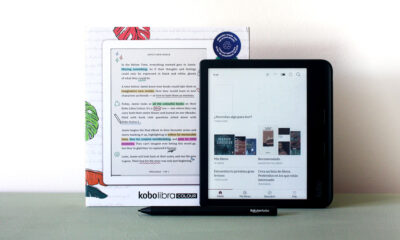

AnálisisHace 3 díasKobo Libra Colour, análisis: bienvenido al mundo del color

-

A FondoHace 1 día

A FondoHace 1 díaÚltimas ofertas de los Días Naranjas en PcComponentes ¿Te falta el regalo para la mamá tecnológica?