A Fondo

NVIDIA G-Sync, la «historia» de una derrota justa

Hace tiempo que la competencia entre G-Sync y FreeSync (y por ende Adaptive Sync) no centra los focos de los medios. Viendo que la situación se ha enfriado, vamos a aprovechar la ocasión para recopilar un poco de lo que pasó entonces.

Tanto G-Sync como Adaptive Sync, que es el estándar de VESA implementado por FreeSync, son tecnologías de sincronización adaptativa o de tasa de refresco variable (VRR) incorporadas a nivel del monitor orientadas a eliminar problemas como el stuttering y el tearing, los cuales terminan siendo muy molestos principalmente a la hora de jugar a videojuegos.

Stuttering es una palabra inglés cuya traducción al castellano es tartamudeo. La razón de por qué se produce es debido a que los fotogramas generados por el ordenador y los proyectados por el monitor no van en sincronía. Siendo más concretos, ocurre cuando el monitor se “adelanta” a la gráfica a la hora de pedir el próximo fotograma, pero este todavía no ha sido generado, provocando que el monitor proyecte dos veces el mismo fotograma. Como consecuencia, el usuario puede encontrarse con esos tirones que llegan a arruinar una partida si se producen en el momento más inoportuno.

Por su parte, el tearing es un artefacto visual que se provoca por la falta de sincronía entre los fotogramas generados por el ordenador y la tasa de refresco con la que trabaja el monitor (Hz), pero no es lo mismo que el stuttering. En el caso del tearing, la causa es casi la inversa, con la gráfica generando el próximo fotograma mientras que el actual sigue proyectado en el monitor, lo que provoca en consecuencia los conocidos cortes horizontales que a nivel de software ha sido corregidos (y se siguen corrigiendo en muchos casos) con la sincronización vertical y triple buffering.

Tras exponer los dos principales problemas que se pretenden solucionar, es evidente que el objetivo de G-Sync y Adaptive Sync es la de corregir los problemas de sincronización presentados por los desfases entre los fotogramas generados por la GPU y la CPU y los proyectados por el monitor. Sin más dilación, vamos a exponer qué es cada una de las tecnologías de sincronización abarcando FreeSync, que fue la respuesta de AMD a la propuesta del gigante verde.

¿Qué es el G-Sync original?

G-Sync es la tecnología de sincronización adaptativa de NVIDIA, que fue la primera (o al menos fue la primera entre las tres grandes marcas de GPU) en ver la luz dentro de su segmento.

G-Sync generó bastante expectación en su momento, más viendo que soluciones como la sincronización vertical provocan input lag, pero como suele ser habitual por parte de NVIDIA, llegó con una serie de inconvenientes que despertaron las críticas de los defensores de los estándares, el código abierto y el software libre.

La tecnología de NVIDIA aportaba soluciones o al menos avanzaba enormemente en la corrección de lo que se había planteado, pero desgraciadamente G-Sync nació como una tecnología privativa, una situación que dificultaba su portabilidad a otras plataformas (tanto a nivel de sistemas operativos como de gráficas) y encima conllevaba el pago de royalties por parte de los fabricantes de monitores que decidían implementarla.

Dicho con otras palabras, los consumidores finales que quisieran hacer uso de G-Sync estaban obligados a tener una gráfica de NVIDIA y encima tenían que pagar un “extra” por el monitor que hace uso de la tecnología, una clara estrategia de vendor lock hecha a propósito para retener a los clientes y exprimirlos con el conocido logo de “the way it’s meant to be played” (la manera en que debe ser jugado).

En cuanto a plataformas soportadas y a pesar de ser una tecnología privativa, hay que reconocer que NVIDIA se portó correctamente, porque aparte de exigir una gráfica de su marca, G-Sync no solo funcionaba en Windows y Linux, sino también en sistemas menos masificados como FreeBSD y Solaris.

FreeSync, la respuesta de AMD a través de los estándares

La respuesta de AMD llegó en 2014, más concretamente en el CES 2014. La división Radeon del gigante rojo presentó en aquel evento FreeSync, una iniciativa publicada como una especificación abierta y libre de royalties, además de ser una implementación del Adaptive Sync de VESA.

Los detractores de FreeSync le criticaron en su momento que fuera una tecnología presuntamente inferior a G-Sync, una situación que, trasladándonos a la actualidad, recuerda un poco a lo que pasa entre DLSS y FidelityFX Super Resolution. Sin embargo, AMD supo jugar mejor sus cartas en aquella ocasión, porque las diferencias no eran en apariencia exageradas y FreeSync tenía la ventaja de ser abierto, más fácil de implementar y de estar libre royalties, tres factores que se tradujeron en monitores más baratos.

NVIDIA movió ficha para mantener a G-Sync en el candelabro, pero la realidad es que tanto los fabricantes de monitores como los usuarios se volcaron con FreeSync, así que a nivel comercial le terminó yendo mejor a este último. Por otro lado, FreeSync ha sido implementado también en HDMI, mientras que G-Sync parece estar limitado, al menos en su forma original, a DisplayPort.

El triunfo de FreeSync sobre G-Sync fue muy importante para los usuarios, ya que supuso que las tecnologías de sincronización adaptativas implementadas en los monitores girarían en torno a los estándares y no estarían dominadas por una corporación como NVIDIA, que tiene una fuerte tendencia a dejar sus tecnologías cerradas y muchas veces saltándose y interpretando a su manera los estándares, cosa que le ha costado duras críticas por parte de las comunidades del software libre y el Open Soruce y ser blanco de la ira de Linus Torvalds, creador del kernel Linux.

Intel dio la puntilla a G-Sync al anunciar que soportaría Adaptive Sync

A pesar de que FreeSync estaba ganando la batalla comercial, la rivalidad con el enfoque cerrado de G-Sync duró varios años, algo lógico si tenemos en cuenta que NVIDIA no iba a dejar caer su tecnología por las buenas.

Posiblemente el gigante verde sintiera cierto escozor en septiembre de 2018, cuando Intel anunció que soportaría Adaptive Sync. Dicho con otras palabras, se alinearía con la perspectiva adoptada por AMD y no competería en el mercado de las tecnologías de tasa de refresco variable con una solución privativa y alejada de los estándares.

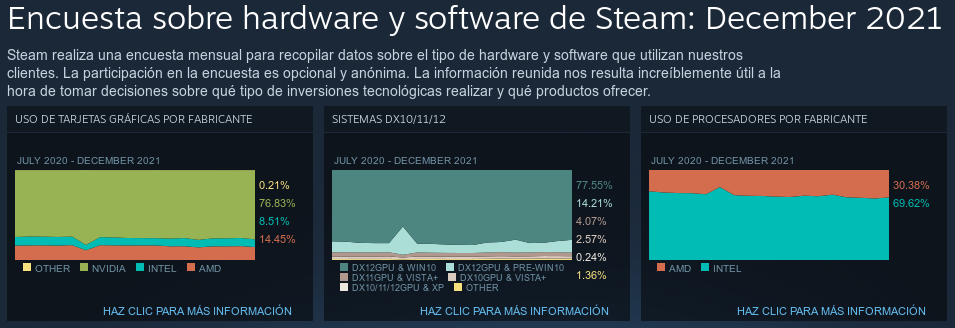

La decisión de Intel puso en su momento en aprietos a NVIDIA, ya que, a pesar de que la segunda tiende arrasar en la encuesta de Steam hace años, es la primera la que realmente domina en cuota de mercado al acaparar la mayor parte de ese grueso de equipos orientados a usos básicos y profesionales que no requieren de una gráfica dedicada.

Cierto es que Radeon va a rebufo de NVIDIA desde hace años, pero con Intel la situación es diferente al tener esta la mayoría de los usuarios, a pesar de contar por entonces (y por ahora mientras no se comercialicen sus gráficas dedicadas) con peor tecnología.

“Compatibilidad G-Sync” y la claudicación de NVIDIA

Con Intel y AMD haciendo una alianza tácita en torno a Adaptive Sync y con FreeSync teniendo más éxito comercial que G-Sync, NVIDIA empezó a mostrar debilidad durante el transcurso de 2019.

El gigante verde anunció en un primer momento que añadiría compatibilidad de G-Sync para un nuevo grupo de monitores que de origen no estaban preparados para usar su tecnología de VRR (o sea, que no contaban con el hardware dedicado que se suponía necesario). Aquello fue anunciado en el CES de 2019 y bautizado como “compatibilidad G-Sync”. Para su puesta en funcionamiento solo requería de una actualización de software para las series GTX 10, GTX 16 y RTX 20 y un monitor compatible, el cual puede hacer uso las funciones básicas de tasa de refresco variables ofrecidas por G-Sync.

El ofrecer soporte G-Sync a través de software era el primer paso para algo que se empezaba a atisbar: la adopción de Adaptive Sync por parte de NVIDIA. Por suerte aquello sucedió solo unos meses después, en noviembre de 2019, cuando el mayor gigante del procesamiento de gráficos anunció que soportaría Adaptive Sync en los futuros monitores que incluyan el módulo privativo de G-Sync, permitiendo que éstos funcionen también con tarjetas gráficas de AMD e Intel.

¿Qué diferencias hay entre el G-Sync original y “compatibilidad G-Sync”?

Las diferencias ya las hemos expuesto a lo largo de este artículo, pero por si no ha quedado claro, vamos a mostrarlas de manera más explícita en un apartado propio.

El G-Sync original requería de un hardware dedicado que, desgraciadamente, encarecía los monitores. Toda pantalla que no integre el hardware correspondiente será incapaz de hacer uso de la versión primigenia de la tecnología de tasa de refresco variable de NVIDIA.

La “compatibilidad G-Sync” significa que NVIDIA ha probado y homologado el uso de su tecnología en monitores que no incorporan el hardware dedicado. En este contexto todo se hace mediante software e implementando la especificación Adaptive Sync, abriendo así la puerta a poder usar G-Sync en pantallas más baratas.

Si NVIDIA hubiera impulsado el hardware dedicado para G-Sync a través de alguna especificación abierta y más barata, igual la historia hubiera sido distinta, pero viendo lo bien que le va al gigante verde con sus políticas tendentes a ofrecer productos cerrados y con un alma totalmente privativa, es de entender que decidiera optar por el camino que escogió, y a buen seguro que recorrerá los mismos derroteros si en el futuro se presenta una situación similar.

¿Cuál es la diferencia entre Adaptive Sync y FreeSync?

Mucha gente tiende a confundir Adaptive Sync y FreeSync, sobre todo porque AMD publicó FreeSync como una especificación abierta que puede ser implementada por cualquiera. Sin embargo, la realidad es que FreeSync es en esencia una implementación de Adaptive Sync.

Adaptive Sync es una especificación de VESA que fue añadida a DisplayPort 1.2a después de llegar a la versión empotrada de la misma interfaz de salida de vídeo, la cual también es responsabilidad de VESA. Al ser abierta y estándar, puede ser implementada por cualquiera de forma libre y sin tener que pagar royalties, al igual que pasa con los puertos USB, por ejemplo.

Adaptive Sync, como especificación para la tasa de refresco variable que es, se encarga de sincronizar la tasa de refresco del monitor, que se mide en hercios, con los fotogramas por segundo generados por el ordenador. La tasa refresco, que es la cantidad de imágenes proyectadas por el monitor en un segundo, es fija, mientras que la cantidad de fotogramas generados por el ordenador (conocida por las iniciales en inglés ‘fps’) no tiene por qué, sobre todo cuando hablamos de videojuegos.

Adaptive Sync (y también G-Sync en sus dos formas) lo que hace es ajustar la tasa de refresco del monitor dinámicamente para que coincida con la cantidad de fotogramas por segundo generada por la computadora. De esta manera se previene la aparición de fallos y artefactos gráficos como el tearing y el stuttering. Gracias a que permite reducir dinámicamente la tasa de refresco de la pantalla, abre la puerta a ahorrar energía en los portátiles y prolongar su autonomía.

Por su parte, el FreeSync de AMD es, básicamente, el primer gran valedor de Adaptive Sync (al menos en el ecosistema x86), que años después terminó siendo soportada primero por Intel y luego por NVIDIA si nos centramos en los tres grandes fabricantes de hardware que acaparan el ecosistema x86 (sabemos que NVIDIA no fabrica procesadores). Es importante tener en cuenta que su funcionamiento, al menos como FreeSync, está limitada a las gráficas Radeon, así que cada fabricante es responsable de su propia implementación de Adaptive Sync.

Conclusión: Adaptive Sync venció, los consumidores vencieron

Si bien el G-Sync original fue en términos objetivos una buena tecnología, el hecho de fuera privativa y cara hacía que la tasa de refresco variable terminase siendo una característica solo al alcance de los más pudientes.

NVIDIA intentó aprovecharse de su claro dominio en el sector de las gráficas dedicadas para intentar ganar aún más dinero, pero afortunadamente los consumidores y los fabricantes decidieron darle la espalda para volcarse con FreeSync. Después de algunos años de competencia, Adaptive Sync se ha consolidado como el estándar tanto de iure como de facto, por lo que la tasa de refresco variable ya no es una característica orientada a los gamers más pudientes.

-

PrácticosHace 4 días

PrácticosHace 4 díasAsí se usa RegScanner para gestionar el registro de Windows

-

GuíasHace 1 día

GuíasHace 1 díaBluesky, primeros pasos en la red de microblogging alternativa

-

A FondoHace 7 días

A FondoHace 7 díasApple presenta sus nuevos MacBook Pro y MacBook Air con chips M5

-

A FondoHace 6 días

A FondoHace 6 díasMacBook Neo: el MacBook barato ya es real, ¡y muy prometedor!