A Fondo

RTX 2070, RTX 2080 y RTX 2080 TI: especificaciones y precios

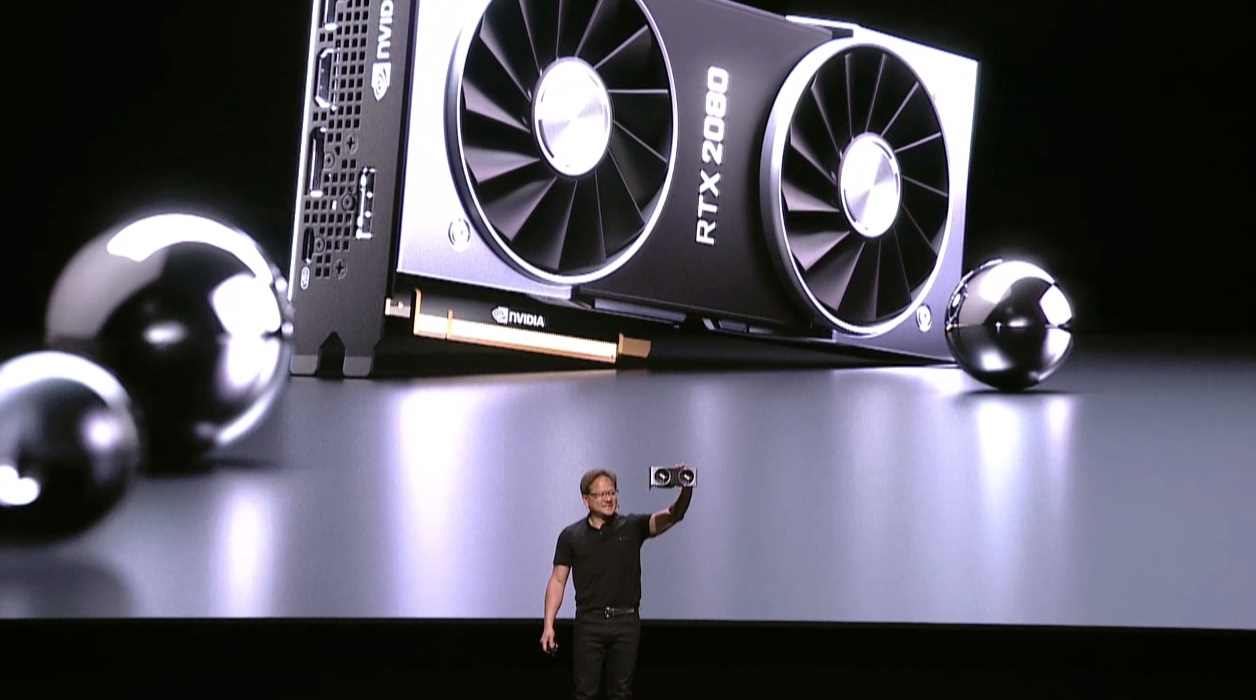

Hoy es el gran día, NVIDIA va a presentar las RTX 2070, RTX 2080 y RTX 2080 TI, dos tarjetas gráficas de nueva generación basadas en la arquitectura Turing que ya hemos tenido ocasión de ver en artículos anteriores.

El anuncio de las Quadro RTX de nueva generación nos permitió hacernos una idea de las posibles especificaciones que tendrían las RTX 2080 y RTX 2080 TI, y poco después se produjo una filtración por parte de PNY y de GALAX que nos ha confirmado por completo todo lo que podemos esperar de esa nueva generación.

Creemos que no habrá sorpresas, pero vamos a seguir el evento en directo para contaros todo lo que debéis saber de lo nuevo de NVIDIA. A continuación os dejamos un resumen con las especificaciones y precios que fueron confirmados por ambas ensambladoras.

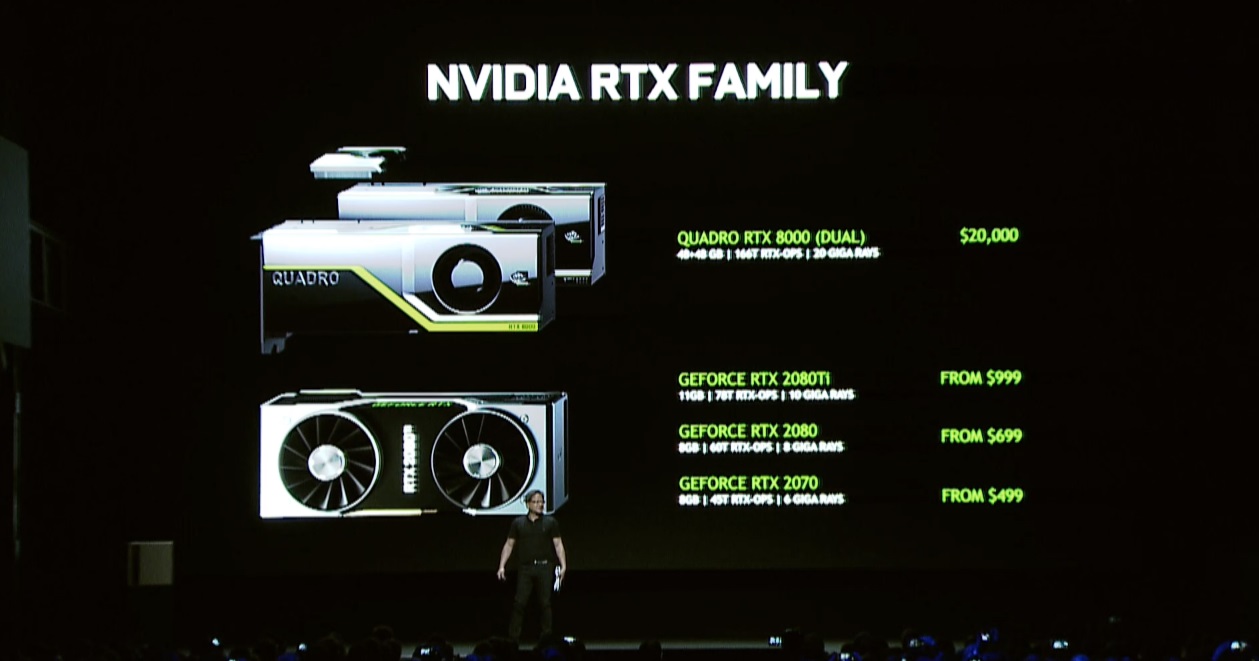

GeForce RTX 2080 Ti

- GPU TU102 (arquitectura Turing) fabricada en proceso de 12 nm.

- 4.352 shaders a 1.350 MHz-1.545 MHz, modo normal y turbo.

- Tecnología NVLINK.

- 272 unidades de texturizado.

- 88 unidades de rasterizado.

- Bus de 352 bits.

- 11 GB de memoria GDDR6 a 14 GHz efectivos.

- TDP de 285 vatios.

- Necesita dos conectores de alimentación de 8 pines.

- Precio: desde 999 dólares. La Founders Edition cuesta 1.259 euros.

GeForce RTX 2080

- GPU TU104 (arquitectura Turing) fabricada en proceso de 12 nm.

- 2.944 shaders a 1.515 MHz-1.710 MHz, modo normal y turbo.

- 184 unidades de texturizado.

- 64 unidades de rasterizado.

- Bus de 256 bits.

- 8 GB de memoria GDDR6 a 14 GHz efectivos.

- TDP de hasta 285 vatios.

- Necesita un conector de alimentación de 8 pines y otro de 6 pines. Hay modelos con dos conectores de 8 pines.

- Precio: desde 699 dólares. La Founders Edition cuesta 849 euros.

GeForce RTX 2070

- GPU TU104 (arquitectura Turing) fabricada en proceso de 12 nm.

- 2.304 shaders a 1.410 MHz-1.710 MHz, modo normal y turbo.

- 144 unidades de texturizado.

- 64 unidades de rasterizado.

- Bus de 256 bits.

- 8 GB de memoria GDDR6 a 14 GHz efectivos.

- TDP de 185 vatios.

- Necesitará como mínimo un conector de alimentación de 8 pines.

- Precio: desde 499 dólares. La Founders Edition cuesta 639 euros.

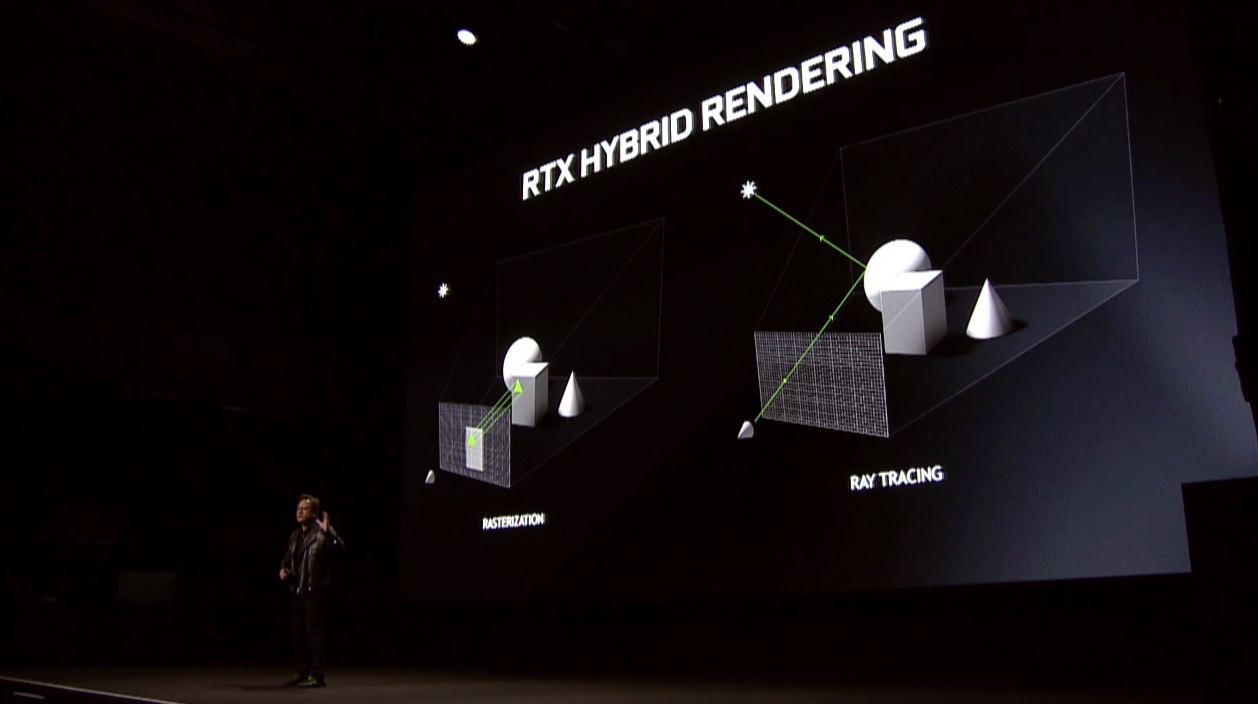

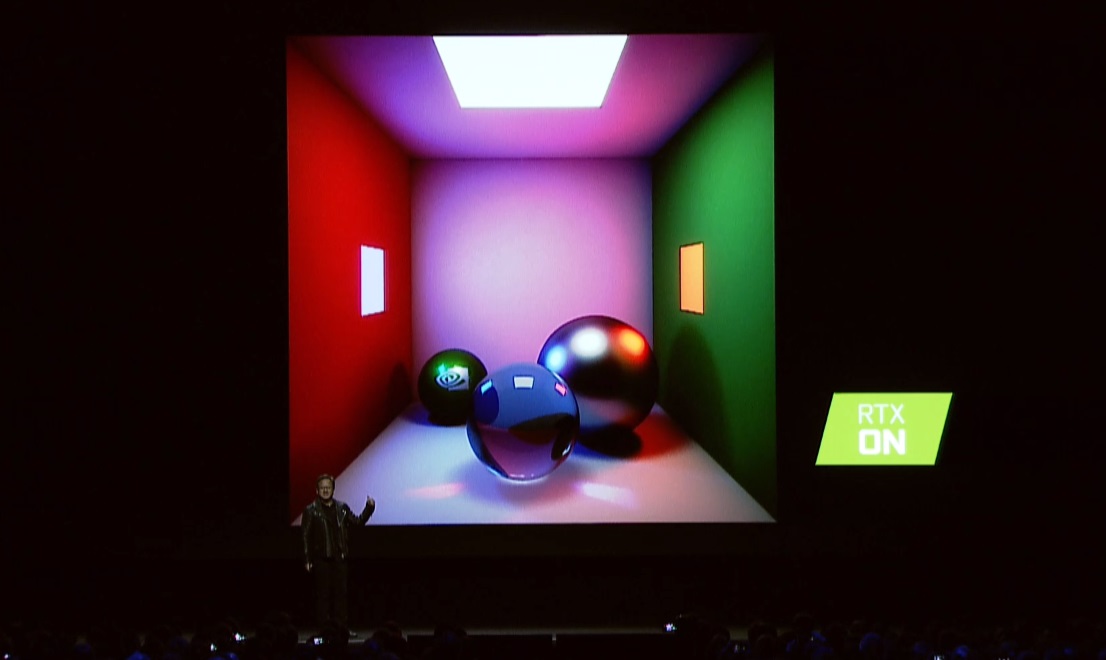

El CEO de NVIDIA, Jen-Hsun Huang, ha confirmado la apuesta de la compañía por el trazado de rayos. NVIDIA RTX ha sido definida como una plataforma completa que incluye tanto software (herramientas de desarrollo) como hardware. Lo más interesante en este sentido ha sido su explicación de las ventajas y las desventajas del trazado de rayos y del rasterizado, dos técnicas de renderizado que se han adoptado de forma conjunta para dar forma a un renderizado híbrido que aprovecha el potencial de cada una de ellas.

En el caso de la rasterización destaca por ser capaz de ofrecer un alto nivel de paralelizado, pero tiene problemas a la hora de generar una gran cantidad de efectos de luces y sombras en tiempo real. Lo que conocemos como iluminación global puede ser un gran problema por el consumo de recursos que implica, una cuestión que se resuelve con el trazado de rayos.

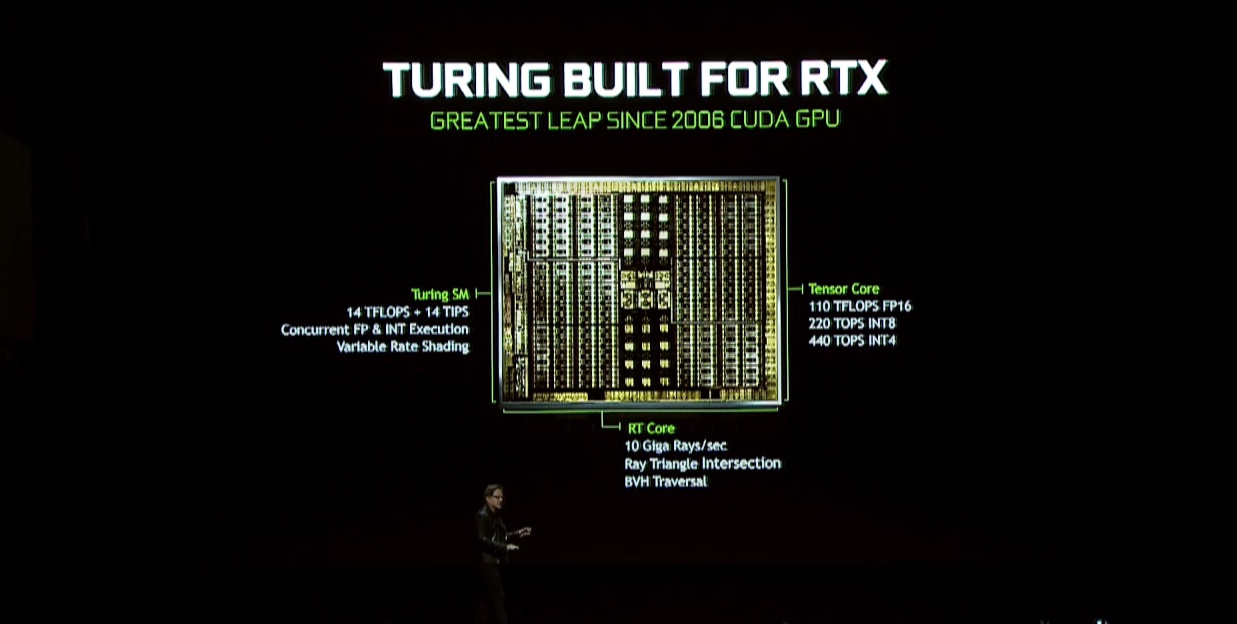

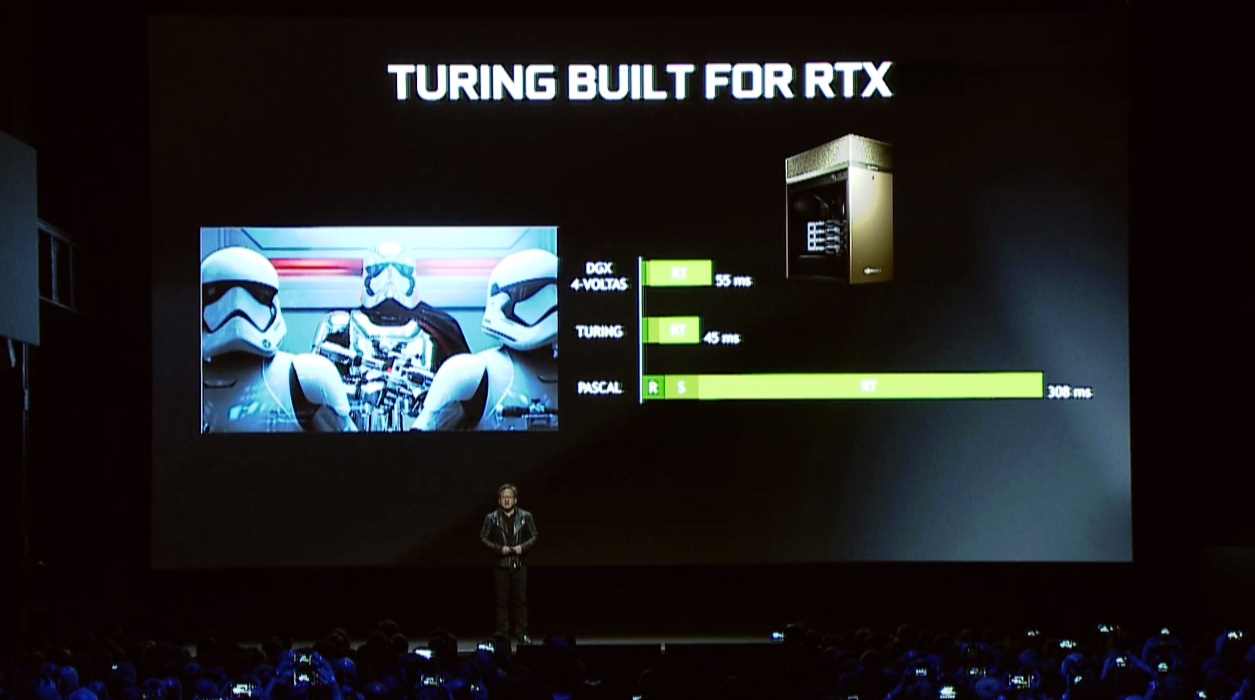

Jen-Hsun Huang ha vuelto a hacer referencia a la demostración de Star Wars bajo el Unreal Engine 4 con trazado de rayos y hasta se ha permitido una pequeña broma antes de hablar por fin de Turing, una arquitectura que introduce un nuevo valor en términos de rendimiento: los GigaRays. Una GTX 1080 TI es capaz de generar 1,21 GigaRays por segundo, cifra que Turing eleva a 10 GigaRays por segundo.

En términos de potencia bruta la comparación es clara: fueron necesarias cuatro tarjetas gráficas Volta para mover la demo de Star Wars con 55 ms entre fotogramas. Con una tarjeta gráfica basada en Turing podemos lograr 45 ms entre fotogramas, y con una GTX 1080 TI tendríamos unos desastrosos 308 ms entre fotogramas. La diferencia es abismal, de eso no hay duda, y todo gracias a la especialización que ofrecen los núcleos RT.

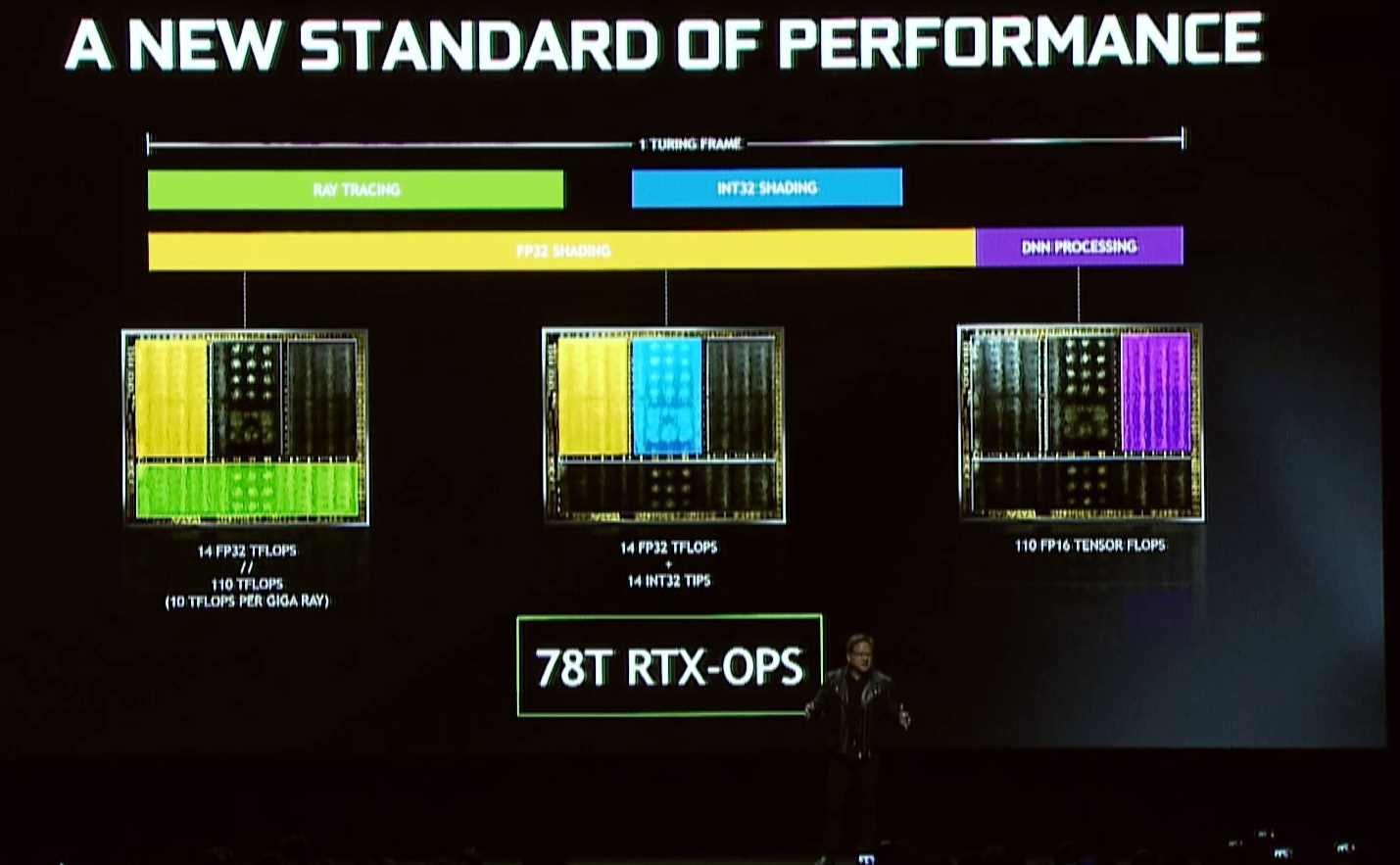

Seguimos con detalles interesantes a nivel de rendimiento y potencia bruta. Turing combina shaders (núcleos CUDA), núcleos ténsor y núcleos RT para ofrecer una potencia bruta de 78 Tera RTX-OPS, cifra que según el CEO de NVIDIA apenas llega a 12 en una GTX TITAN X.

Ya os habíamos anticipado en artículos anteriores que esos tres grupos de núcleos iban a jugar un papel fundamental en esta nueva generación trabajando juntos, y al final nuestras previsiones se han cumplido.

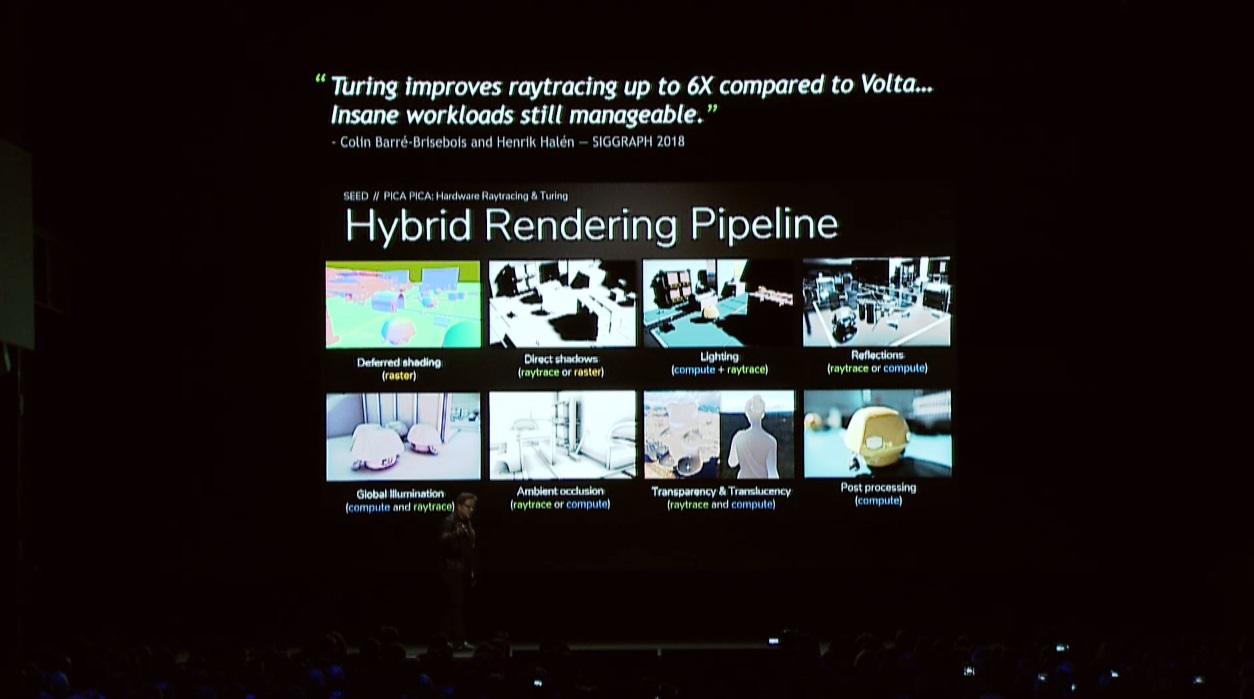

Volvemos a la importancia del trabajo conjunto de los diferentes bloques de núcleos presentes en Turing y al uso del renderizado híbrido que describimos al inicio. Turing es capaz de mejorar por seis el rendimiento de Volta en trazado de rayos.

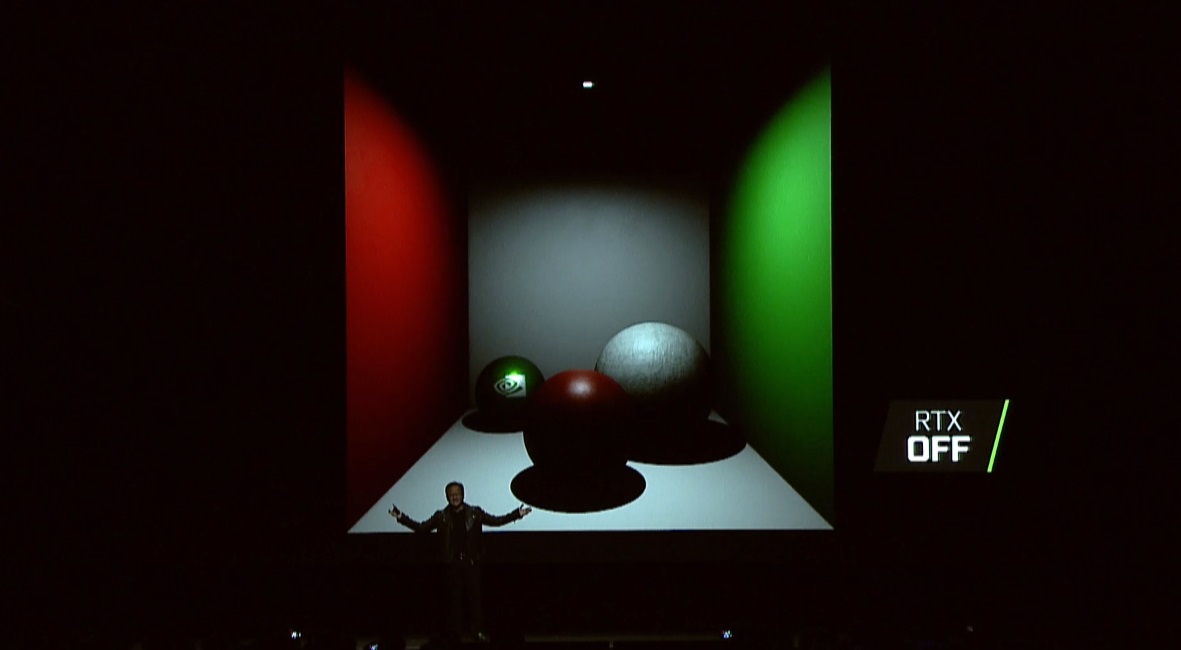

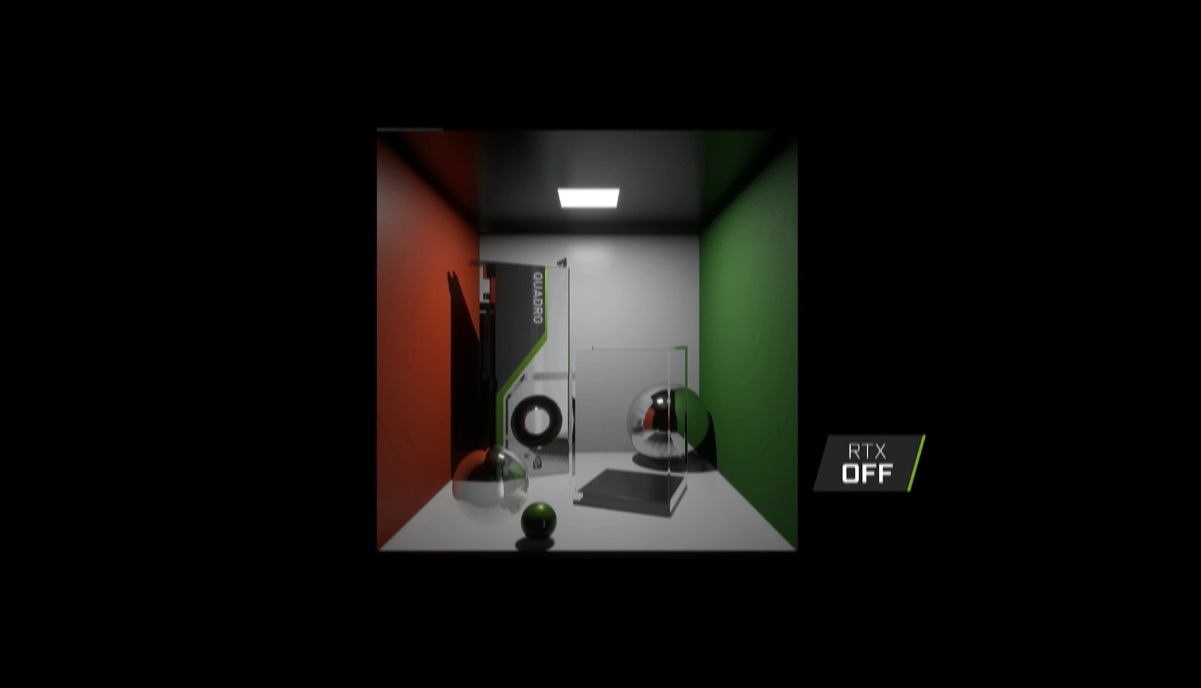

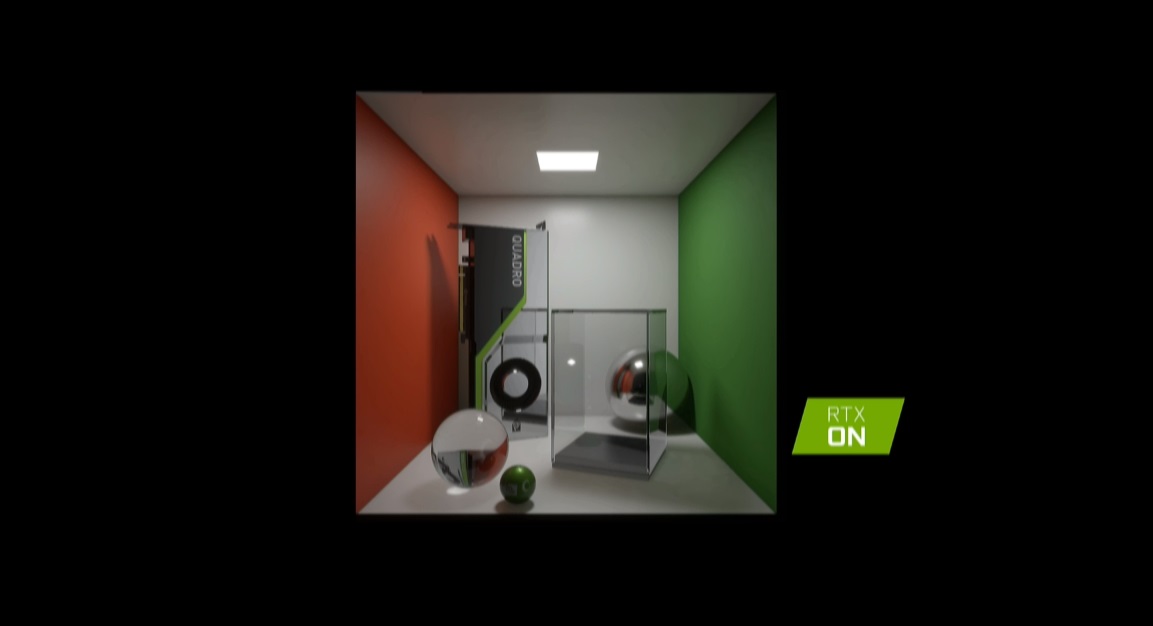

En las dos imágenes inferiores podéis ver el resultado que ofrece una misma imagen con trazado de rayos y sin trazado de rayos. Acompañamos otras dos imágenes comparativas para que tengáis más claras las diferencias que puede marcar el trazado de rayos.

La demo técnica que ha mostrado NVIDIA funcionando sobre una única tarjeta gráfica Quadro RTX 6000 es verdaderamente impresionante, basta ver la calidad de la iluminación y los reflejos en tiempo real para darse cuenta de ello. Os dejamos el vídeo a continuación por si queréis volver a verlo.

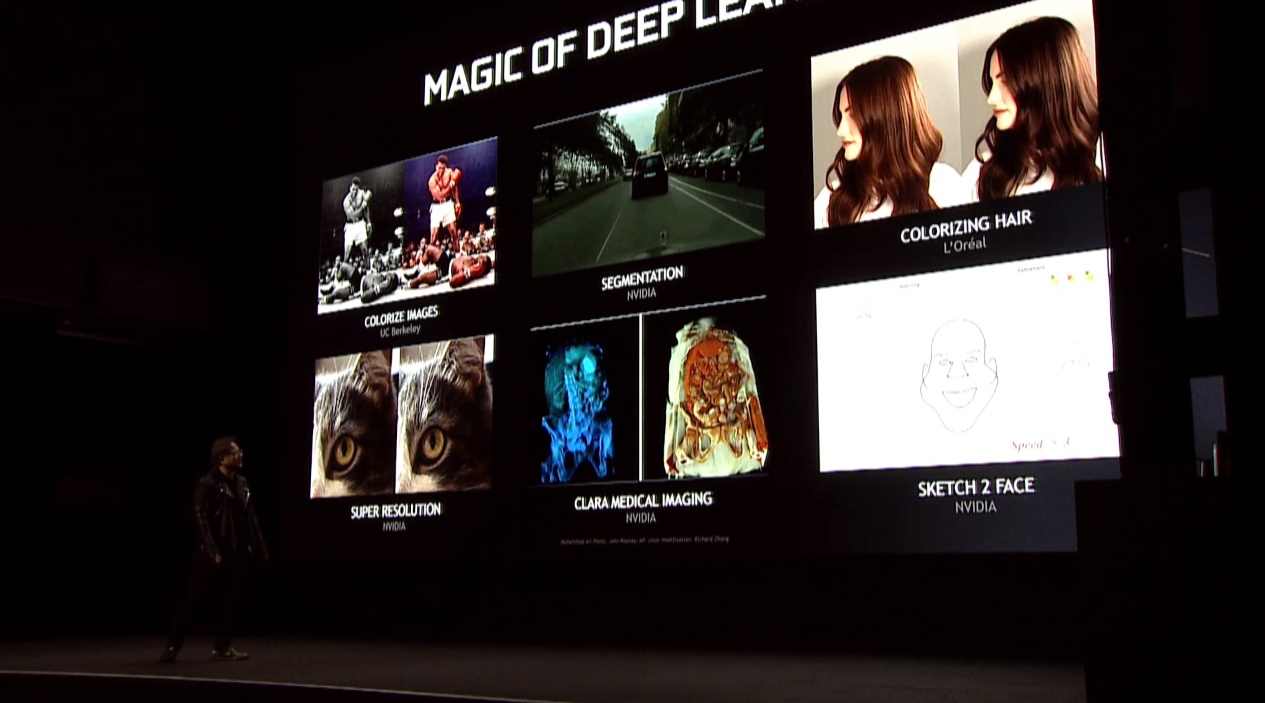

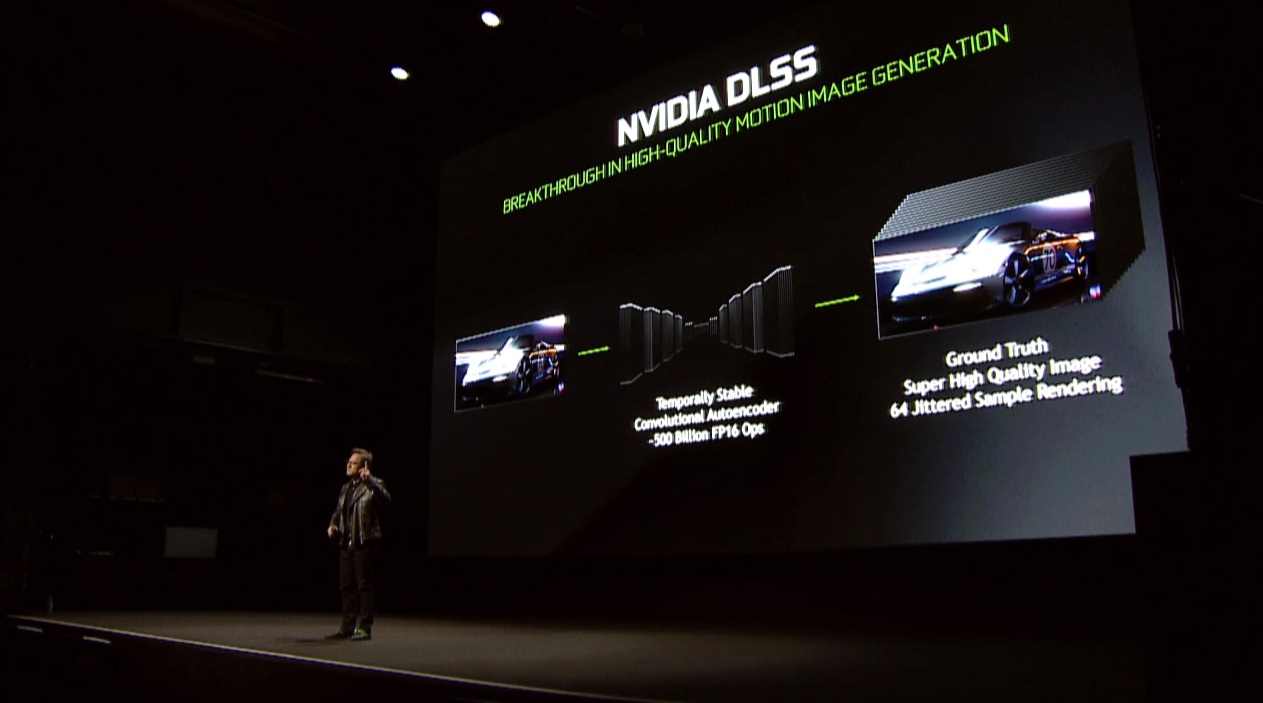

El pre-procesado para mejorar y elevar la calidad de imagen acabará llegando al mundo del videojuego «en un futuro» según el CEO de NVIDIA, una tecnología que se apoya sobre una red neural (inteligencia artificial) para conseguir la mejor calidad de imagen posible. Esta tecnología aplicada a juegos se conoce como NVIDIA NGX (Neural Graphics Framwork for AI Image Processing).

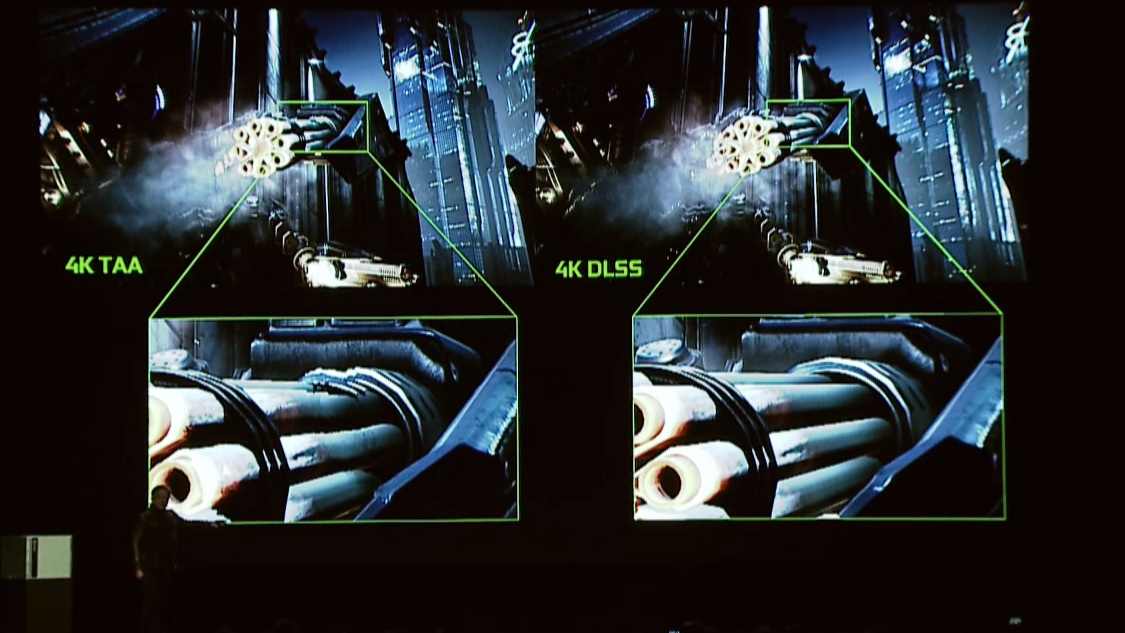

Como técnica de suavizado de bordes logra unos resultados fantásticos como podemos ver en la imagen que os dejamos a continuación. Es una captura de la demo Infiltrator, funcionando en resolución 4K bajo una única tarjeta gráfica a 60 FPS.

Pasamos a hablar de juegos concretos que están muy cerca de su lanzamiento y empezamos con Shadow of the Tomb Raider. El trazado de rayos aplicado a las sombras ofrece una mejora notable, como podemos ver en la imagen adjunta. Las sombras se generan en tiempo real y lucen mucho mejor.

No podía faltar Metro Exodus, la nueva entrega de la conocida franquicia de 4A Games que como sabemos apuesta por el trazado de rayos. Acompañamos unas imágenes comparativas en las que podemos ver las diferencias que marca el trazado de rayos aplicado a la iluminación global del juego.

Confirmado, Battlefield V aprovechará las posibilidades del trazado de rayos. NVIDIA GeForce RTX mejora de forja drástica la calidad de los reflejos como podemos ver en las imágenes adjuntas. En la escena del fuego reflejado en las ventanas la diferencia resulta aún mayor y en general marca un avance importante frente al renderizado tradicional. La calidad de los reflejos es sublime.

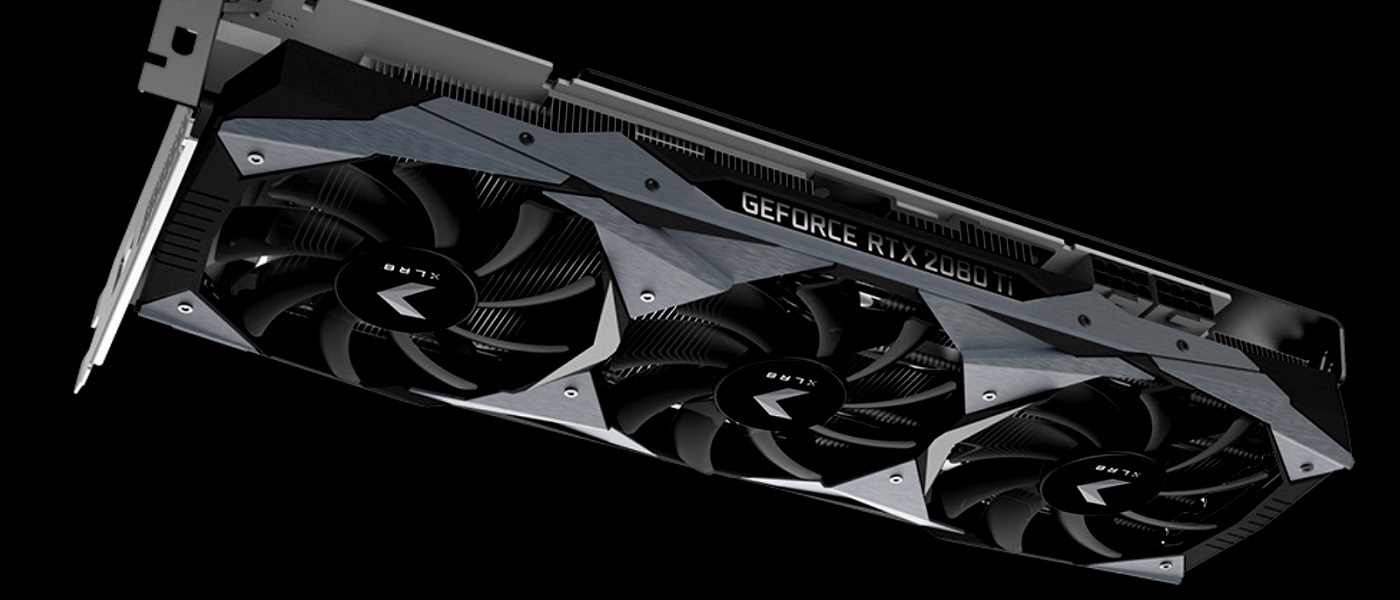

En la siguiente imagen podemos ver los juegos que soportarán GeForce RTX. Hay una lista considerable. Tenemos también las imágenes oficiales de los tres modelos que ha confirmado NVIDIA, os los dejamos al inicio donde acompañamos la descripción detallada de las RTX 2070, RTX 2080 y RTX 2080 TI.

Las GeForce RTX 2070, RTX 2080 y RTX 2080 TI se pueden reservar desde hoy mismo, pero no llegarán al mercado hasta el 20 de septiembre. En general hemos visto un aumento importante en términos de potencia bruta y a nivel tecnológico, gracias a la apuesta de NVIDIA por el trazado de rayos, pero también se ha elevado el consumo (TDP de 285 vatios) y el precio de venta frente a la generación anterior.

-

A FondoHace 1 día

A FondoHace 1 díaQuince cosas interesantes sobre Neptuno, un vecino muy lejano

-

GuíasHace 4 días

GuíasHace 4 díasTodo lo que debes saber sobre la memoria RAM en diez preguntas y respuestas

-

PrácticosHace 3 horas

PrácticosHace 3 horasQué placa base tengo, cómo descubrirlo segundos

-

NoticiasHace 4 días

NoticiasHace 4 díasWindows 3.1 le gana la partida a CrowdStrike