A Fondo

Xbox Two: Todo lo que sabemos y esperamos de esta consola

Hace unos meses publicamos un artículo dedicado a hablar de PS5, una consola de nueva generación que sucederá a PS4 y que está llamada a convertirse en uno de los máximos exponentes del futuro del hardware para videojuegos. Su contraparte será Xbox Two, una consola que como su propio nombre indica sucederá a Xbox One.

Aprovechando la la confirmación que ha ofrecido Microsoft en el E3 sobre el desarrollo de su consola de próxima generación hemos decidido hacer un artículo especial dedicado a repasar todo lo que sabemos (y esperamos) de Xbox Two. El enfoque va a ser idéntico al del artículo de PS5, ya que creemos que nos permite ofreceros una visión completa y bien definida de todas las claves de esa nueva consola, pero manteniendo al mismo tiempo un nivel asequible para que pueda ser disfrutado por todos nuestros lectores.

Tened presente que Microsoft no ha dado todavía el nombre de su consola de próxima generación y que por tanto Xbox Two es sólo un «apodo» provisional que utilizamos para referirnos a ella de forma simplificada. Es muy probable que los de Redmond decidan mantenerlo ya que encaja perfectamente como sucesor lógico de Xbox One, pero debido a los resultados que ha cosechado esta última también cabe la posibilidad de que decidan utilizar un nombre que «rompa» directamente con aquella para transmitir al consumidor un cambio y una renovación profunda.

Tras esta extensa pero necesaria introducción empezamos con desgranar todas las claves de Xbox Two. Espero que disfrutéis del artículo y no dudéis en dejar vuestra opinión en los comentarios.

Xbox Two: una mirada a sus cimientos

Con Xbox One en Microsoft llevaron a cabo un salto importante frente a Xbox 360, ya que abandonaron los procesadores PowerPC de IBM a favor de la arquitectura x86. Esto ha tenido consecuencias importantes que ya conocemos: ha simplificado los desarrollos multiplataforma y ha abaratado los costes a nivel de plataforma, colocando a consolas y PC prácticamente al mismo nivel.

La única diferencia importante existe hoy en día entre ambas es el sistema operativo y los kits de desarrollo. Una consola es una plataforma pensada principalmente para jugar que está limitada a una configuración de hardware concreta, mientras que un PC permite una cantidad enorme de configuraciones distintas, lo que implica mayores dificultades a la hora de optimizar adecuadamente para todas y cada una de esas posibles configuraciones.

Al igual que ocurrió con Xbox One la optimización que permitirán los kits de desarrollo será fundamental en Xbox Two. Esperamos que Microsoft repita con una versión optimizada de Windows 10 y que apueste por DirectX 12 como API principal para los juegos de su nueva consola, aunque no podemos descartar el desarrollo de una nueva versión específica para potenciar aún más las capacidades de Xbox Two.

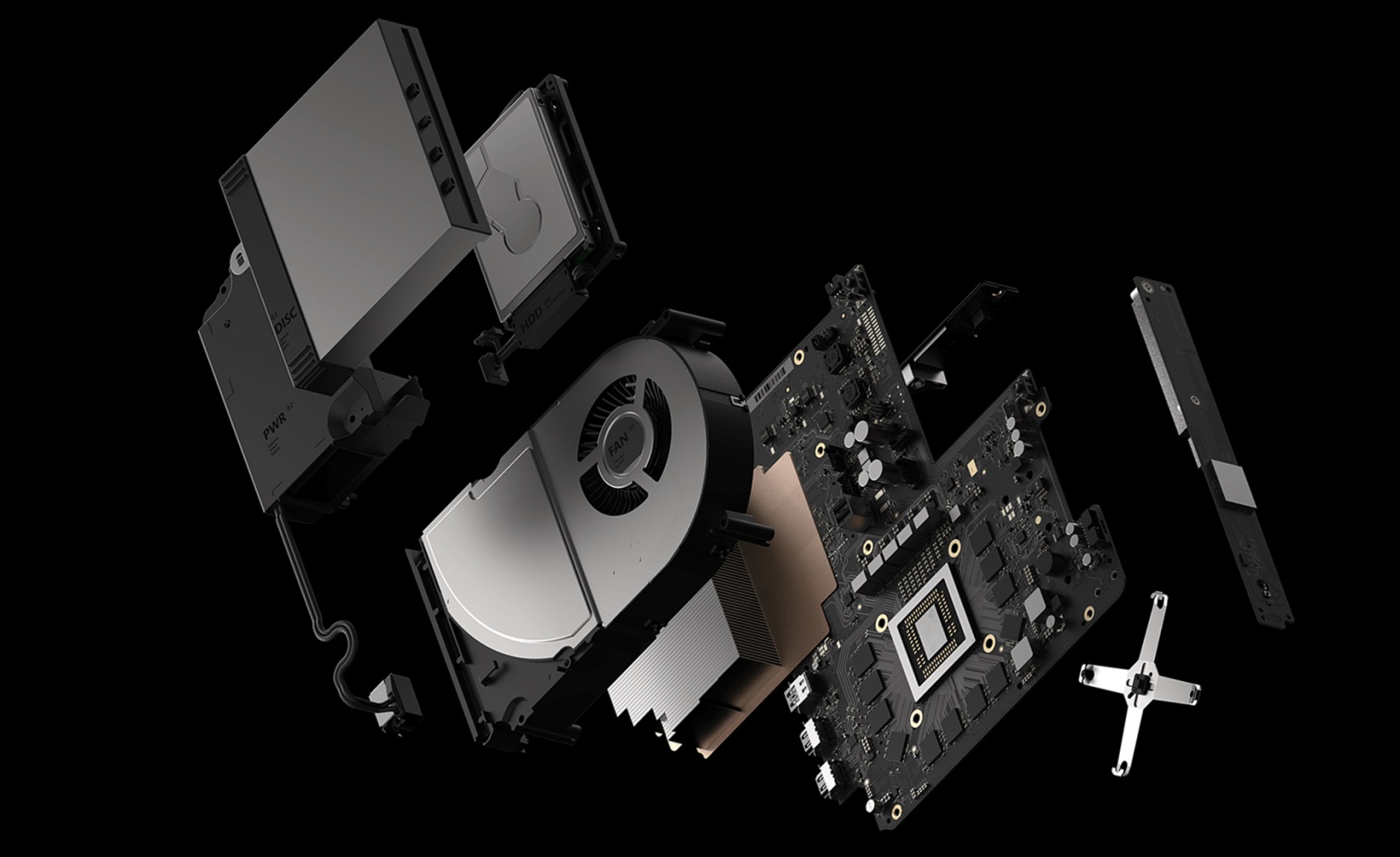

Volviendo al hardware los pilares claves de esta nueva consola quedarían tal que así:

- CPU con arquitectura x86.

- Solución gráfica de última generación fabricada por AMD.

- Arquitectura de memoria unificada.

- Unidad de almacenamiento incorporada. Seguramente un HDD para reducir costes.

A diferencia de lo que vimos en Xbox One, que utiliza 8 GB de memoria DDR3 unificada junto a un bloque de 32 MB de memoria eSRAM de alta velocidad. Como ya os hemos dicho en ocasiones anteriores esta configuración ha sido problemática y ha afectado negativamente al rendimiento de la consola, ya que la memoria DDR3 funciona a 2.133 MHz frente a los 5,5 GHz de la memoria GDDR5 de PS4. Esto significa que aunque cuenta también con un bus de 256 bits su ancho de banda total es de 68,3 GB/s frente a los 176 GB/s de PS4.

¿Y qué pinta la memoria eSRAM? Pues muy sencillo, esos 32 MB se utilizan a modo de caché para dar picos puntuales de ancho de banda que pueden alcanzar los 204 GB/s. Esto permite mejorar el rendimiento, pero complica los desarrollos y ofrece la misma solidez que una arquitectura más simple como la de PS4

Con Xbox One X los de Redmond corrigieron ese problema y dieron el salto a una arquitectura de memoria unificada que incluye 12 GB de GDDR5 a 6,8 GHz con un bus de 384 bits, lo que en conjunto se traduce en un ancho de banda de 326 GB/s. Obvia decir que la memoria eSRAM ya no está presente puesto que resulta innecesaria.

Pues bien es precisamente ésta última consola la que unida a las recientes filtraciones nos permite entrever las que serán las posibles especificaciones de Xbox Two.

Así quedaría configurada Xbox Two de Microsoft

Ya tenemos unas nociones básicas sobre las claves que servirán de base a Xbox Two, así que ahora toca ir concretando. Durante el E3 de este año el propio Phil Spencer ha reconocido que la descompensación a nivel CPU y GPU fue uno de los grandes errores de la presente generación de consolas, y que la retrocompatibilidad volverá a ser uno de los valores en su próxima generación.

Esto nos lleva a pensar que mantendrán grandes similitudes con Xbox One y Xbox One X para facilitar esa retrocompatibilidad, y que veremos un salto sustancial a nivel de especificaciones que sin embargo buscará un mayor equilibrio de componentes.

La idea de equilibrio es fundamental en una consola por varias razones:

- Se trata de una plataforma cerrada que tendrá que estar preparada para mantener el tipo durante una vida útil bastante larga (entre 6 y 8 años).

- Un desequilibrio de componentes puede no ser evidente en sus primeros años pero limitarla en gran medida en la segunda mitad de su ciclo de vida.

- Puede limitar las opciones a la hora de introducir renovaciones intergeneracionales, algo que ya ocurrió con PS4 Pro y Xbox One X, que tuvieron que utilizar un procesador Jaguar de AMD para evitar quebraderos de cabeza al mantener el soporte a PS4 y Xbox One.

Aunque todavía no tenemos confirmadas las especificaciones de Xbox Two tenemos una base clara en Xbox One X y mucha información relacionada con AMD y su trabajo en soluciones semipersonalizadas para consolas. Con ello, nuestros conocimientos y una dosis de intuición podemos ofreceros una estimación bastante fiable de las que creemos que serán las características base de la próxima consola de Microsoft:

- Procesador Ryzen personalizado en proceso de 12 nm con IPC idéntico al visto en los Ryzen 2000. Esperamos que sume ocho núcleos a una frecuencia aproximada de entre 3 GHz y 3,5 GHz.

- 16 GB de memoria GDDR6 a 14 GHz sobre un bus de 256 bits (como mínimo).

- Unidad de almacenamiento HDD de 1 TB o 2 TB.

- GPU Navi de AMD en proceso de 7 nm con un rendimiento similar al de una Radeon RX Vega 64.

Como ya ocurrió con Xbox One y Xbox One X una parte de esas especificaciones quedará reservada al sistema. Es pronto para anticipar nada, pero por asimilación con la generación actual dos núcleos de la CPU y al menos 2 GB de memoria estarían reservados y no serían accesibles por los desarrolladores.

Potencia estimada, fecha de lanzamiento y precio

Si se confirma esa configuración tendríamos una consola capaz de mover juegos actuales en resoluciones 4K a 60 FPS sin problema y bastante equilibrada, ya que su CPU podría «alimentar» sin problemas a su GPU y sería capaz de envejecer bastante bien durante los próximos años.

No obstante hay una cuestión importante, y es que el desarrollo de videojuegos lleva estancado varios años y no tenemos claro qué grado de evolución alcanzarán los desarrolladores con la llegada de las consolas de nueva generación. Es evidente que éstas seguirán siendo el techo técnico y que continuarán frenando al PC, pero lo que queremos decir es que puede que esas especificaciones que hoy nos parecen tan buenas acaben quedando obsoletas por un «acelerón» a nivel de desarrollo.

Son muchas las posibilidades que podrían entrar en juego en este sentido: animaciones más trabajadas, IA más avanzada, escenarios más abiertos y en general una ruptura con ese estándar que tanto se ha repetido en los juegos de la presente generación desde 2013.

Por otro lado no debemos olvidar que el lanzamiento de Xbox Two se espera para 2020. Esto quiere decir que todavía quedan dos años por delante y que para cuando llegue al mercado ya habrá salido al menos una nueva generación por parte de NVIDIA y de AMD, lo que significa que esa GPU Navi comparable a una Radeon RX Vega 64 ya no será gama alta sino gama media.

Haciendo un balance general creo que sí, que esta consola estará preparada para ofrecer juegos en 4K nativo con una buena fluidez y una calidad gráfica elevada, sobre todo gracias a la optimización por parte de los desarrolladores, pero no será ese «PC Killer» que ya intentan vendernos.

No podemos terminar sin hablar del precio. Xbox One X llegó al mercado con un precio de 500 euros, algo que para muchos analistas fue una locura, pero lo cierto es que en relación precio-prestaciones ha sido más que razonable. En el caso de Xbox Two creo que posicionará en un nivel similar al que os dimos al hablar de PS5, es decir que costará entre 500 y 600 euros.

-

GuíasHace 1 día

GuíasHace 1 día25 juegos gratis y con pocos requisitos para PC que ofrecen muchas horas de diversión

-

GuíasHace 4 días

GuíasHace 4 díasDisplayPort o HDMI, ¿Qué interfaz conviene usar en cada tarea informática?

-

AnálisisHace 3 días

AnálisisHace 3 díasRobot aspirador Eureka J12 Ultra, análisis: rapidez a gran escala

-

NoticiasHace 3 días

NoticiasHace 3 díasComprar una SSD será cada vez más caro