A Fondo

AMD Radeon RX 6900 XT, Radeon RX 6800 XT y Radeon RX 6800: especificaciones y precios

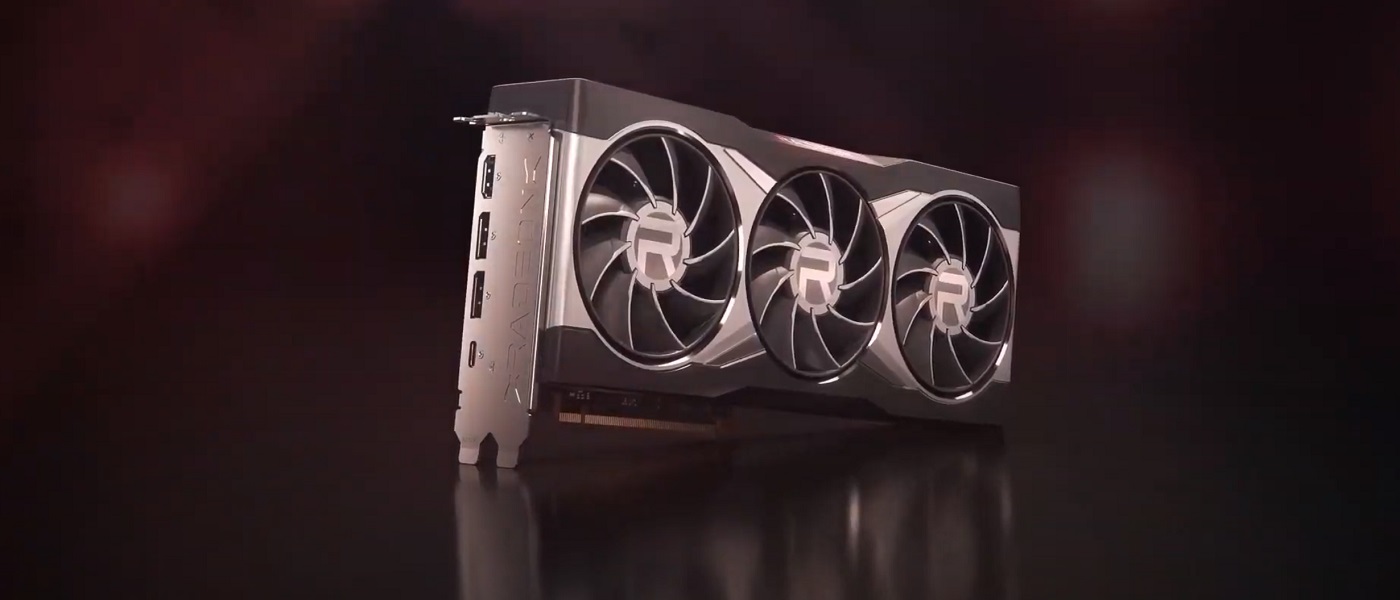

Hoy era el día marcado para la presentación de la nueva arquitectura RDNA 2, y AMD no ha defraudado. La compañía de Sunnyvale ha mostrado, al detalle, las nuevas Radeon RX 6900 XT, Radeon RX 6800 XT y Radeon RX 6800, tres tarjetas gráficas con las que AMD hará frente a las RTX 3090, RTX 3080 y RTX 3070 de NVIDIA.

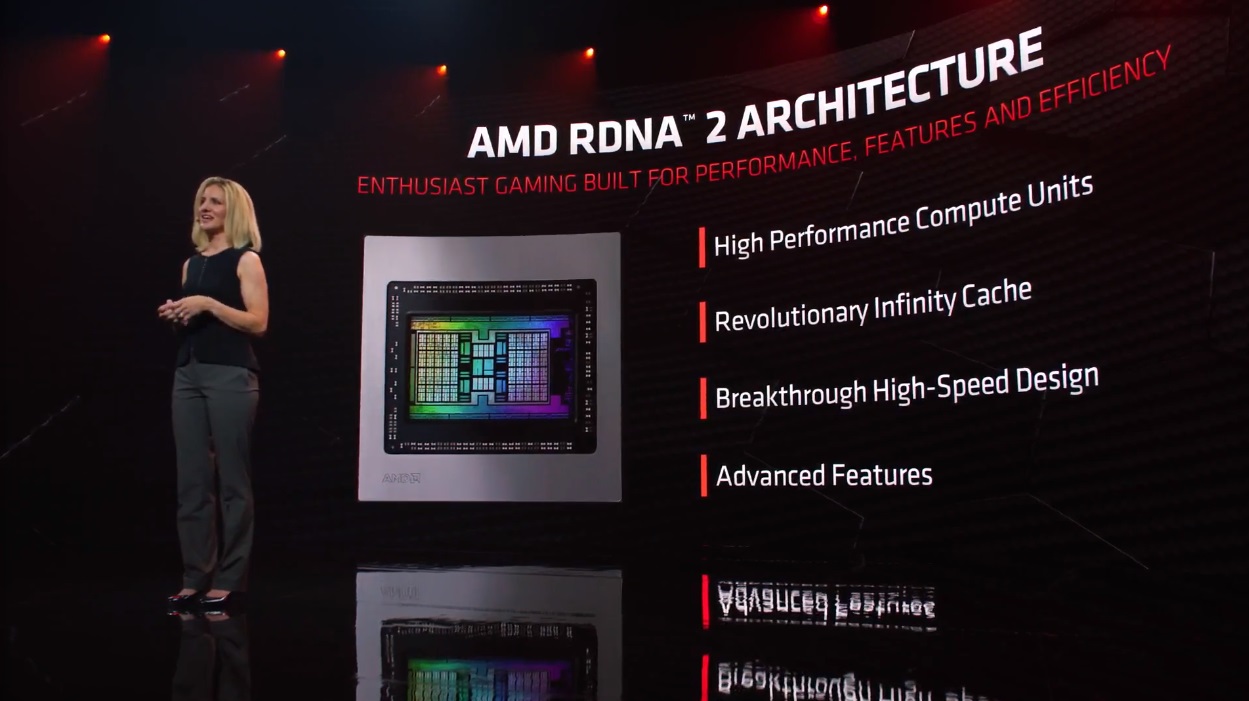

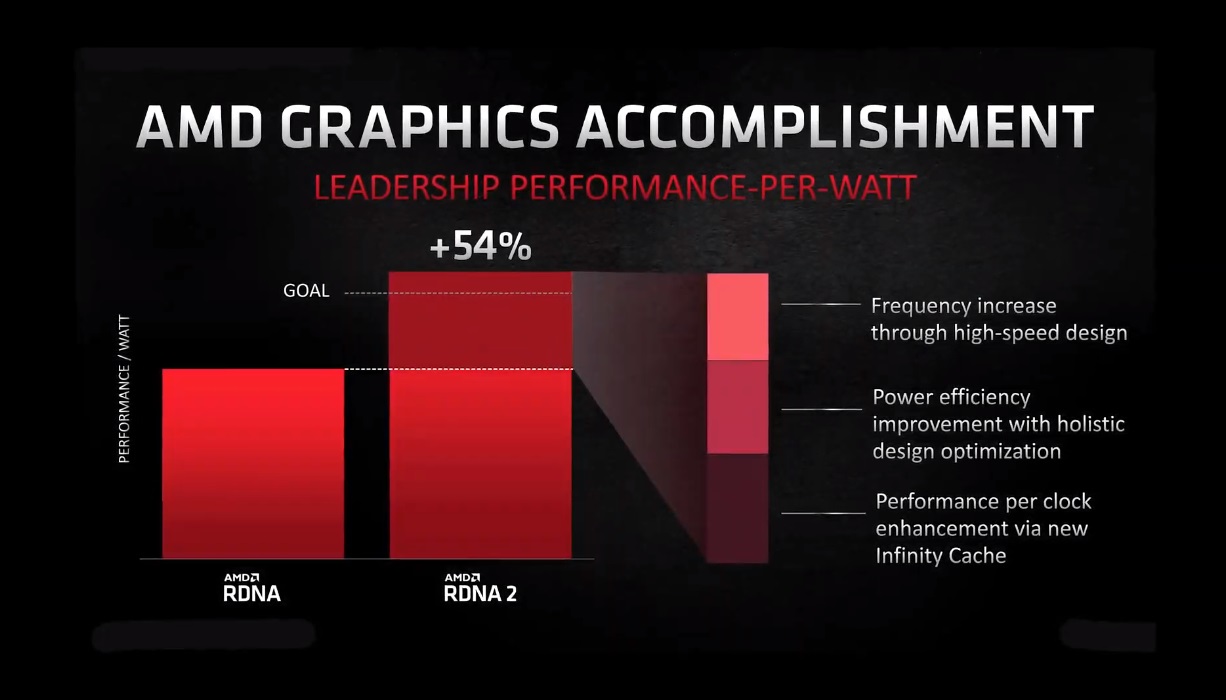

La arquitectura RDNA 2 marca un salto importante en términos de arquitectura frente a la arquitectura RDNA de primera generación. Los cambios introducidos a nivel de silicio se han traducido en una mejora de la relación rendimiento por vatio consumido del 54%, manteniendo el proceso de fabricación de 7 nm de TSMC que vimos en las RX 5700.

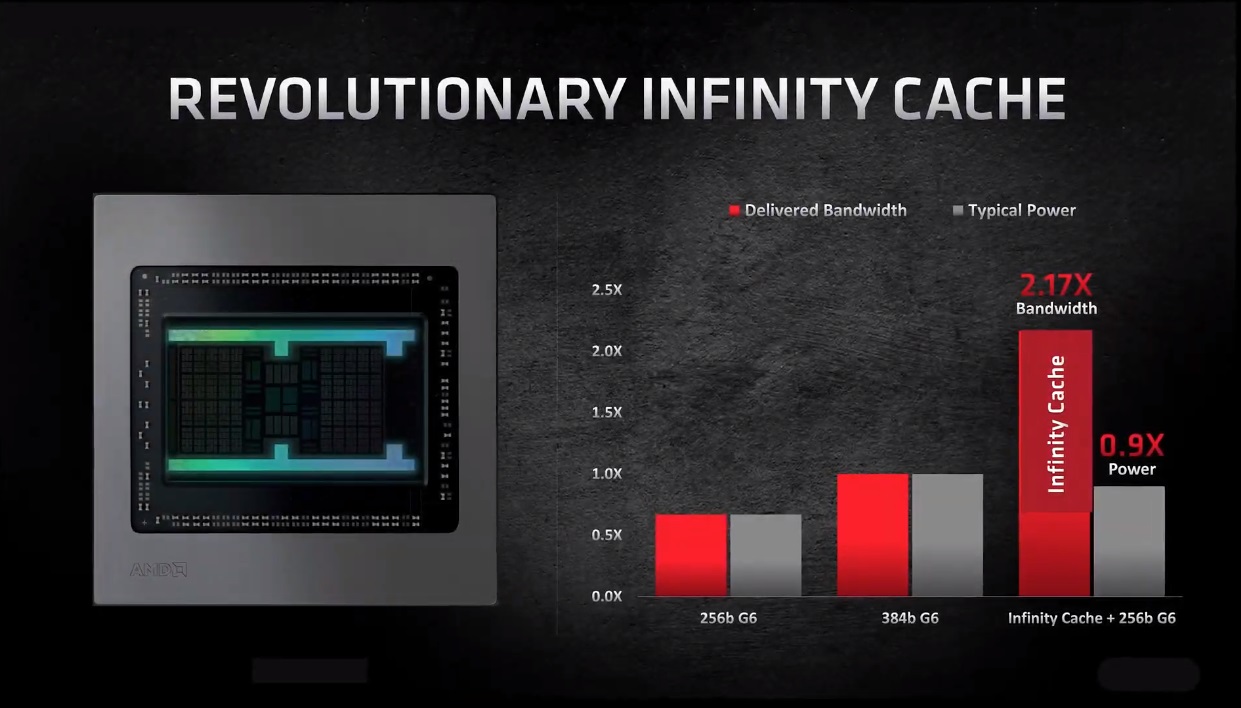

Entre las novedades más importantes que ha introducido AMD podemos destacar el rediseño de los pipeline (tuberías de renderizado), las mejoras en los procesos de movimiento de datos y la introducción de la tan rumoreada «Infinity Cache». Mención especial merece esta última, ya que ha permitido a AMD paliar el problema que supone unir un bus de 256 bits con memorias GDDR6 a 14 GHz en tarjetas gráficas de nueva generación de gama alta.

Como sabrán muchos de nuestros lectores, NVIDIA ha utilizado buses de 384 bits y de 320 bits en las RTX 3090 y RTX 3080, además de memoria GDDR6X, que alcanzan frecuencias de hasta 19,5 GHz. Para compensar esa diferencia de ancho de banda, AMD se ha inspirado en la enorme caché de los Ryzen 5000, basados en Zen 3, y ha integrado un total de 128 MB de memoria caché en las Radeon RX 6900 XT, Radeon RX 6800 XT y Radeon RX 6800.

La idea no es nueva, estoy seguro de que muchos de nuestros lectores recordarán que Xbox One y Xbox One S cuentan con 128 MB de memoria esRAM que actúa de una manera similar a la caché infinita que ha integrado AMD en las Radeon RX 6000. Su función es exactamente la misma, compensar el pobre ancho de banda que tienen ambas consolas debido a la combinación de memoria unificada DDR3 con un bus de 128 bits.

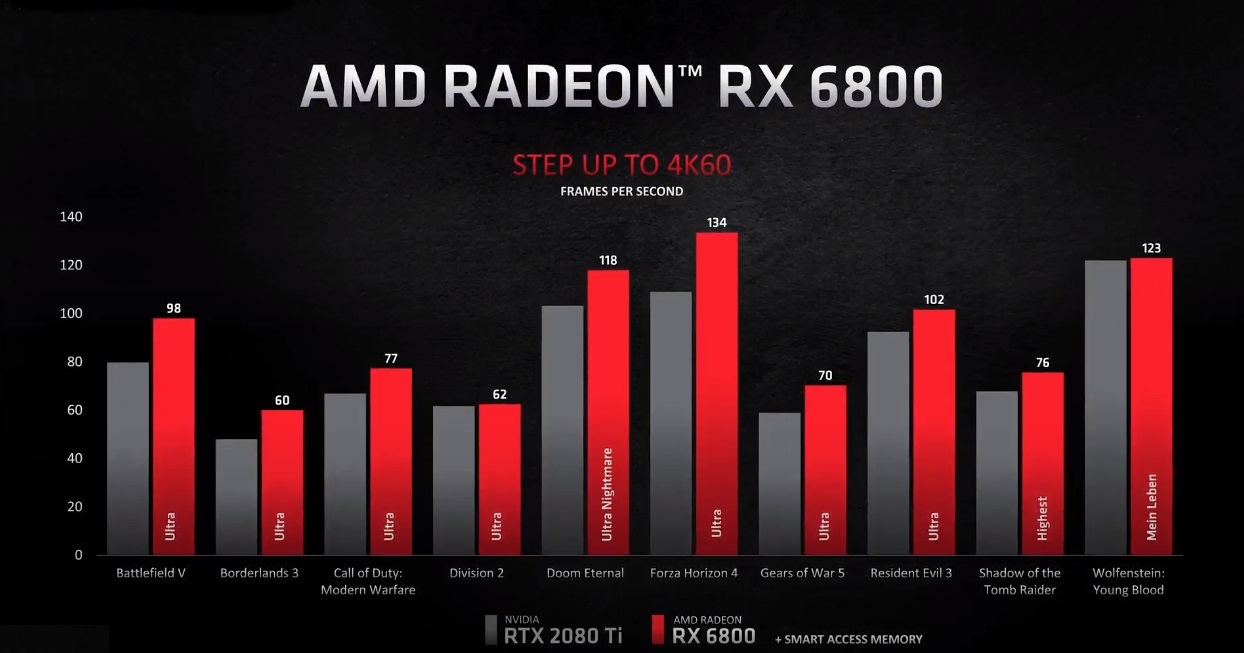

Viendo las pruebas de rendimiento que ha publicado AMD parece que esta idea ha funcionado a la perfección, pero durante todo el evento se han limitado a hablar de valores máximos con APIs «óptimas», y no han profundizado en los resultados de rendimiento todo lo que me habría gustado, así que prefiero esperar a ver pruebas que recojan valores medios con una perspectiva más realista.

AMD ha conseguido afinar al máximo las frecuencias de trabajo con la arquitectura RDNA 2, ya que ha superado sin problemas la barrera de los 2 GHz, y esto ha permitido mejorar considerablemente el rendimiento final de las Radeon RX 6900 XT, Radeon RX 6800 XT y Radeon RX 6800, aunque sobre ello vamos a profundizar en el siguiente apartado.

Por lo que respecta a las mejoras a nivel de plataforma, AMD ha dado un salto muy importante que se agrupa alrededor de las siguientes claves:

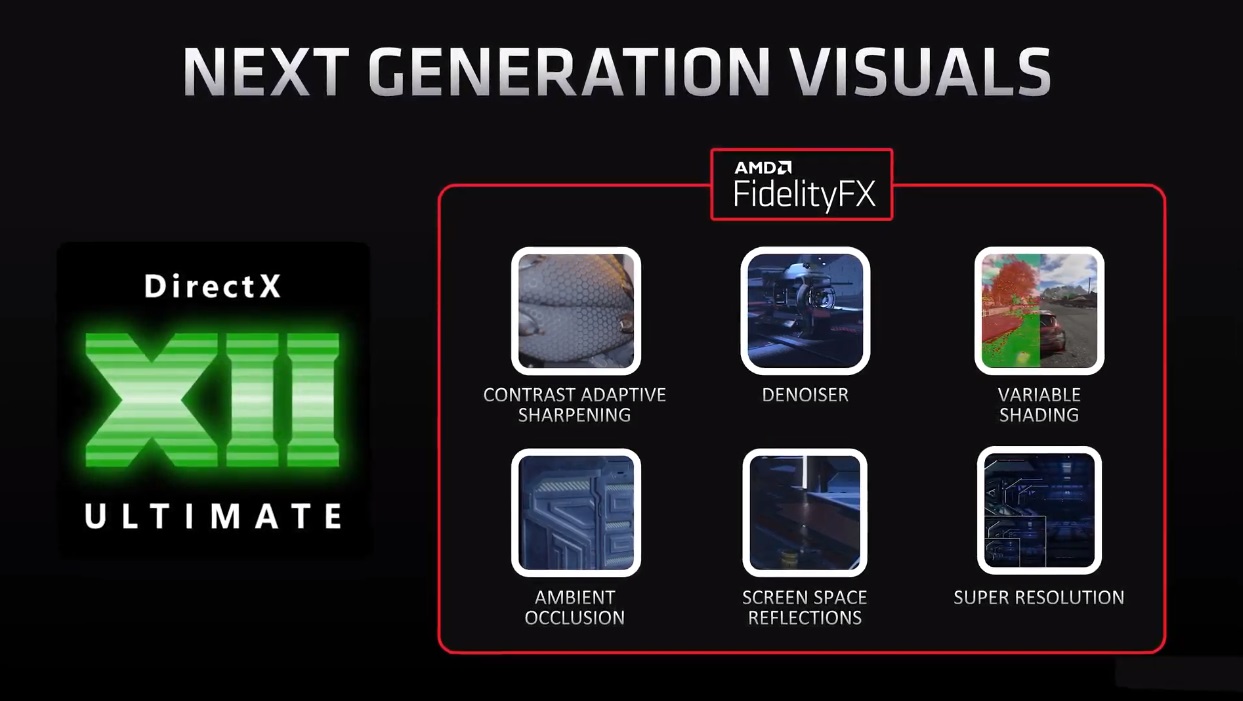

- Soporte total de DirectX 12 Ultimate: algo que ya os adelantamos en informaciones anteriores, y que se extiende a todo el conjunto de APIs de Microsoft, desde DXR 1.1 (trazado de rayos) hasta Direct Storage, que permitirá un aprovechamiento óptimo de los SSDs de alto rendimiento basados en el estándar PCIE y en el protocolo NVMe.

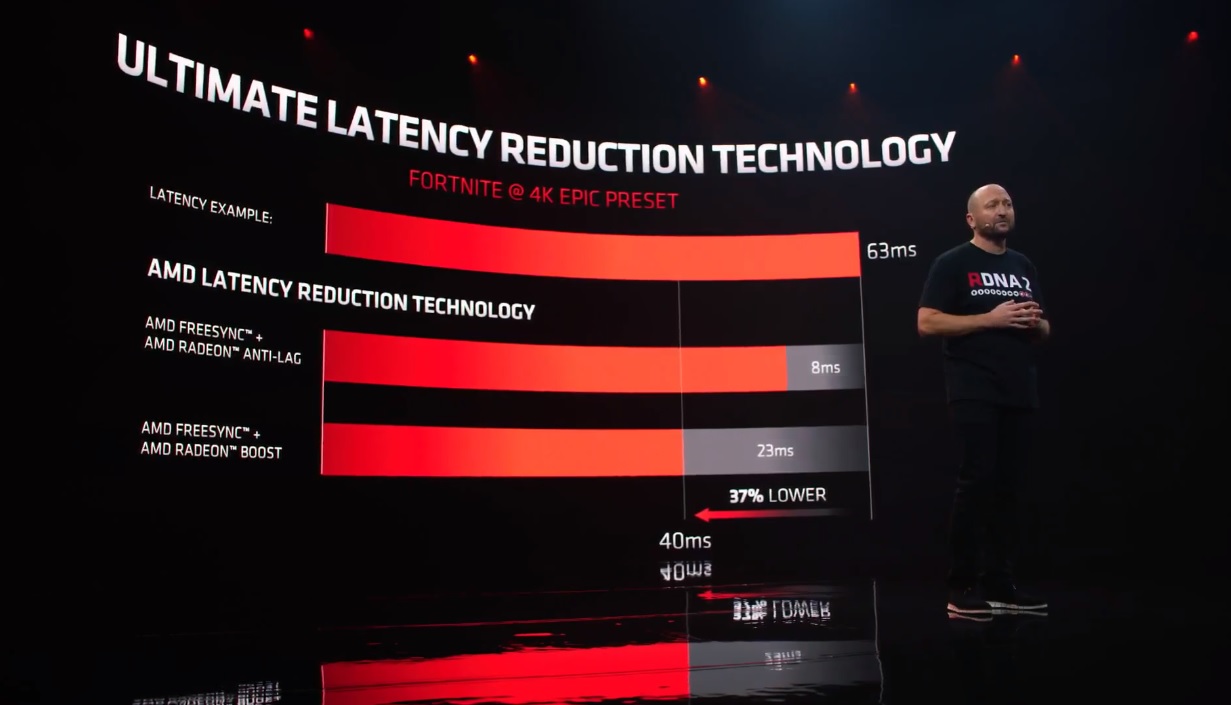

- Tecnología de reducción de latencia: vinculada a la tecnología FreeSync de AMD, cuyo objetivo es mejorar la experiencia de uso al reducir el retardo hasta en un 37%.

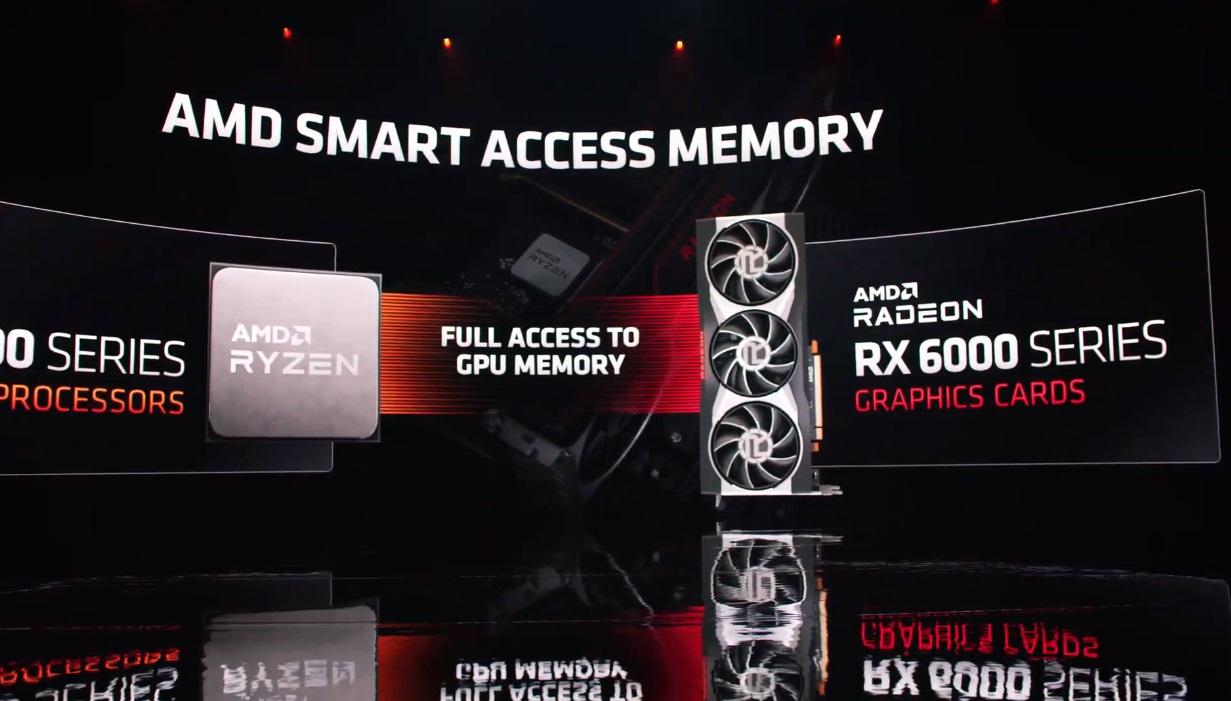

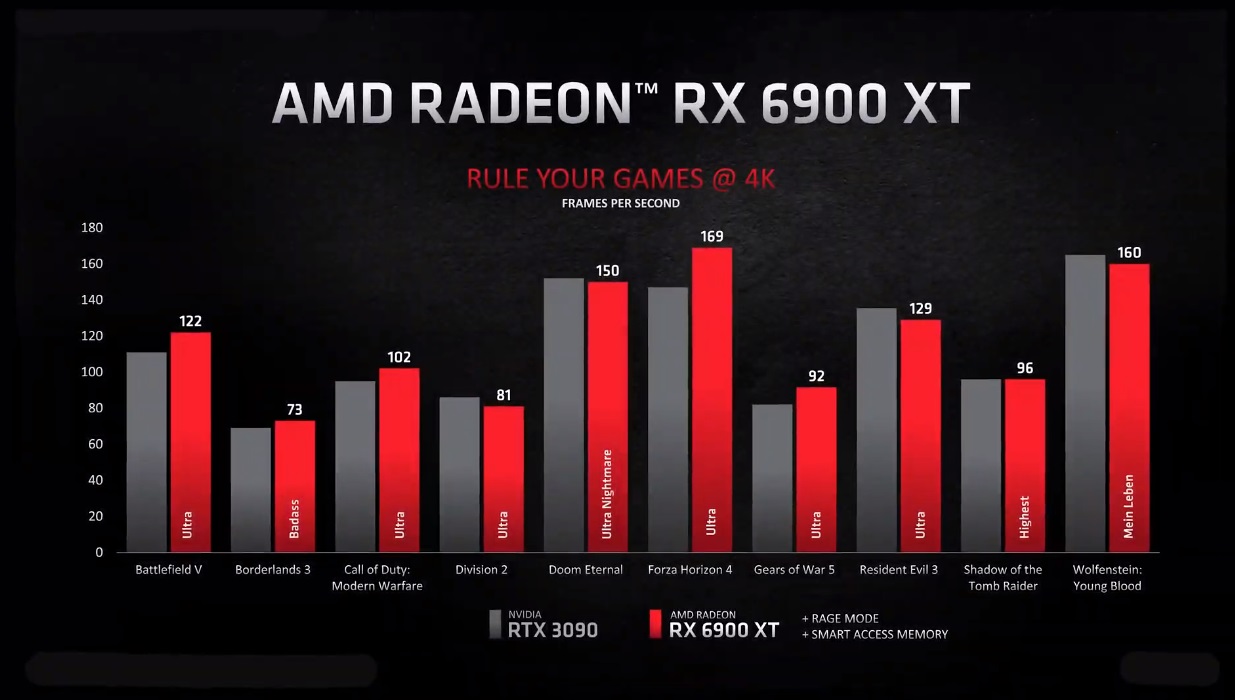

- «Smart Access Memory» y «Rage Mode»: que permiten dar un impulso al rendimiento mejorando la integración y la relación de trabajo entre una CPU Ryzen y una GPU Radeon RX 6000, y aplicando un overclock directo y agresivo con un solo clic. Dependiendo de cada juego, podemos ver una mejora de entre un 4% y un 13%.

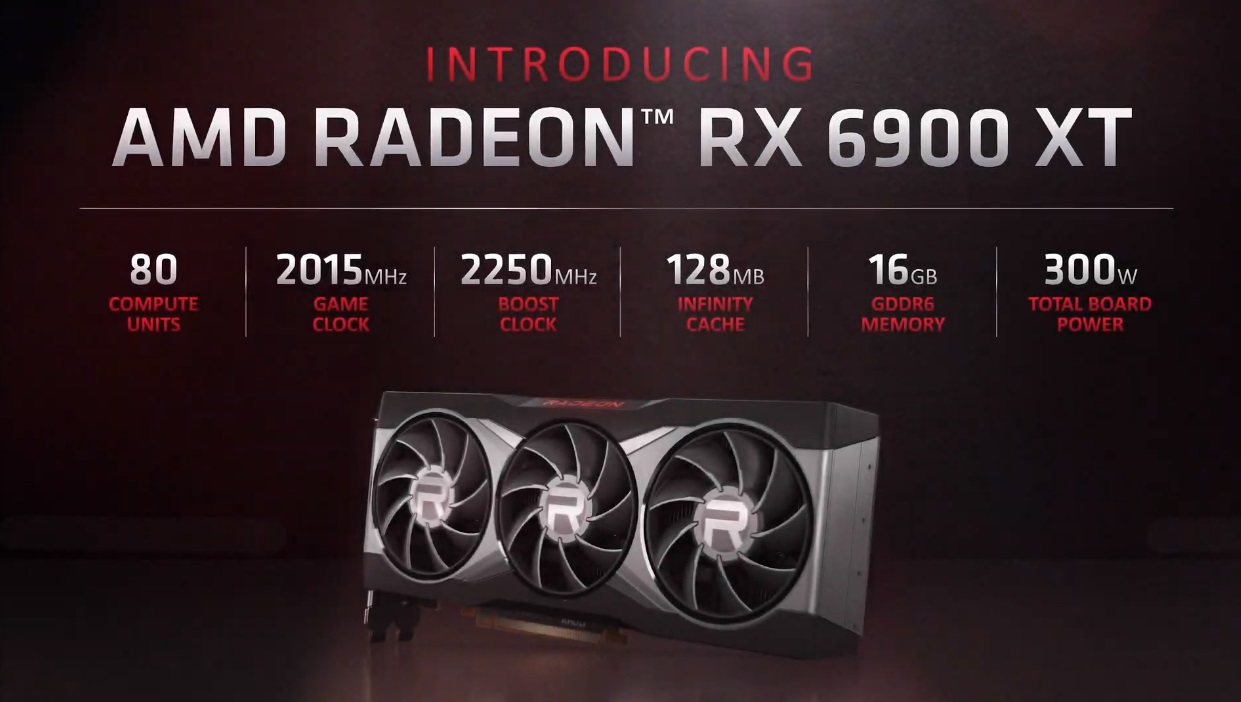

AMD vuelve a competir en lo más alto con la Radeon RX 6900 XT

Ha sido, sin duda, la mejor noticia de la tarde. Vuelve a haber competencia en todos los niveles, y eso es positivo para todos los usuarios, ya que significa que AMD ha logrado intercambiar golpes con NVIDIA en lo más alto, gracias a la Radeon RX 6900 XT, una tarjeta gráfica que no logra superar a la RTX 3090, pero que desde luego queda muy cerca de ella, y que ofrece un valor precio-prestaciones más atractivo.

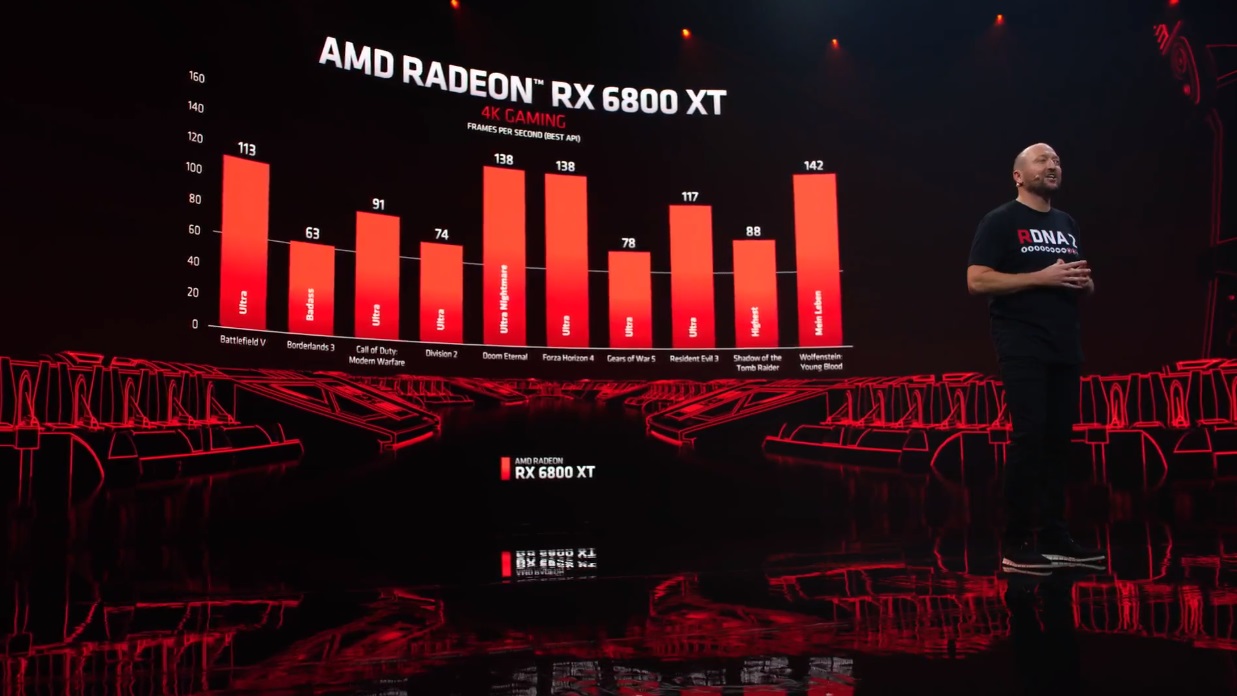

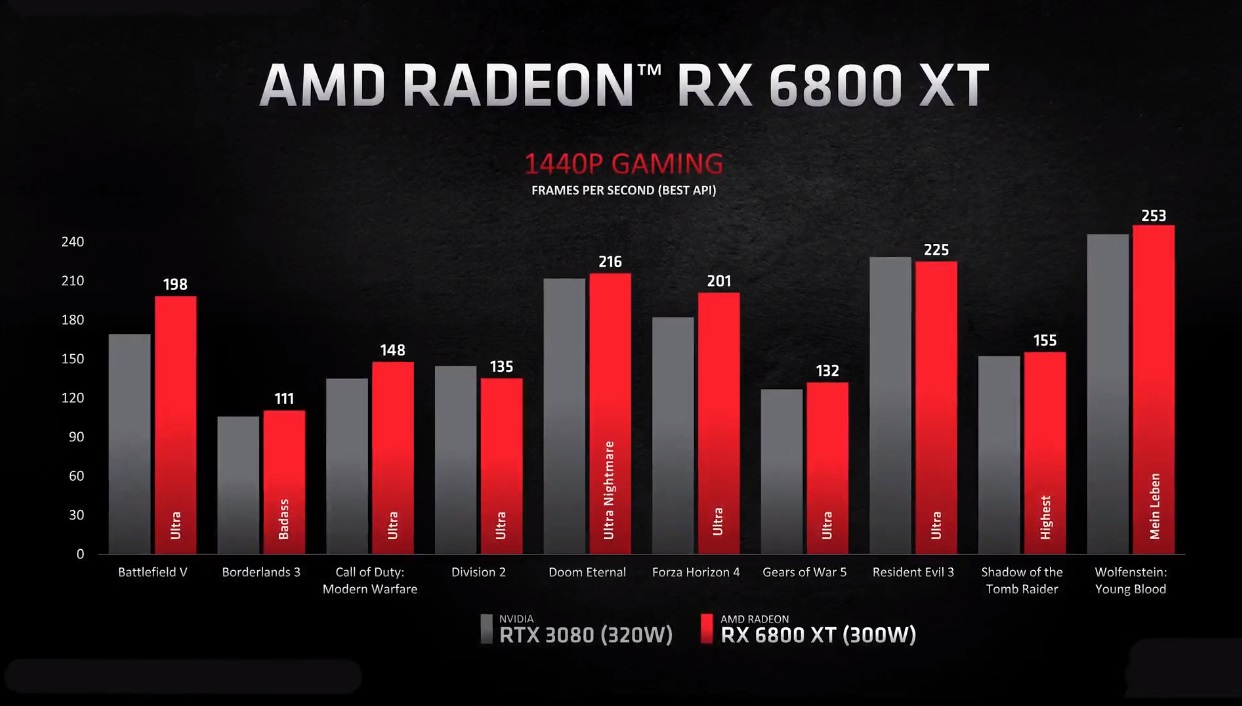

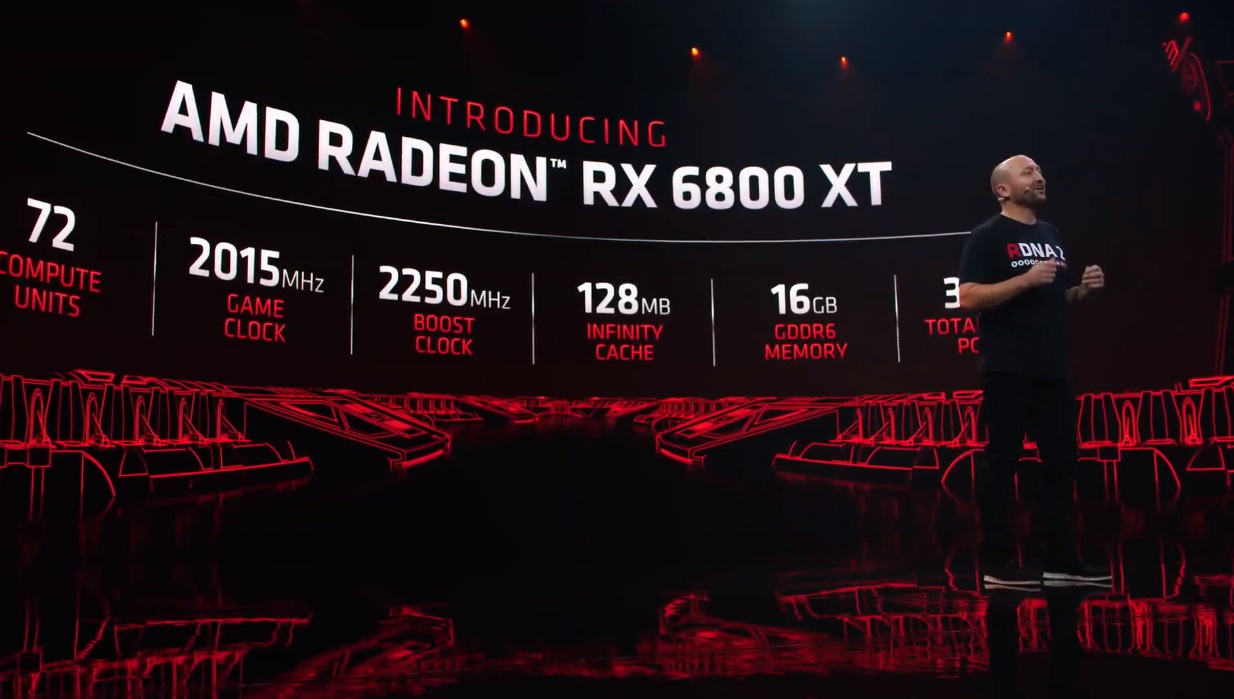

La Radeon RX 6900 XT posiciona en lo más alto, y justo por debajo de ella queda la Radeon RTX 6800 XT, una tarjeta gráfica que compite con la GeForce RTX 3080 y que ofrece un rendimiento similar a esta. Todavía no estoy totalmente convencido de que logre superarla de verdad, pero juega en su liga y ha quedado un poco por encima de mis expectativas iniciales. Obvia decir que me alegro de ello, ya que como siempre digo representa más competencia, y esto siempre es bueno para nosotros, los consumidores.

Con todo, no quiero dejarme llevar por el entusiasmo, y como he dicho prefiero esperar a ver cómo se comportan estas tarjetas gráficas en pruebas de rendimiento independientes con valores medios durante sesiones de juego realistas y sostenidas en el tiempo. No me entendáis mal, AMD ha superado mis expectativas y esto es genial, pero al final lo importante son los valores medios y quiero ver cómo se comportan, sobre todo por las dudas que me ha dejado el concepto de la caché infinita.

Echando un vistazo a la Radeon RX 6800 nos encontramos con una tarjeta gráfica de gama alta económica que promete un rendimiento muy interesante, ya que compite con la GeForce RTX 3070 de NVIDIA. AMD ha manteniendo la estrategia y ha ofrecido unas comparativas de rendimiento escuetas y poco claras, pero a priori parece que supera a la solución de NVIDIA.

Sin más preámbulos, vamos a ver las especificaciones, los precios y las fechas de lanzamiento de estas nuevas tarjetas gráficas. Al final se han cumplido, como podréis ver, casi todas las claves que vimos en este artículo.

Radeon RX 6900 XT

- Núcleo gráfico Navi 21 XTX en 7 nm.

- 80 CUs activas con 5.120 shaders a 2.015 MHz-2.250 MHz, modo normal y turbo.

- 320 unidades de texturizado.

- 80 unidades para trazado de rayos.

- 128 unidades de rasterizado.

- Bus de 256 bits.

- 16 GB de memoria GDDR6 y 128 MB de caché infinita.

- TBP de 300 vatios.

- Necesitará una fuente de 700 vatios y dos conectores de 8 pines.

- Precio: 999 dólares, unos 1.099 euros al cambio.

Esta tarjeta gráfica estará disponible a partir del 8 de diciembre con un precio de 999 dólares. No conocemos el precio de venta en España, pero al incluir impuestos superará los 1.000 euros.

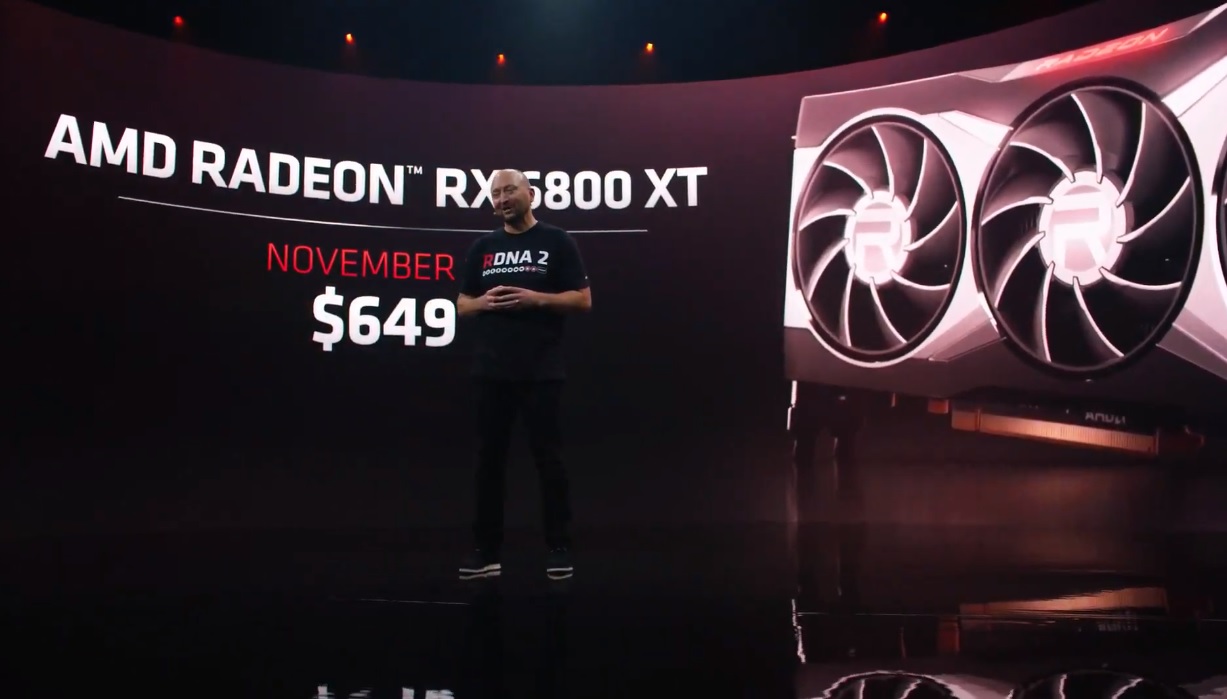

Radeon RX 6800 XT

- Núcleo gráfico Navi 21 XT en 7 nm.

- 72 CUs activas con 4.608 shaders a 2.015 MHz-2.250 MHz, modo normal y turbo.

- 288 unidades de texturizado.

- 72 unidades para trazado de rayos.

- 128 unidades de rasterizado.

- Bus de 256 bits.

- 16 GB de memoria GDDR6 y 128 MB de caché infinita.

- TBP de 300 vatios.

- Requiere una fuente de 700 vatios y dos conectores de 8 pines.

- Precio: 649 dólares, unos 699-729 euros al cambio.

Estará disponible a partir del 18 de noviembre con un precio de 649 dólares. En España su precio, impuestos incluidos, debería rondar los 699 euros.

Radeon RX 6800

- Núcleo gráfico Navi 21 XL en 7 nm.

- 60 CUs activas con 3.840 shaders a 1.815 MHz-2.105 MHz, modo normal y turbo.

- 240 unidades de texturizado.

- 60 unidades para trazado de rayos.

- 96 unidades de rasterizado.

- Bus de 256 bits.

- 16 GB de memoria GDDR6 y 128 MB de caché infinita.

- TBP de 250 vatios.

- Necesita una fuente de 600 vatios y dos conectores de 8 pines.

- Precio: 579 dólares, entre 599 y 629 euros al cambio.

Su lanzamiento se producirá también el 18 de noviembre, y tendrá un precio de 579 dólares. Su precio en España, tras aplicar impuestos, debería situarse entre los 599 y los 629 euros.

¿Y qué hay del trazado de rayos?

AMD ha confirmado su apuesta por el trazado de rayos al hablar de la integración total con DirectX 12 Ultimate, pero no ha profundizando en nada, es decir, no ha explicado cómo han integrado la aceleración de trazado de rayos por hardware en las RX 6000, y tampoco ha entrado a hablar de rendimiento.

Como recordarán nuestros lectores habituales, gracias a Microsoft, que hizo un desglose del SoC de Xbox Series X, supimos que la arquitectura RDNA 2 acelera el trazado de rayos por hardware recurriendo a una integración con las unidades de textura, dando forma a un sistema de recursos compartidos que limita notablemente el rendimiento.

El hecho de que AMD no haya querido profundizar en esta cuestión no es un buen síntoma, de hecho creo que refuerza lo que hemos ido diciendo durante los últimos meses, y es que la potencia en trazado de rayos de las Radeon RX 6000 podría estar muy por detrás de lo que vimos en las RTX serie 20. ¿Esto es negativo? Depende de la evolución que vaya a tener el trazado de rayos en los próximos años, pero ahora mismo, no.

A título personal reitero que AMD ha superado mis expectativas. Las Radeon RX 6000 prometen un rendimiento por encima de lo previsto inicialmente (destaca especialmente la Radeon RX 6900 XT en este sentido), vienen con 16 GB de memoria gráfica incluso en sus versiones más «económicas», y tienen un precio bastante ajustado. Veremos, eso sí, cómo se desenvuelven en pruebas independientes, ya que las comparativas de rendimiento que ha ofrecido AMD han sido demasiado planas, tanto que ni siquiera han dado números concretos al hablar de los resultados de las RTX 3090, RTX 3080 y RTX 3070.

-

GuíasHace 6 días

GuíasHace 6 días10 sitios web para descargar libros electrónicos gratuitos

-

A FondoHace 4 días

A FondoHace 4 díasZilog finaliza la producción de los Z80, un chip mítico

-

A FondoHace 2 días

A FondoHace 2 díasEmpiezan los Días Naranjas en PcComponentes, no te pierdas las mejores ofertas

-

AnálisisHace 6 días

AnálisisHace 6 días‘Ereban: Shadow Legacy’, juego de sombras