Al hablar de navegadores web, y en esto Google Chrome juega un papel más que relevante, el rendimiento es un aspecto muy importante y que preocupa...

Hay una serie de aplicaciones de terceros desarrolladores (algunas de pago) que prometen acelerar el arranque de Windows usando distintas técnicas de software. La realidad es...

La tecnología VBS es una función de seguridad que ayuda a proteger el sistema operativo frente al malware, pero como ya os hemos contado en ocasiones...

Ubuntu Linux (y otras distribuciones GNU/Linux) están ganando terreno en rendimiento frente a Windows 11 en equipos que usan la última generación de procesadores de Intel,...

Medir el rendimiento en juegos es, hoy por hoy, mucho más fácil de lo que era hace unos años. En este sentido es importante destacar el...

Mejorar el rendimiento de un PC sin tener que invertir dinero en nuevos componentes puede parecer un imposible, pero la verdad es que es algo que...

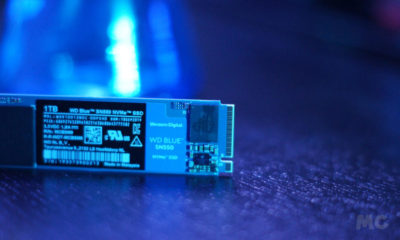

Microsoft ha lanzado un parche para solucionar la caída de rendimiento de las SSD en Windows 11. El parche está en fase de vista previo y...

Mejorar el rendimiento de Windows 11 será un área preferente de atención en las próximas actualizaciones del sistema operativo. Ya lo era antes del lanzamiento, pero...

Microsoft ya anunció que Windows 11 haría un mejor uso de los nuevos procesadores que Windows 10, pero ahora dice que también trabajará mejor con hardware...

El rendimiento de una SSD depende de varios factores como te hemos venido explicando en los múltiples artículos que te hemos venido publicando sobre el principal...

Los primeros detalles de Windows 11 se habían centrado en mostrar los aspectos visuales del próximo sistema operativo de Microsoft, la interfaz de usuario principalmente con...

Desde el pasado jueves he dedicado bastante tiempo a elaborar una prueba de rendimiento de Outriders completa y realista para poder compartirla con vosotros. No lo...

Capcom confirmó ayer los requisitos finales de Resident Evil Village, un juego muy esperado que, si todo va según lo previsto, llegará al mercado el próximo...

Cuando, para probarlo, me di de alta en Game Pass, obviamente instalé Xbox Game Bar, el complemento del sistema que, del mismo modo que GeForce Experience...

El rendimiento de un PC depende de tantos factores que es complicado marcar una norma fija para valorarlo. Sin embargo, hay una serie de aplicaciones que permiten...

La velocidad de tu Wi-Fi determina la rapidez con la que se descargará ese juego que esperas con tantas ganas, y también afectará a tu experiencia...

Hace una semana os contamos las novedades más importantes de Windows 10 May 2020 Update, la próxima gran actualización semestral que recibirá el conocido sistema operativo de...

Las máquinas virtuales son un método rápido, cómodo y seguro para ejecución de software. Muestra su valor en aplicaciones profesionales ante el incremento de las infraestructuras...

Apple está trabajando en una nueva característica para acelerar temporalmente el rendimiento de los MacBook, permitiendo a los usuarios actuar en el sistema de refrigeración y...

El rendimiento de los juegos en PC depende de muchos factores, aunque el más importante es la optimización que haya conseguido el desarrollador. Puedes tener un...

Bien arraigada bajo la exclusividad de Electronic Arts, la franquicia de juegos de Star Wars ha vivido unos últimos años de altibajos con el claro ejemplo...